TKDE'22 图对抗学习有何进展?

图数据无处不在,针对图算法的鲁棒性最近是个研究热点。来自Lehigh大学的研究人员在TKDE2022发布的《图数据对抗攻击与防御》,提供了100多篇关于图数据对抗攻防策略的论文的总体概况,并建立一个涵盖大多数图对抗学习模型的统一表述。

深度神经网络(DNNs)已广泛应用于图像分类、文本生成、音频识别和图数据分析等各个领域。然而,最近的研究表明,DNN很容易受到对抗性攻击。虽然在图像和自然语言处理等领域已经有了一些关于对抗性攻防策略的研究,但由于图数据的表示结构,仍然很难将学到的知识直接转化为图数据。鉴于图分析的重要性,在过去几年里,越来越多的研究试图分析机器学习模型对图数据的鲁棒性。然而,现有的研究考虑了图数据上的对抗行为,通常只关注特定类型的攻击,并带有特定的假设。此外,每一项工作都提出了自己的数学公式,这使得不同方法之间的比较很困难。因此,本综述旨在提供100多篇关于图数据对抗攻防策略的论文的总体概况,并建立一个涵盖大多数图对抗学习模型的统一表述。此外,我们还比较了不同的图攻击和防御及其贡献和局限性,并总结了评估指标、数据集和未来趋势。我们希望本次综述能够帮助填补文献空白,促进这一有前景的新领域的进一步发展。

https://www.zhuanzhi.ai/paper/29e1c75f455f6a20abadc48f86f43f06

1. 概述

近年来,深度神经网络(DNNs)在多个领域取得了显著的成功,从图像识别[55],自然语言处理[37],图数据应用[54],[69],[117],[118],[138],到医疗保健分析[90],脑电路建模[78]和基因突变功能[143]。深度学习具有优越的性能,已被应用于自动驾驶[9]、恶意软件检测[106]、身份识别[107]和异常检测[42]等多个安全和安全关键任务。然而,DNNs缺乏可解释性和鲁棒性,使其容易受到对抗性攻击。Szegedy等[111]指出了DNNs在图像分类中的敏感性。一个训练良好的DNN的性能可以被对抗性例子显著降低,这些例子是经过精心设计的输入,并添加了小幅度的扰动。Goodfellow等人[51]分析了这一现象,提出了一种基于梯度的方法(FGSM)来生成对抗图像样本。然后提出了不同的对抗攻击策略,以演示DNNs在各种设置[8],[19],[142]中的漏洞。例如,黑盒对抗攻击后来基于可移植性[81],[93]和来自DNN模型[5],[16]的查询反馈进行了探索。一些防御和检测方法也被采用来减轻这种对抗行为[86],[102],而各种自适应攻击继续被提出,表明一般来说检测/防御是困难的[3],[18]。

虽然对抗性攻防的研究越来越多,但目前的研究主要集中在图像、自然语言和语音领域。尽管图数据在许多实际应用中很重要,但对图数据的研究工作仍处于初级阶段。例如,在信用预测应用中,对手很容易通过与他人增加友谊连接来伪装自己,这可能会造成严重的后果[33]。与非图数据相比,图数据的对抗分析有几个独特的挑战:1)与像素值连续的图像数据不同,图结构是离散值的。在离散空间中设计一种有效的生成对抗例的算法是很困难的。2)对抗性扰动被设计成在图像域中人类无法察觉的,因此可以强制一个特定的距离函数,例如对抗性和良性实例之间的p范数距离要小。然而,在图数据中,如何定义“不可感知的”或“细微的扰动”需要进一步的分析、测量和研究。

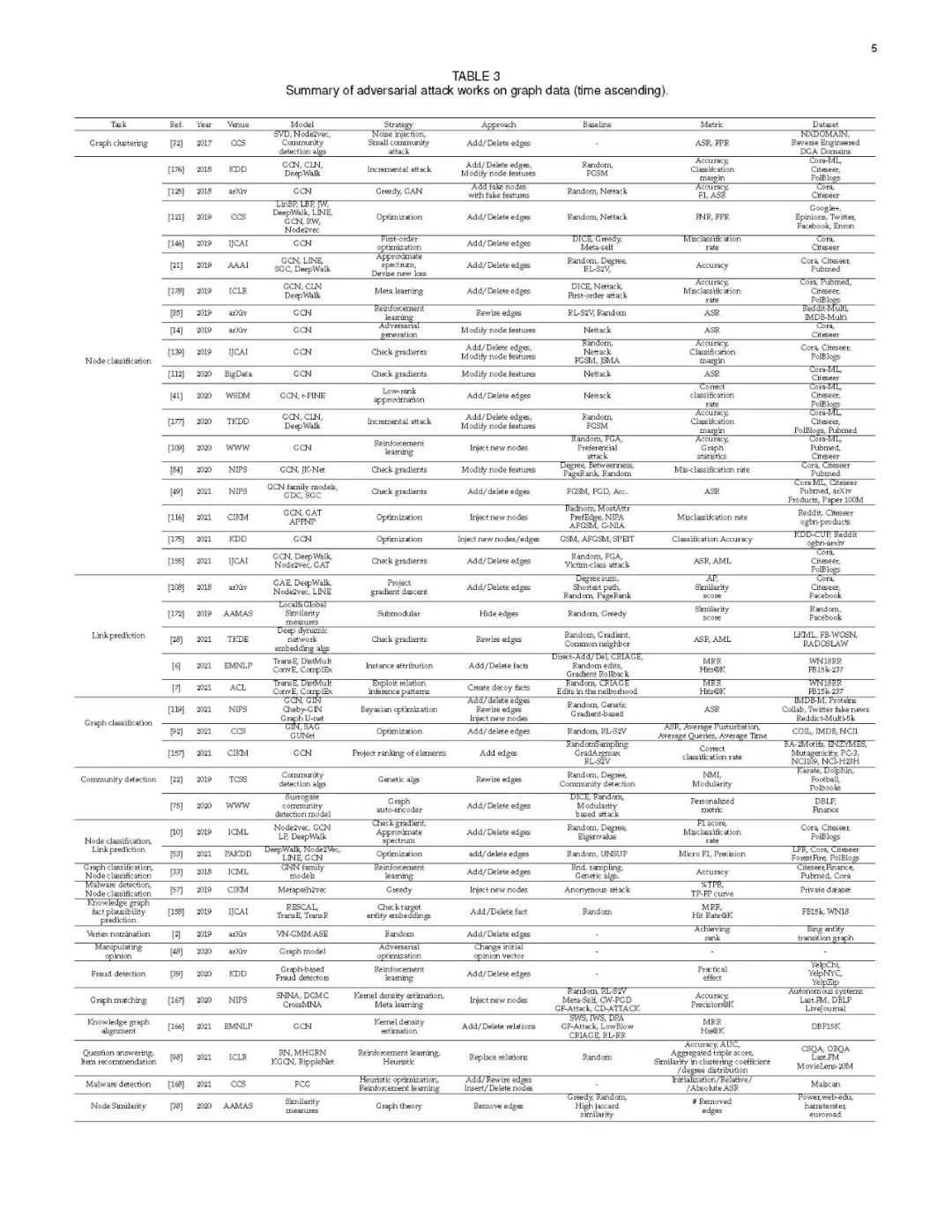

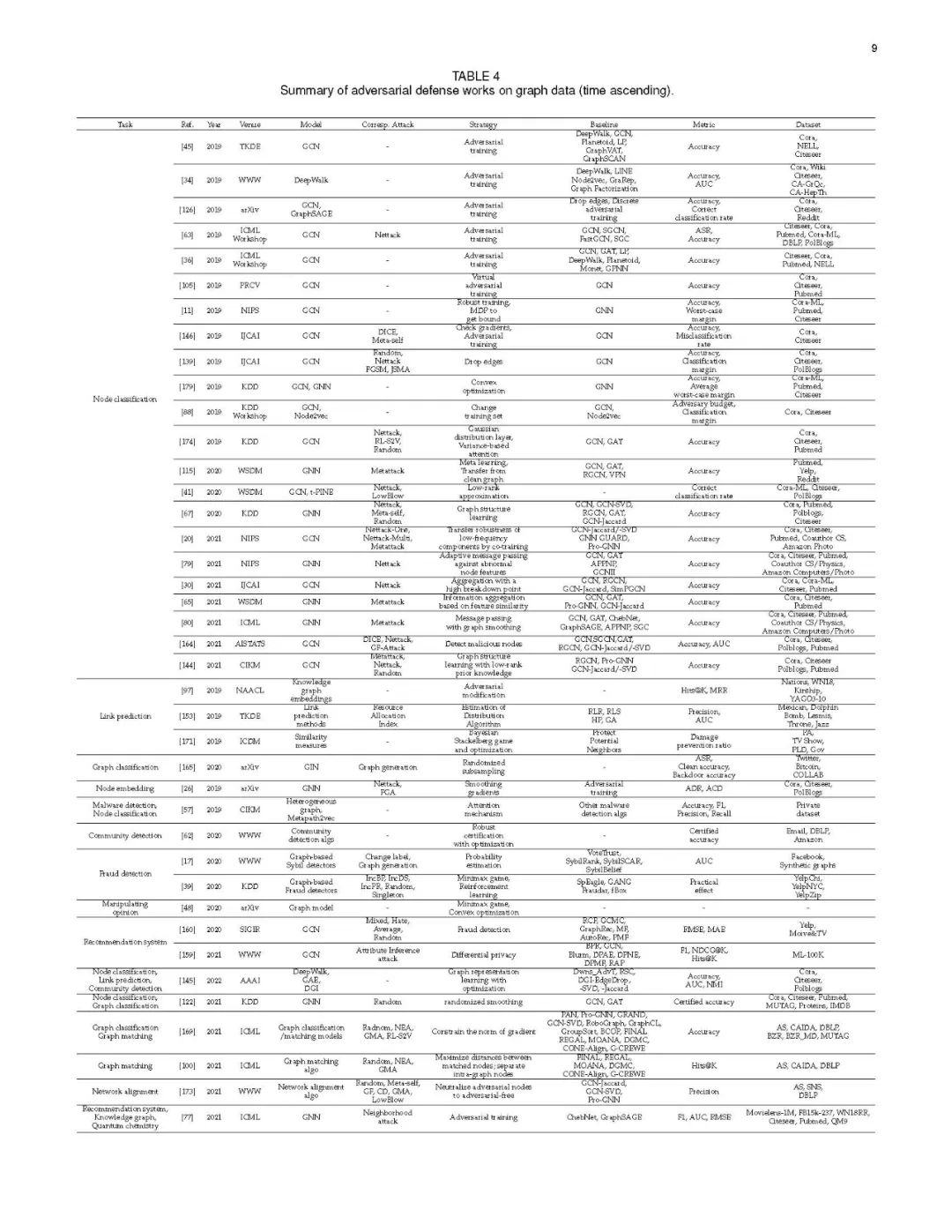

鉴于图在大数据背景下应用的重要性以及图神经网络(GNNs)的成功使用,GNNs的鲁棒性吸引了学术界和工业界的极大兴趣。近年来,人们对一组GNN模型的对抗性攻击和防御进行了很多研究。本文的目的是对现有的关于图数据的对抗学习文献进行综合分类,开发一个框架来统一大多数现有的方法,并探索未来的趋势。所有相关的攻击和防御研究都列在表3和表4中,主要基于任务、策略、基线、评估指标和数据集。尽管在过去三年中发表了100多篇论文,但到目前为止仍有一些挑战没有得到解决,我们在此贡献总结和介绍如下。

全面的理解。据我们所知,这项调查是第一次尝试对图数据的对抗性攻击和防御的文献进行深入和全面的理解。[21],[29],[64],[66],[72],[151],[174]的后续研究都引用了它。本文不仅为GNNs背景下的关键对抗性攻防技术提供了广阔的视角和指导,还解释了与非梯度和非模型方法相关的许多观察结果,并对未来的发展方向提出了见解。

在线更新的资源。我们创建了一个包含所有相关作品的开源资源库,并在过去两年对其进行了更新。该库包含所有相关论文和相应代码的链接,这使研究人员更容易使用和跟踪最新进展,并可作为该领域的基准库。然而,这些论文中的许多是预印本和报告,提供了研究结果的预览,我们将继续跟踪它们,并将任何更新编入相应的知识库。我们希望这个资源可以促进对这一重要话题的进一步研究,并继续照亮未来研究和发展的各个方面。

定义统一的问题。虽然针对图数据的攻击和防御策略多种多样,但还没有统一的方法来描述它们之间的关系和属性;每个模型似乎都是一种独特方法的结果。为了便于理解现有模型和高效开发未来技术,有必要建立良好的基础。在本文中,我们率先建立了一个统一的表述和定义,系统地分析了所有针对图数据的对抗攻击模型。与攻击不同的是,对图数据的防御通常超越对抗学习,我们根据它们的独特策略提供额外的类别。

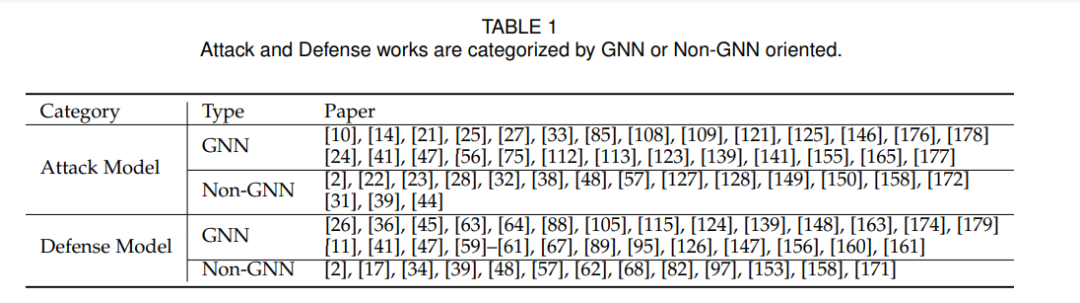

图数据对抗分析的分类学。到目前为止,已有一百多篇论文研究图表数据的对抗分析。与图像数据和文本数据相比,图数据的分析由于图结构和任务的不同而更加复杂。列出所有的论文可以帮助读者快速理解不同研究之间的相似和差异,但不是直观的。为此,我们基于GNN和Non-GNN方法对已有的研究成果进行了总结,旨在帮助读者轻松找到最相关的论文。我们在表1中展示了我们的分类法的更多细节。

数据和指标。由于以往攻防工作的目标和使用的数据不同,不同研究的结果很难进行比较。目前,还没有人能直接回答“在这个领域,哪种攻击或哪种防御是最好的基准测试?”缓解这一问题的唯一方法是像其他领域一样建立一个基准[35],[120]。为此,我们不仅根据不同的标准为以前的方法开发分类法,而且还总结了经常使用的相应数据集和指标。我们希望这项研究可以为社会各界在这一领域的未来研究和模型的实际选择奠定一个基准。

本综述的其余部分组织如下:第2节提供了图数据和常见应用的必要背景信息。第3节给出了统一的问题表述,并讨论了现有的针对图数据的对抗攻击工作。第四节讨论了现有的图形数据防御工作。第5节总结了不同研究中使用的评估和攻击指标。第6节描述了每个数据集的详细信息,并总结了跨数据集的现有工作。最后一节是本文的总结。

2. 图数据的对抗性攻击

在本节中,我们给出了图数据对抗性攻击的一般定义和分类,然后介绍了不可感知度量、攻击类型、攻击任务和攻击知识级别。

3. 图数据的对抗性防御

近年来,针对对抗攻击的密集研究也引发了对抗防御的研究。在这里,我们调研了这方面的现有工作,并将它们分为两个流行的类别: 对抗性训练和攻击检测。在它们之后,我们使用额外的“其他方法”小节来总结其余不属于这两个一般类别的方法。