认知智能

大家好,今天我和大家分享一下认知智能的进展和思考。

人工智能深深地改变了人类生活。从应用上看,我们现在已经能实现人工智能在自动驾驶、安防、自动翻译、医疗诊断、个人助理等任务上的应用。这些应用背后依赖图像识别、语音识别、自然语言处理、知识图谱、搜索和推荐等技术。

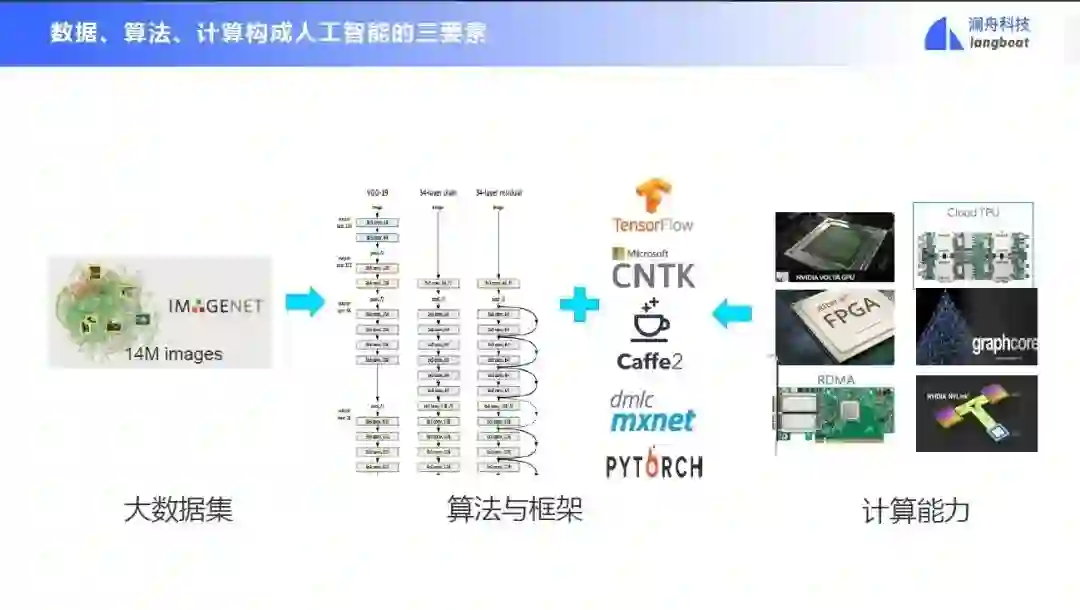

数据、算法、计算构成人工智能的三要素,三者缺一不可。

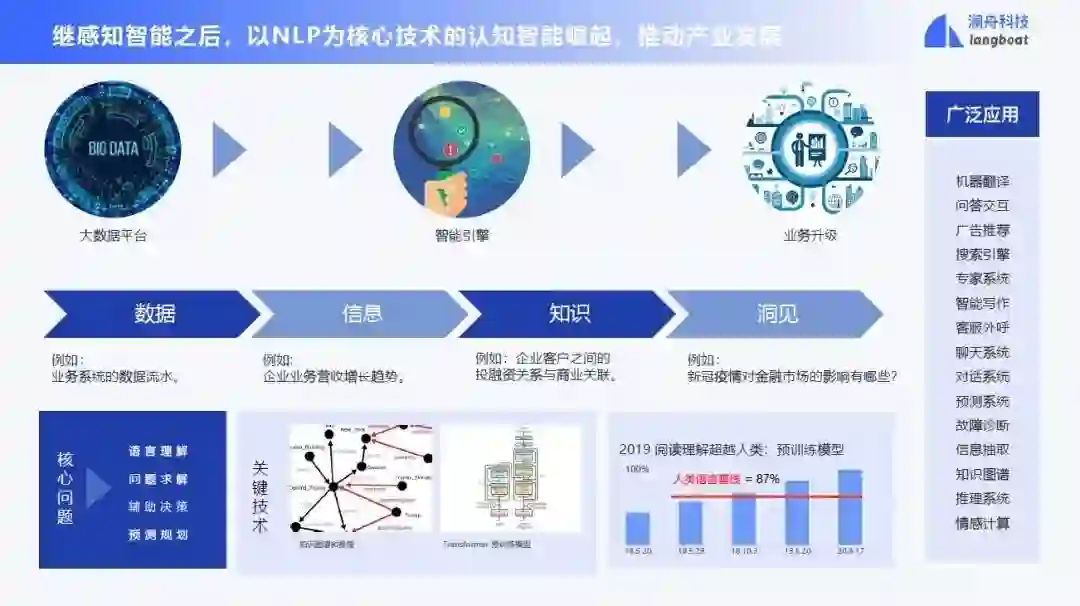

继感知智能之后,以 NLP 为核心技术的认知智能崛起,将推动产业发展。

神经NLP

前面提到自然语言处理可以做很多应用,下面介绍神经自然语言处理的核心技术。

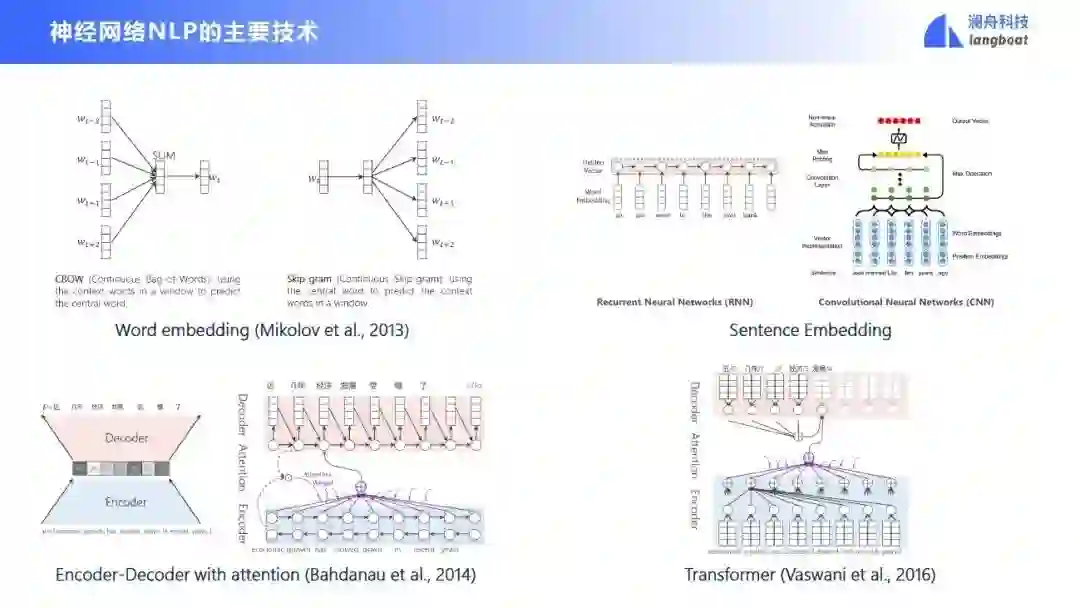

- 神经网络NLP的主要技术

用神经网络做NLP要解决一些核心问题,首先是词怎么表示。我们实际上是用多维向量来代表一个词的语义。词的语义怎么学呢?2013年Mikolov提出了一个叫词嵌入的技术。他利用一个大规模的语料库去学习每一个词的多维向量表示。学习目标是利用周围的词去预测当前词,或者利用当前词去预测周围的词。

进一步地,我们想得到一个句子的多维向量表示,具体的方法有:把句子中每个单词的向量叠加起来,或者用卷积/循环神经网络进行句子建模。获得句子的向量表示之后,我们可以做句子间的转换任务,比如机器翻译(把中文句子转为英文句子)、自动文摘(把文档转为摘要)等。这种转换可以使用encoder-decoder模型架构实现。

为了进一步提高转换的效果,人们提出了attention 模块,在转换的时候区分哪些词更重要,哪些词不重要。在此基础上提出的 transformer 模型显著提高了机器在翻译等任务上的表现。

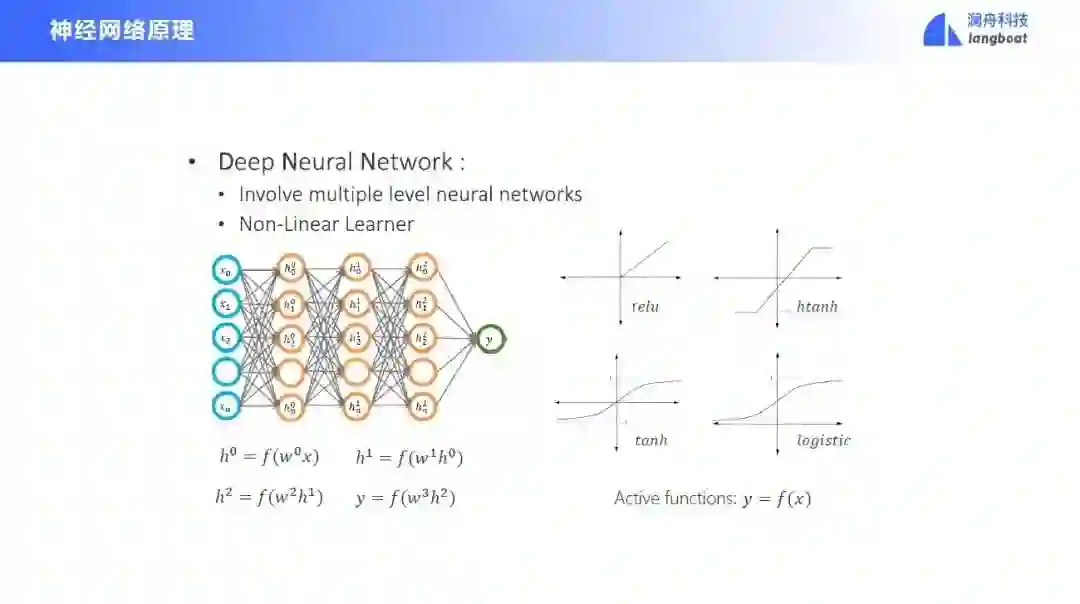

下面我们快速回顾一下神经网络原理。神经网络有一个输入层、一个输出层,中间还有一些隐层。每个隐层结合了前面的所有的输入信号,并进行加权,输入激活函数中得到一个结果,再输入下一层。最后走到输出层后,会得到一个预测结果,与正确结果进行比对,得到损失函数。然后将损失的梯度回传到整个神经网络,进行参数的更新。

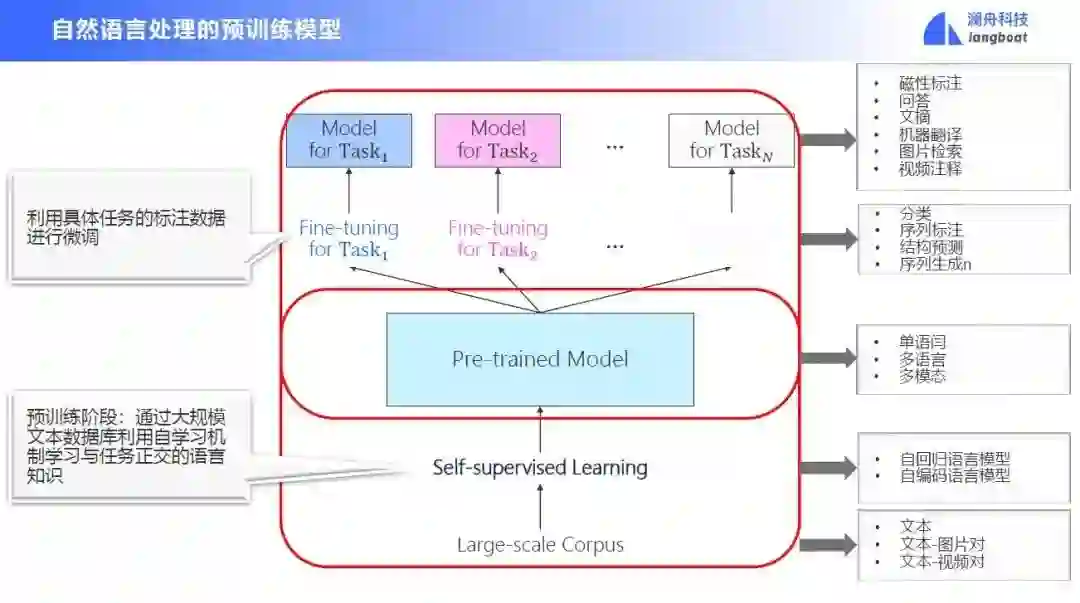

- 自然语言处理的预训练模型

将神经网络原理和一些神经网络架构结合,我们可以进行大数据的预训练。预训练需要大规模的语料库,让模型在其基础上进行自监督学习,学习每个词的语义向量表示。得到预训练模型后,我们可以结合具体的下游任务对模型进行一些微调,使其适配下游任务的要求。用这一套技术,几乎可以解决所有语言、所有场景下的所有任务。

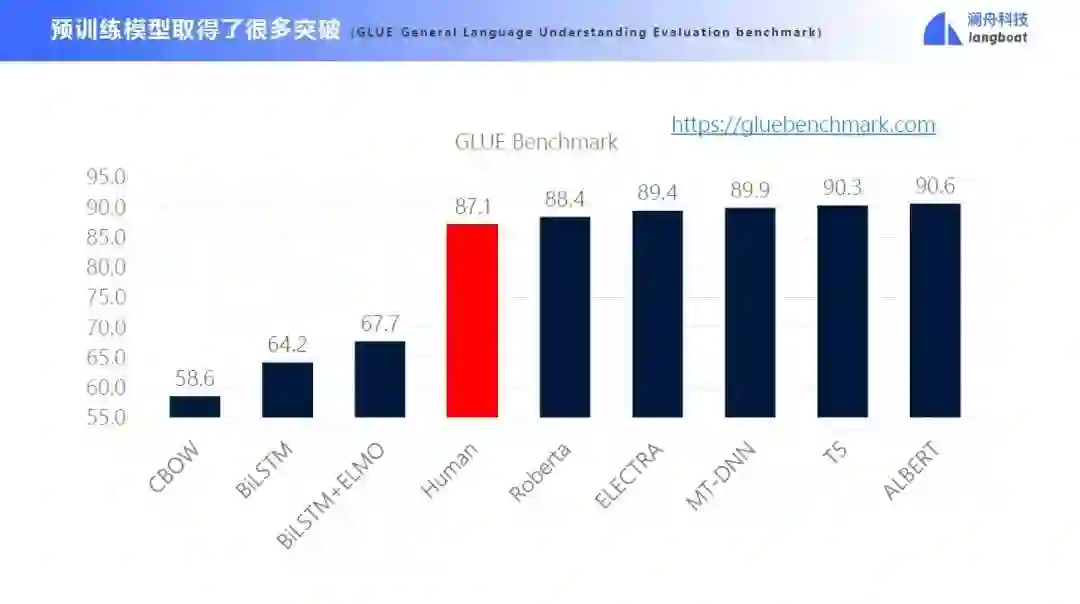

预训练模型取得了巨大的突破,在一些任务上甚至超过了人类的表现。

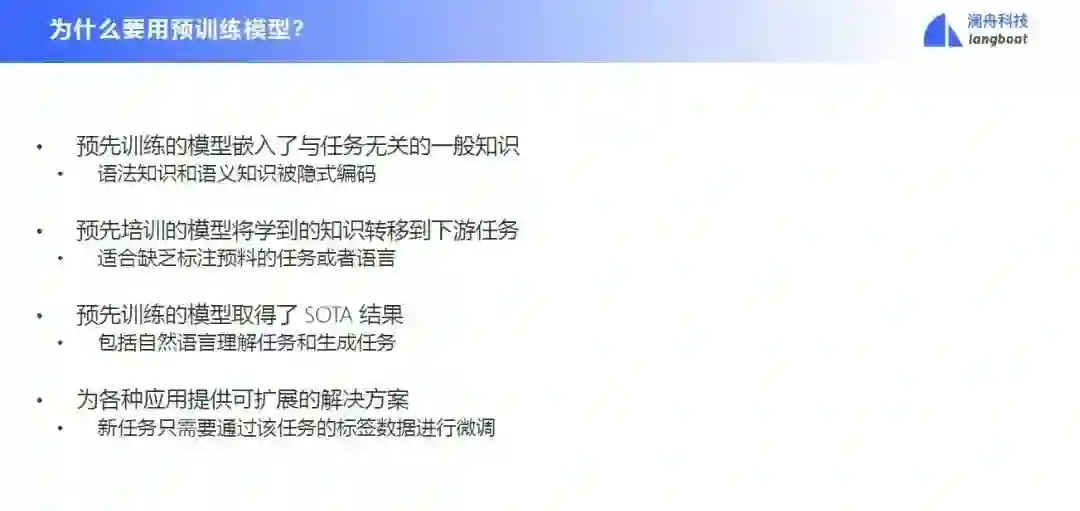

为什么要用预训练模型呢?第一个是因为预先训练的模型嵌入了与任务无关的一般知识,所有语法知识和语义知识都被隐式编码了;第二个是我们可以将预训练模型学到的知识迁移到下游任务,面对一些缺少数据的任务和语言,预训练模型也能管用;第三是预先训练的模型在自然语言理解和生成任务上取得了 SOTA 结果;最后是因为预训练模型可以为各种应用提供可扩展的解决方案。

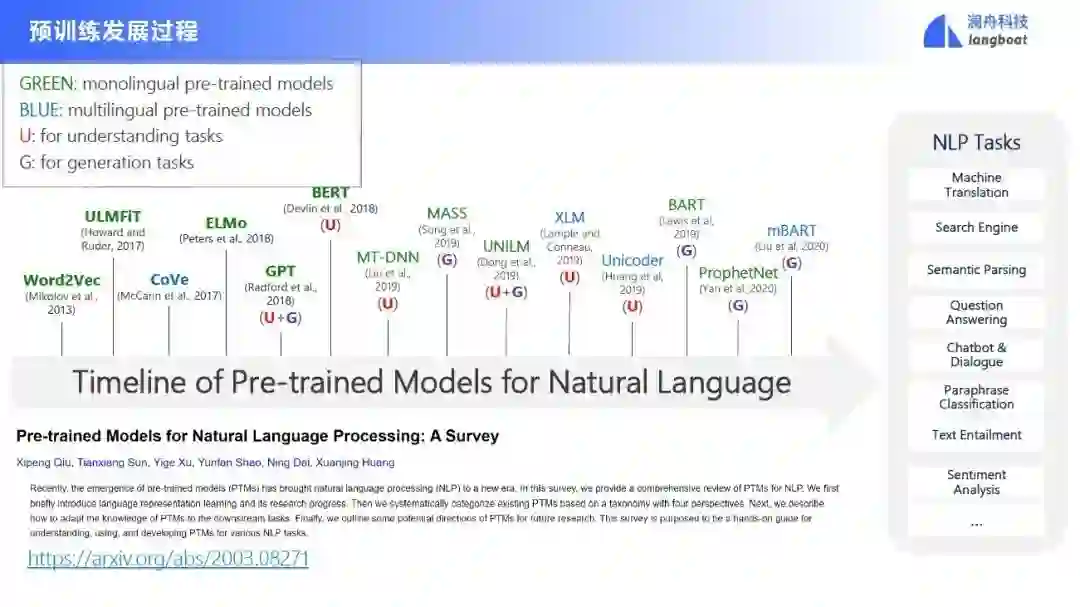

这是预训练模型的发展过程。最早的word2vec学到的是静态的词向量,即使是一个多义词,也只有一种词向量表示。之后的模型是动态语言模型,结合具体的上下文为每个词提供一个向量表示。

复杂推理

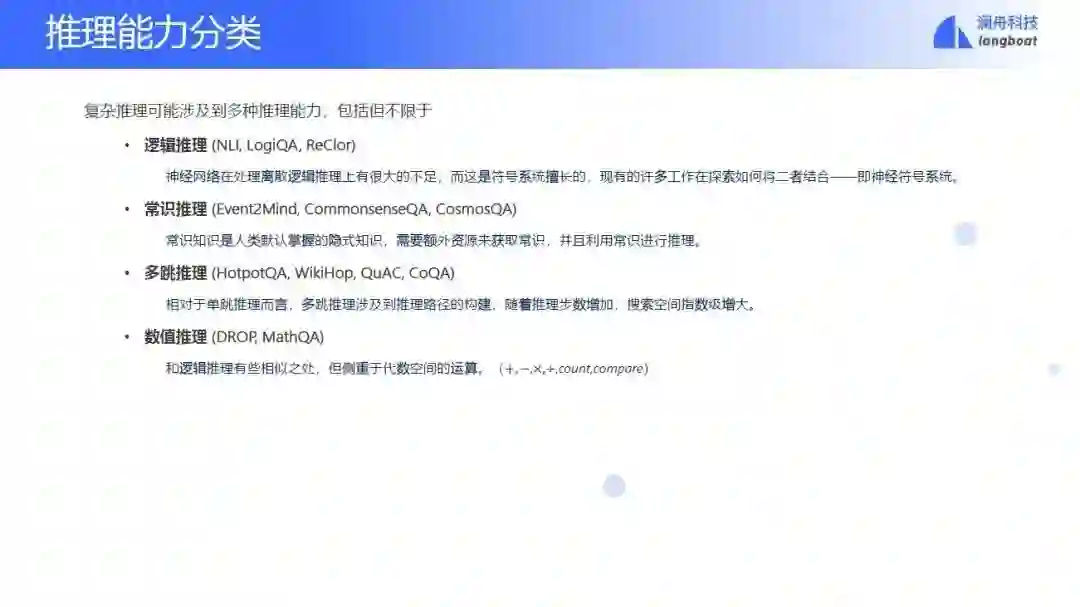

- 推理能力分类

神经网络对于搜索、问答等问题都做得很好,但是对一些诸如复杂推理的困难问题依然处理不好。复杂推理指的是模拟人的一个推理行为,给定一个信号输入推出一个结果,中间用到了知识库、常识、领域知识、逻辑等要素,来综合来得到一个答案。

这个任务一般可以分为逻辑推理、常识推理、多跳推理和数值推理。比如说常识推理,需要我们在推理的时候掌握基本的常识。再比如多跳推理,比尔·盖茨的太太的公司,比尔盖茨的太太算一跳推理,太太的公司就是两跳推理。还有数值推理,基于数字运算,比如火车时速100公里,那经过100米长,要开几分钟等等。

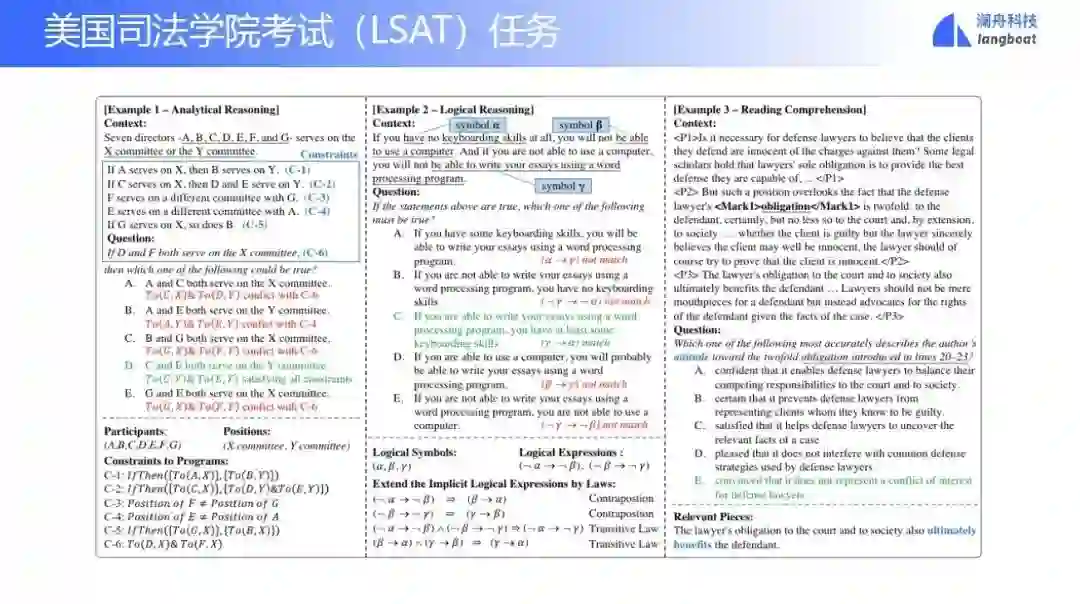

这里介绍一个任务,美国司法学院考试(LSAT)。这个考试有三大类型问题,第一大类型问题叫逻辑推理,第二大类叫分析推理,第三大类叫阅读理解。美国大概有300所司法学校或者学院,我们使用模型参加这个考试,大概是能进Top104。

我们主要考虑第一大类逻辑推理问题。这个问题可以建模为多项选择问答任务。输入上下文和问题,让模型从五个候选项中输出正确选项。

我们求解的基线方法是将上下文、问题和五个候选项依次拼接,输入transformer中得到五个选项的概率分布,最后取概率最大的选项作为输出。

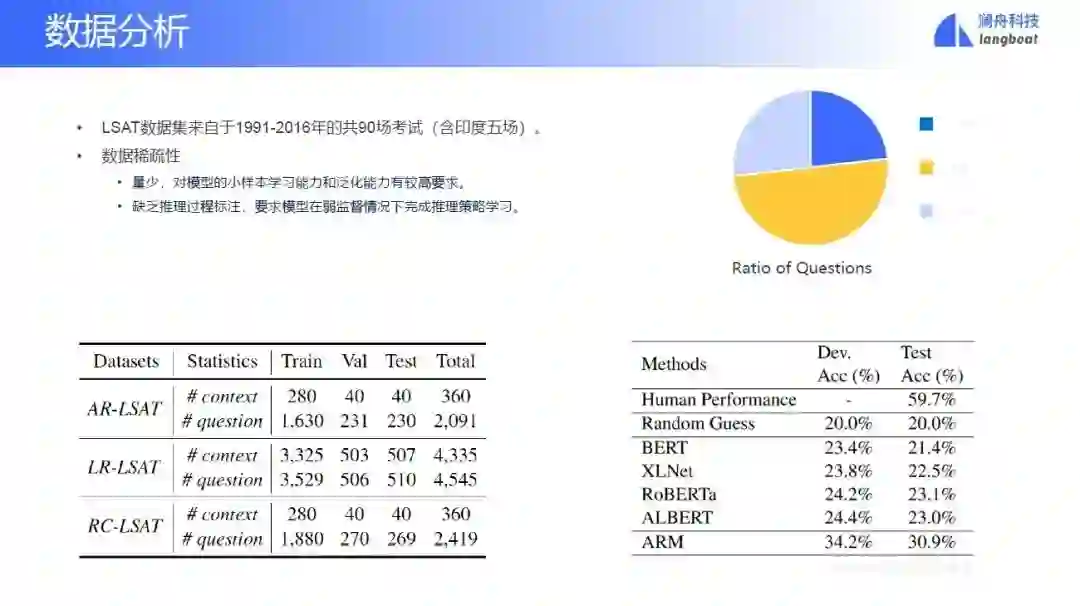

这样直接训练面临的一个巨大问题就是数据稀疏性。我们只能找到1991-2016年的共90场考试的数据,数据量少,对模型的小样本学习能力和泛化能力有较高要求。此外缺乏推理过程标注,要求模型在弱监督情况下完成推理策略学习。

- 逻辑推理(Lreasoner)

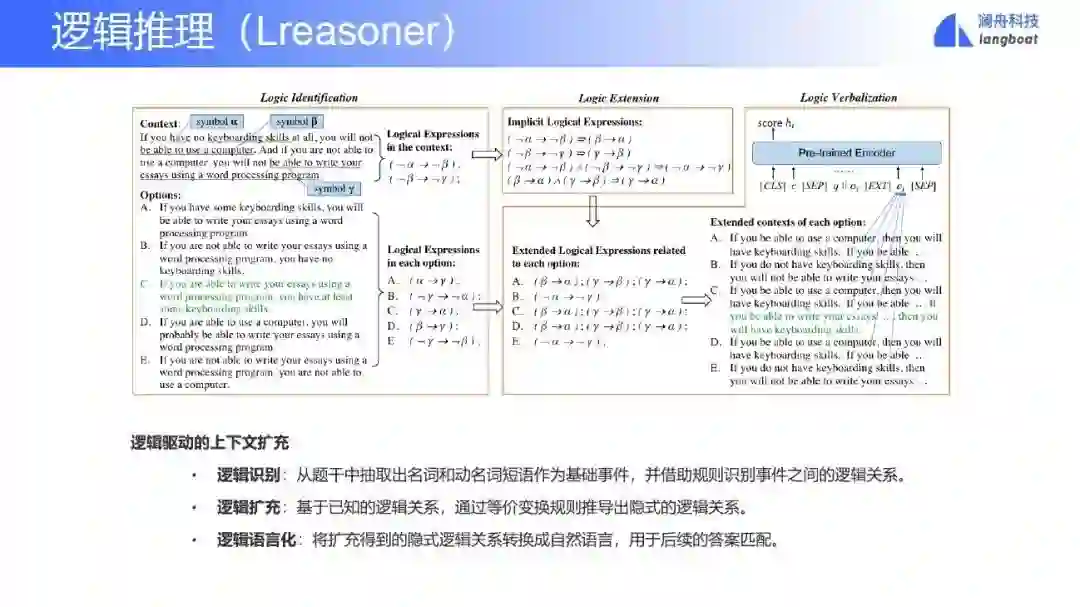

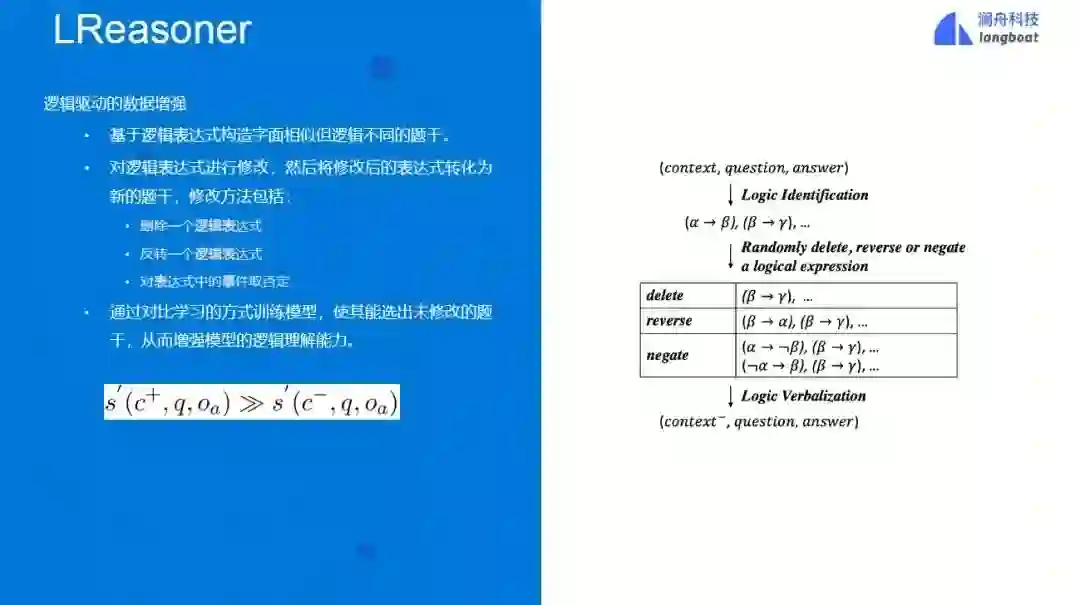

为了更好地完成这个任务,我们提出了Lreasoner算法。该算法实现了逻辑驱动的上下文扩充。具体包括:

-

逻辑识别:从题干中抽取出名词和动名词短语作为基础事件,并借助规则识别事件之间的逻辑关系。

-

逻辑扩充:基于已知的逻辑关系,通过等价变换规则推导出隐式的逻辑关系。

-

逻辑语言化:将扩充得到的隐式逻辑关系转换成自然语言,用于后续的答案匹配。

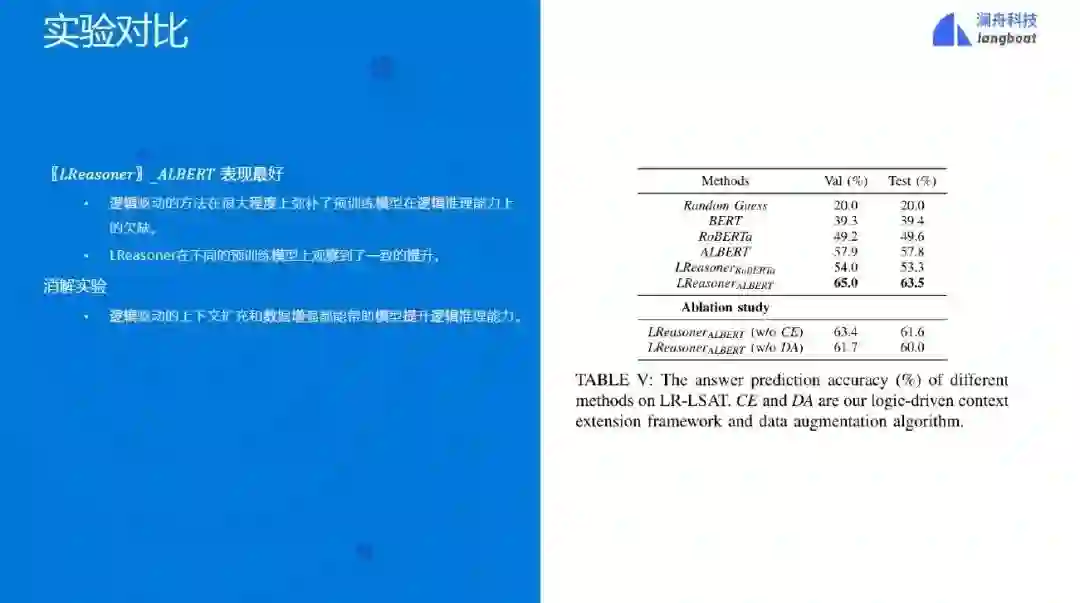

图进一步地,我们提出了逻辑驱动的数据增强算法,基于逻辑表达式构造字面相似但逻辑不同的题干。通过对比学习的方式训练模型,使其能选出未修改的题干,从而增强模型的逻辑理解能力。