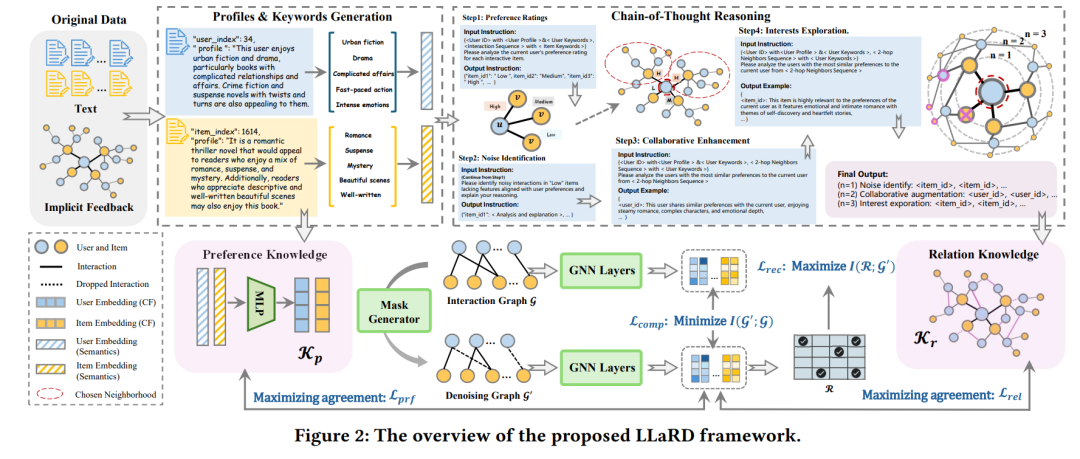

推荐系统对于个性化用户体验至关重要,但通常依赖于隐式反馈数据,而这些数据可能噪声较大且具有误导性。现有的去噪研究涉及通过整合辅助信息或从交互数据中学习策略。然而,这些方法面临外部知识和交互数据固有的局限性,以及某些预定义假设的非普适性,导致无法准确识别噪声。近年来,大型语言模型(LLMs)因其广泛的世界知识和推理能力而受到关注,但它们在增强推荐系统中去噪方面的潜力仍未得到充分探索。本文提出了LLaRD框架,通过利用LLMs来改善推荐系统中的去噪,从而提升整体推荐性能。具体而言,LLaRD通过先使用LLMs丰富观测数据中的语义洞察,并推断用户-项目的偏好知识,来生成与去噪相关的知识。接着,它在用户-项目交互图上应用一种新颖的链式思维(Chain-of-Thought, CoT)技术,揭示与去噪相关的关系知识。最后,它应用信息瓶颈(Information Bottleneck, IB)原理,将LLM生成的去噪知识与推荐目标对齐,从而过滤掉噪声和不相关的LLM知识。实证结果证明,LLaRD在提升去噪和推荐准确性方面的有效性。代码可在 https://github.com/shuyao-wang/LLaRD 获取。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

224+阅读 · 2023年4月7日