对话状态跟踪

·

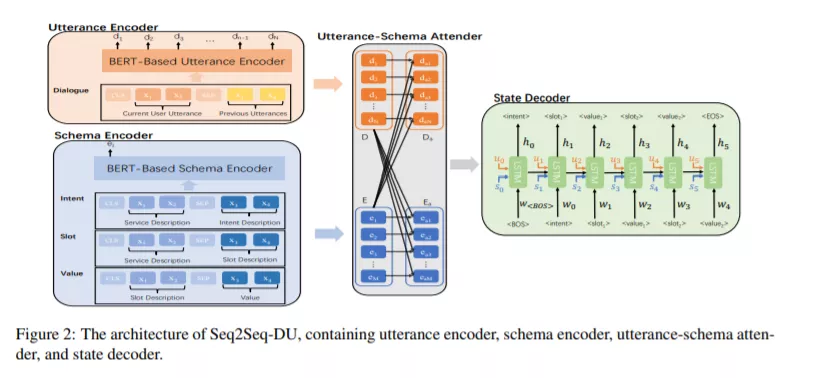

本文研究了面向任务的对话系统中的对话状态跟踪问题。最近,DST技术的发展取得了重大进展。然而,构建一个可扩展且有效的DST模块仍然是一个具有挑战性的问题。本文提出了一种对话状态跟踪的新方法Seq2Seq-DU,它将DST形式化为一个序列到序列的问题。它使用两个基于BERT的编码器分别对对话中的话语和模式的描述进行编码,使用一个关注器计算话语嵌入和模式嵌入之间的关注量,使用一个解码器生成指针来表示对话的当前状态。Seq2Seq-DU具有以下优点。它可以联合建模意图、插槽和插槽值之间的关系;它可以利用丰富的话语和图式的语言表征;它可以有效地处理分类槽、非分类槽和看不见的模式。此外,Seq2Seq-DU还可以用于对话系统的NLU(自然语言理解)模块。在基准数据集(SGD、MultiWOZ2.2、WOZ2.0、DSTC2、M2M、SNIPS和ATIS)上的实验结果表明,Seq2Seq-DU优于现有的方法。

成为VIP会员查看完整内容