基于双流更新的视觉

Transformer动态加速方法

Evo-ViT: Slow-Fast Token Evolution for Dynamic Vision Transformer

视觉Transformer 通过自注意力机制捕获短程和长程视觉依赖的能力使其在各种计算机视觉任务中显示出巨大的潜力,但是长程感受野同样带来了巨大的计算开销,特别是对于高分辨率视觉任务。为了能够在保持原有模型准确率的前提下,降低模型计算复杂度,从而使得视觉 Transformer成为一种更加通用、高效、低廉的解决框架,我们提出了Evo-ViT,基于双流token更新的视觉transformer动态加速方法。

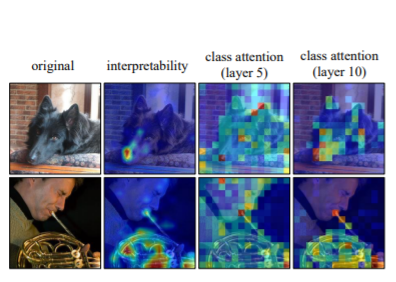

该方法在保持了完整空间结构的同时给高信息量token和低信息量token分配不同的计算通道。从而在不改变网络结构的情况下,以极低的精度损失大幅提升直筒状和金字塔压缩型的Transformer模型推理性能。

其中,我们提出的基于全局class attention的token选择策略通过增强层间的通信联系实现稳定token选择,相比以往方法,无需依靠外部的可学习网络来对每一层的token进行选择,也无需基于训练好的网络进行token裁剪。在ImageNet 1K数据集下,Evo-ViT可以提升DeiT-S 60%推理速度的同时仅仅损失0.4%的精度。

https://www.zhuanzhi.ai/paper/7a1101e877530fa0dc16f1315fe9c019

成为VIP会员查看完整内容