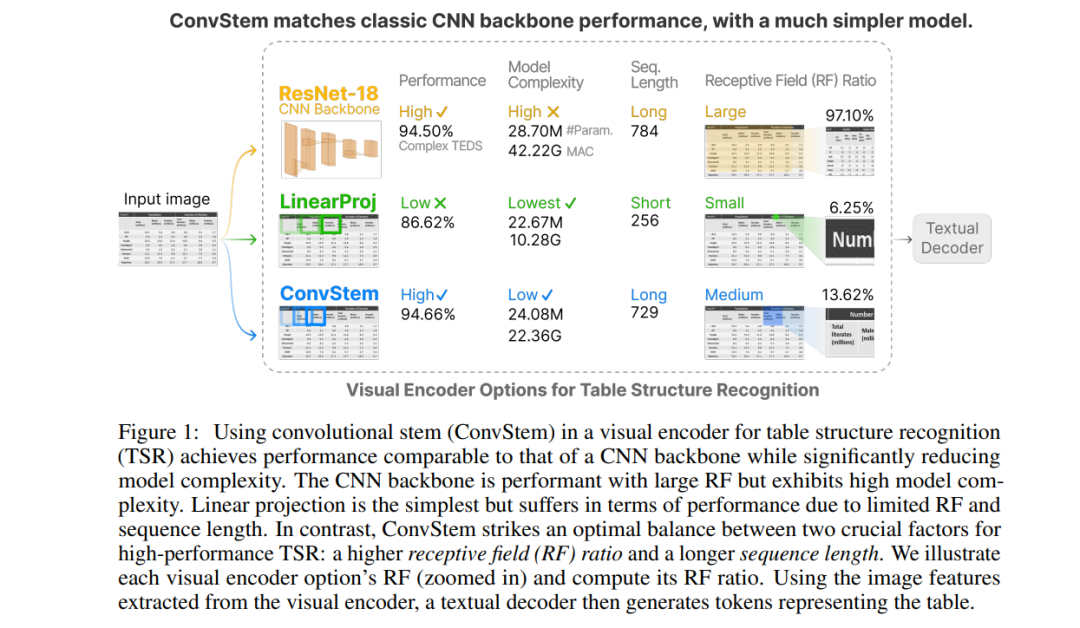

表格结构识别(TSR)旨在将表格图像转换为机器可读格式,其中视觉编码器提取图像特征,文本解码器生成代表表格的令牌。现有方法使用经典的卷积神经网络(CNN)主干作为视觉编码器,以及Transformer作为文本解码器。然而,这种混合的CNN-Transformer架构引入了一个复杂的视觉编码器,占据了模型总参数近一半,显著降低了训练和推理速度,并阻碍了TSR中自监督学习的潜力。在这项工作中,我们设计了一个轻量级的视觉编码器用于TSR,同时不牺牲表现力。我们发现,一个卷积干可以匹配经典CNN主干的性能,而模型更简单。卷积干在两个关键因素之间达到了最佳平衡,这两个因素对于高性能TSR至关重要:更高的接收域(RF)比率和更长的序列长度。这使得它能够“看到”表格的适当部分,并为后续的Transformer“存储”复杂的表格结构,提供足够的上下文长度。我们进行了可重现的消融研究,并在 https://github.com/poloclub/tsr-convstem 上开源了我们的代码,以提高透明度,激发创新,并在我们的领域内促进公平的比较,因为表格是表示学习的有前景的模态。

成为VIP会员查看完整内容

相关内容

Arxiv

223+阅读 · 2023年4月7日

Arxiv

20+阅读 · 2023年3月21日