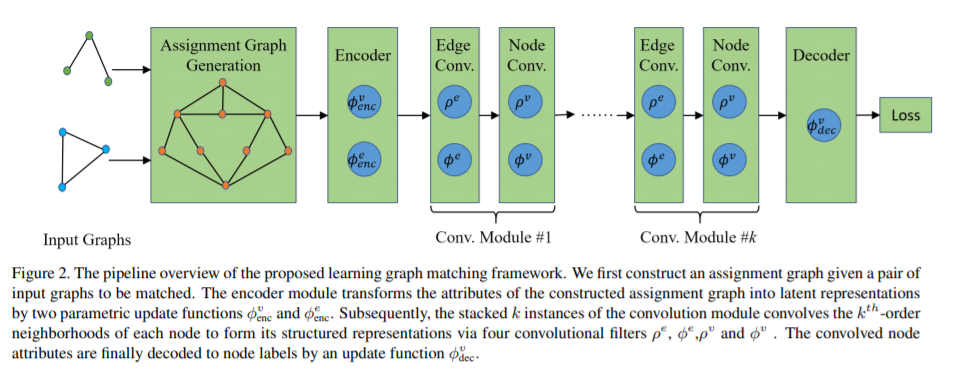

基于学习的图匹配方法已经发展和探索了十多年,最近在范围和受欢迎程度方面迅速增长。然而,以往的基于学习的算法,无论有没有深度学习策略,都主要关注节点和/或边缘亲和力生成的学习,而对组合求解器的学习关注较少。在这篇论文中,我们提出了一个完全可训练的图匹配框架,在这个框架中,亲和的学习和组合优化的求解不像以前的许多技术那样被明确地分开。首先将两个输入图之间的节点对应问题转化为从一个构造的赋值图中选择可靠节点的问题。然后,利用图网络块模块对图进行计算,形成每个节点的结构化表示。最后对每个节点预测一个用于节点分类的标签,并在正则化的排列差异和一对一匹配约束下进行训练。该方法在四个公共基准上进行了评估,并与最先进的算法进行了比较,实验结果表明了该方法的良好性能。

成为VIP会员查看完整内容

相关内容

Arxiv

3+阅读 · 2019年2月26日