近来,大语言模型在自然语言上展现出了惊人的理解和推理能力,各个领域纷纷开始探索大语言模型在各自领域的应用。 在推荐系统领域,一系列工作探索利用大模型完成推荐任务,关于大语言模型能否取代传统推荐模型(ID-based)尚未得到统一的结论。但其中有一关键问题没有得到重视:既然大语言模型展示了优异的推理能力,那么大语言模型能否理解传统推荐模型? 近日,来自中国科学技术大学,新加坡国立大学,以及香港理工大学的研究团队,成功展示了大语言模型,对于传统基于ID的推荐模型,在隐空间层面上具有精确的理解能力。对于推荐系统隐空间中高度压缩的向量表示,大语言模型可以准确还原其内容,向我们提供了利用大语言模型研究推荐系统的全新思路。 论文地址:https://arxiv.org/pdf/2310.20487.pdf

研究背景

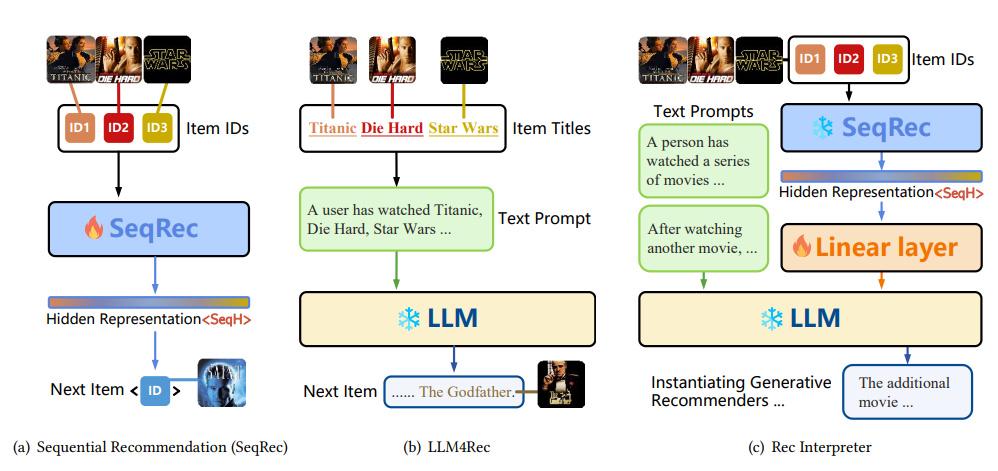

进来,随着大语言模型的火热,研究人员发现大语言模型可以理解来自不同模态的模型,例如图片,音频,视频等。诸如MiniGPT4,GILL,GPT4Vision等工作,向我们展示了大语言模型在模型层面,对于各种模态的理解与推理能力。 然而在推荐系统领域,大家的焦点仍在将推荐的交互数据表示为自然语言形式,然后直接利用大模型完成推荐任务,而忽略了模型层面大语言模型对推荐系统的理解。 在此基础上,首先要回答的科学问题是:“大语言模型能否理解传统推荐模型隐空间中的表征”。基于此问题,我们提出了RecInterpreter,成功揭示了大模型对传统基于ID的推荐系统的隐空间表征具有准确的理解能力,并能够还原编码在其中的交互行为。 此外,在最新的生成式推荐框架DreamRec中,生成的物品是在隐空间中表示的,未能实现生成物品的显式表示。RecInterpreter框架可以利用大语言模型,对DreamRec生成的物品提供自然语言解释,全方位实现了生成式推荐新范式。

方法

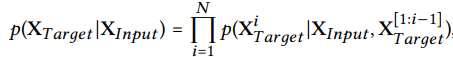

RecInterpreter以三个任务展示大语言模型对传统推荐模型隐空间的理解能力:序列还原任务,额外交互识别任务,以及理想物品实例化任务。

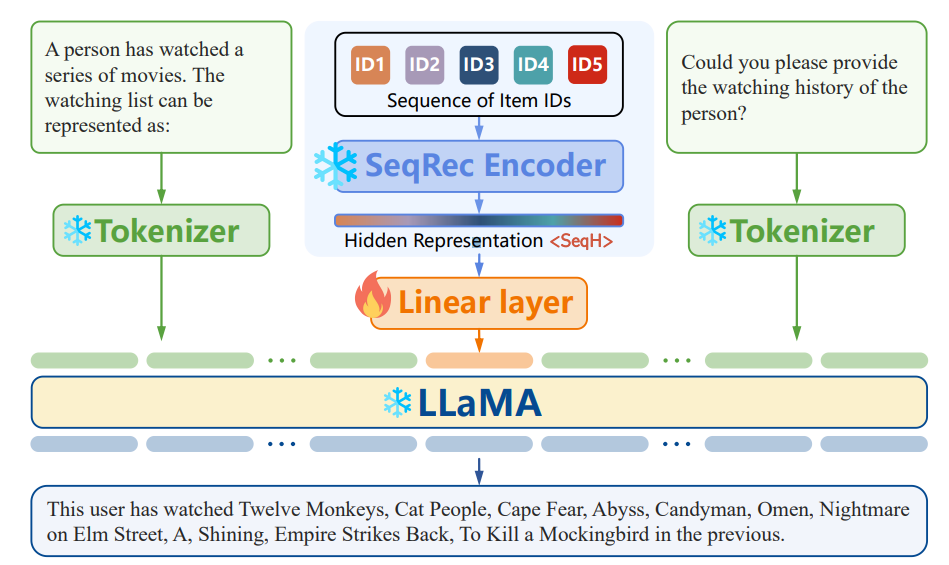

1)序列还原任务

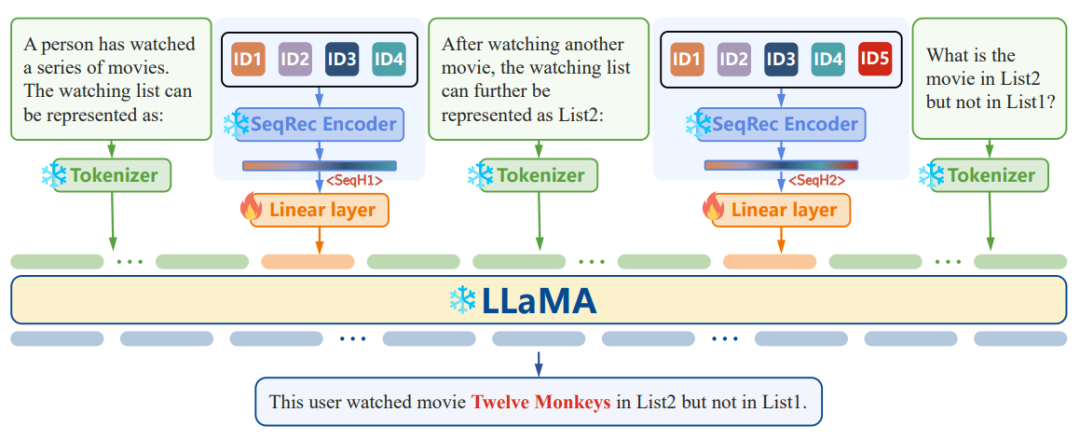

对于交互序列** **

**,**传统推荐模型首先将其向量化为:

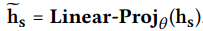

然后RecInterpreter利用线性映射层,将其映射到LLaMA的token空间中:

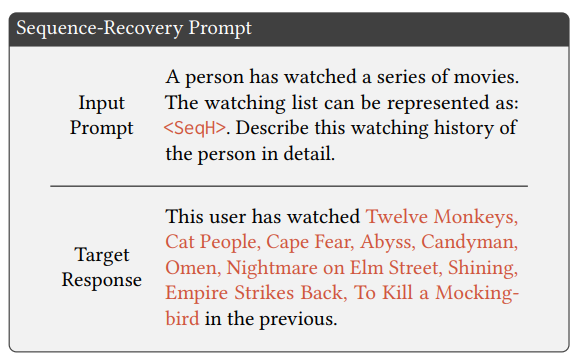

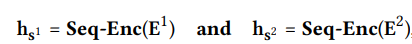

为序列还原任务设计Prompt如下:

其中

其中为Input Prompt, 为Target Response。

2) 额外交互识别任务

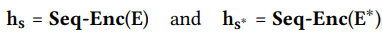

对于交互序列

同样通过线性映射,将其映射到LLaMA的隐空间中:

训练依旧冻结LLaMA和序列推荐模型的参数,只更新线性映射层。

3)理想物品实例化任务

在DreamRec中,给定交互序列

经过线性映射得到:

此后利用上述额外交互识别框架,即可利用LLaMA为理想物品提供自然语言解释。 实验结果

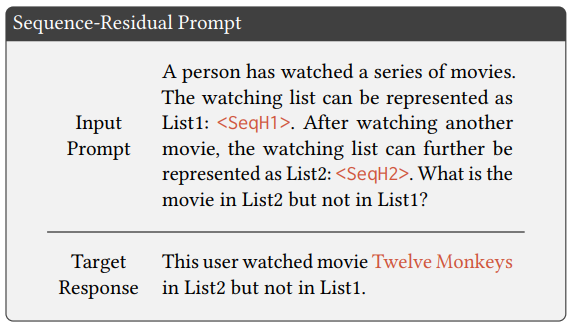

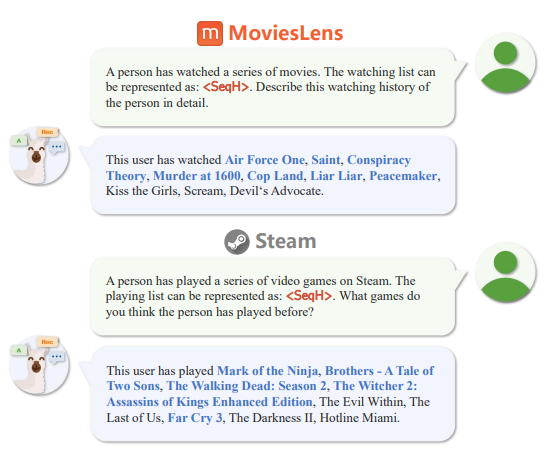

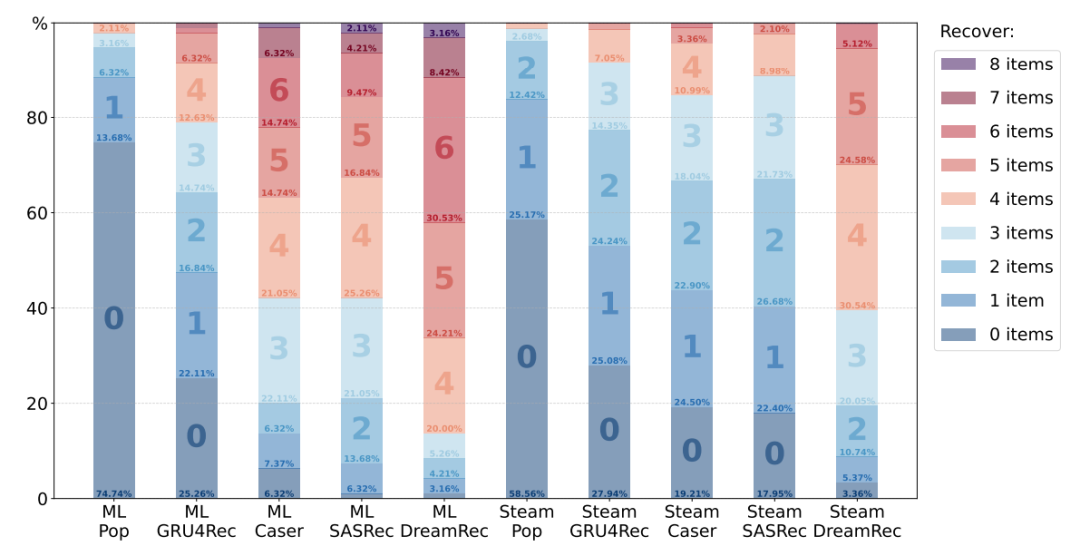

我们在MovieLens和Steam两个数据集上进行了实验,其中物品的自然语言描述用对应的电影名和游戏名表示。 1)序列还原结果:

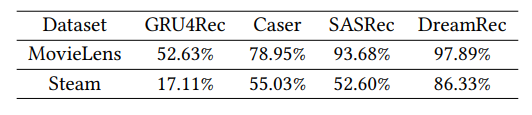

2)额外交互识别结果:

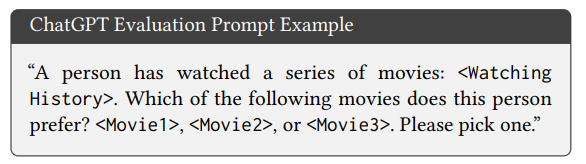

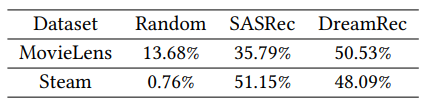

额外交互识别结果如上表,可以看出大模型可以识别额外交互,且推荐模型越先进,识别准确率越高。 3)理想物品实例化结果: 在LLaMA对DreamRec生成的理想物品实例化结果中,有超过20%的物品不存在与数据集中,这验证了作为生成式推荐模型,DreamRec不局限于候选物品集的特质。这也导致了理想物品实例化结果难以用传统的Top-K指标衡量。因此,我们利用ChatGPT来衡量结果,Prompt如下:

其中<

可以看出在MovieLens数据上,DreamRec取得了比SASRec更好的结果,在Steam数据上也取得了相似的结果;并且DreamRec和SASRec的推荐结果明显好于随机采样。此结果的合理性不但验证了DreamRec作为生成式推荐模型的有效性,更验证了RecInterpreter成功揭示了大模型可以理解推荐模型的隐空间。 未来展望

RecInterpreter探究了大模型在推荐领域一直以来被忽略的问题,揭示了大模型可以高度理解传统基于ID推荐模型的隐空间。为大模型在推荐领域的研究提供了新的思路。此外,本研究揭示了在模型层面,推荐模态和视觉,音频,自然语言等模态一样,都可以用大模型进行统一,为推荐领域基础模型(Foundation Model)研究奠定了基础。