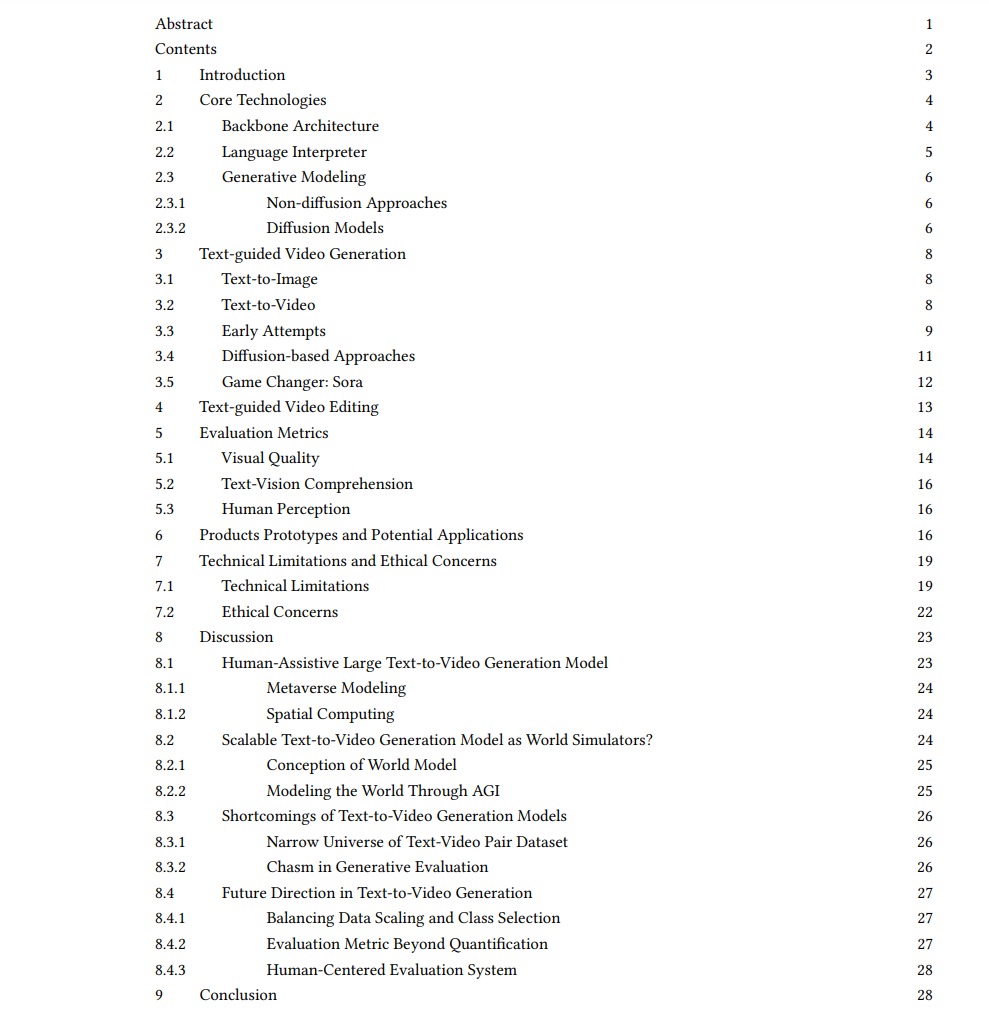

文本到视频生成标志着在快速发展的生成式人工智能领域中的一个重要前沿,融合了文本到图像合成、视频字幕生成和文本引导编辑的进展。本综述批判性地考察了文本到视频技术的进展,聚焦于从传统生成模型到尖端的Sora模型的转变,强调了在可扩展性和泛化性方面的发展。区别于以往的分析,我们提供了对这些模型的技术框架和演进路径的深入探讨。此外,我们深入****研究了实际应用,并讨论了伦理和技术挑战,如无法处理多实体操作、理解因果效应学习、理解物理交互、感知对象缩放和比例调整,以及对抗对象幻觉,这也是生成模型中一个长期存在的问题。我们的综合讨论涵盖了使文本到视频生成模型作为人类辅助工具和世界模型的主题,以及引出模型的不足和总结未来的改进方向,主要集中在训练数据集和评估指标(自动的和以人为中心的)上。本综述旨在针对新手和资深研究者,寻求在不断增长的文本到视频生成领域催化更多的创新和讨论,为更可靠和实用的生成式人工智能技术铺平道路。

2024年2月15日,OpenAI介绍了一种新的基础模型,能够根据用户的文本提示生成视频。这个被命名为Sora的模型,人们称其为ChatGPT的视频版本,主要从市场营销[36, 134]、教育[14]和电影制作[127]等行业引发了兴奋,因为它促进了通常需要大量资源才能创造的高质量内容创作的民主化。OpenAI声称,由于Sora在大规模文本-视频对数据集上进行了训练,它具有令人印象深刻的近乎现实世界的生成能力。这包括生动角色的创造、平滑动作的模拟、情绪的描述,以及显著对象和背景的详细提供。

鉴于这些声明,我们对从技术角度探索文本到视频生成模型是如何演进的感兴趣。为此,我们对文本到视频生成模型的研究进行了全面回顾,并推断出它们遵循的某些机制的通用框架。因此,本综述主要收集了IEEE Xplorer和ACM图书馆的会议和期刊论文,例如IEEE CVPR、ECCV、NIPS、ICML和ACM Multimedia,以及来自arXiv的一些最新研究。收集的大部分论文范围从近年到十年前,以简化领域背景的讨论。结果,使用文本到视频、生成式AI、视觉解释、对象检测等关键词,通过滚雪球抽样技术收集了不少于140篇文章。基于这个技术总结,我们探讨了各种相关方面,以支持对文本到视频生成研究日益增长的全面理解。这使我们的工作区别于先前关于类似主题的综述[118, 162],因为我们进一步超越了这个生成模型的外表。此外,我们还补充了现有的生成模型综述工作,包括文本到文本[154]、文本到图像[155]、文本到3D[73]和文本到语音[157]。通过这种构想,我们希望我们的工作可以成为新研究人员在文本到视频生成领域的可理解的学习基础。此外,鉴于我们的多方面讨论,我们希望激发这些模型的潜在改进,使它们对最终用户更加可靠和值得信赖。我们综述文章的另一个重要目标是为任何对探索文本到视频方法感兴趣的人提供简明的课程,并进一步强调这一领域的几个研究前景。我们期望我们的读者可以轻松理解这一动态领域内的障碍和潜力。 为了呈现关于文本到视频生成模型的全面综述,我们首先简要介绍其核心技术,包括视觉建模和语言解释的基本原理和骨干(§ 2)。然后,我们以时间顺序开始探索文本到视频生成模型,从它们如何源于文本到图像生成模型,到最近尝试扩展视频生成模型Sora(§ 3)。此外,我们探索了另一个领域,其目的是使用用户的文本提示编辑视频(§ 4)。注意,对于每项探索,我们都提供了模型用来生成或编辑视频的通用框架的概述。我们还简要介绍了文本到视频生成模型常用的评估指标(§ 5)。为了与从业者互动,我们还介绍了文本到视频生成技术可能在行业中扮演重要角色的几个实际应用(§ 6)。尽管文本到视频生成模型具有独特性,我们列出了可能阻碍潜在用户完全信任模型的合理限制和顾虑(§ 7)。最后,我们在讨论中总结了文本到视频生成模型如何激发社会思考,以及未来研究如何通过改善模型性能来改善这一点(§ 8)。

文本引导的视频生成: Sora

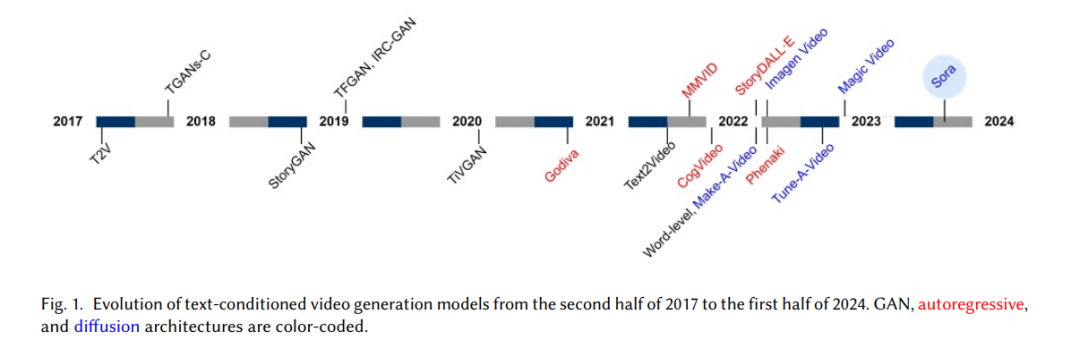

视频生成模型源自图像生成模型,因为视频本质上是遵循一定时间一致性规则的图像序列。在这一部分中,我们首先简要介绍文本到图像生成模型是如何演变成文本到视频生成模型的。我们进一步讨论了每种特定架构背后的基础框架,如基于GAN的、基于自回归的和基于扩散的模型。

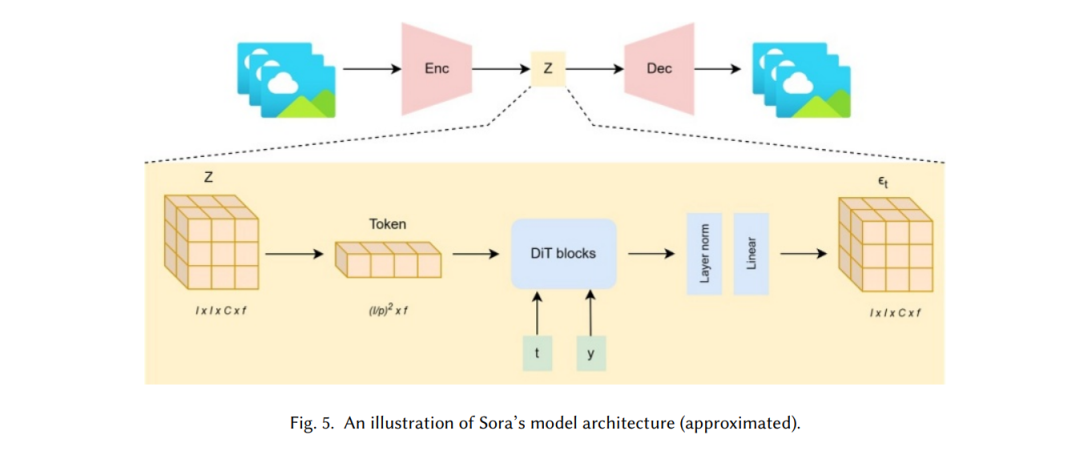

在第3.4节中,我们讨论了几个带有扩散模型架构的文本到视频生成模型的例子。尽管如此,这些模型中的大多数采用了带有U-Net骨架的潜在DDPM,该骨架由卷积层组成。从这一发展中更进一步的是,用变换器(Transformer)骨架替换基于ConvNet的DDPM,使视频生成模型更具可扩展性。这正是由OpenAI的大型视觉模型(LVMs)的新成员Sora[96]实现的,它是视频生成模型的一部分。Sora的核心视觉处理能力基于扩散变换器(DiT)[97]。扩散变换器继承了类似于ViT的结构,通过替换标准层归一化为自适应层归一化以纳入条件项,进行了轻微修改。其余的工作原则继承了ViT,其中视觉输入被打成补丁并线性投影,然后送入变换器编码器。

尤其对于视频生成而言,该机制在图5中进行了说明。请注意,由于OpenAI没有披露Sora的模型架构,我们是基于技术报告中描述的内容进行近似。首先,由f序列的大小为H X W X C的图像组成的视频被编码成潜在表示Z,以将高分辨率输入压缩成低分辨率特征,以节省生成过程的计算成本。具有I x I x C形状的Z被分解成每个形状为p x p的补丁。补丁被线性投影成长度为(I/p)² x f的向量。然后将噪声线性向量连同其他条件一起输入到DiT中,如步长t和文本嵌入y。扩散过程产生一个新的潜在表示𝜖t,其形状与Z相同。然后,通过解码器对结果潜在表示进行上采样,以生成视频输出。Sora的强大视觉处理器与异常的文本生成模型,GPT-4,相结合。最重要的是,Sora遵循DALL·E-3[12]中使用的重新描述策略,自动将简单用户标题转换成高度描述性的文本以供DiT编码。利用生成式语言模型使Sora能够更好地理解用户指令中的上下文,从而使其能够创建具有令人印象深刻的文本-视觉一致性的视频。

正如前一节中详细阐述的那样,OpenAI声称Sora是一个能够理解并因此模拟物理世界的AI模型,这一点是可以理解的。这一声明确实为Sora与现有的文本到图像模型(如DALL·E)之间划定了界限,后者被创造出来以视觉方式表达文本概念。虽然后者被部署以更加“创造性”的目标,前者则被开发用于现实地模拟或模型化物理世界。然而,要将Sora标记为一个世界模型,首先必须理解像Sora这样的AGI承担这样的标识需要什么。

世界模型的概念。世界建模的概念已经存在了四十多年。它最初源于纯科学,如物理学、数学和经济学。通常,世界建模的过程相当启发式的,因为模型制作者往往缺乏一个全面的计划或理论来支撑他们的思考,类似于没有食谱就试图烘焙蛋糕,需要经历几次试验和错误[13]。因此,模型制作者只能依赖现有的作品或与他们的构想紧密相关的可用信息来近似他们心中设想的世界[39]。一般而言,世界建模的主要组成部分包括理论、隐喻、类比、政策、经验数据、风格化事实以及数学概念和技术(图15),这些必须包含在建模“食谱”中[13]。将这些方面总结为实践,今天的世界模型似乎被三种能力所代表,即视觉、记忆和控制器,分别由Ha和Schmidhuber展示为VAE、RNN和控制器[45]。这样的概念适用于任何模态,因为视觉、记忆和控制器可以分别指数据、架构和目标函数(图15)。

通过AGI建模世界。作为人工智能快速发展领域的革命性前沿,AGI旨在实现一种认知性能,这种性能在广泛的任务和领域内可与人类智能相媲美或超越,超越人工窄智能(ANI)系统的能力[83]。其目标是构建能够进行人类能够进行的任何智力工作的机器,包括理解、学习和灵活自主地应用信息。与定制的专门任务的AI应用相比,如图像识别、下棋或语言翻译,AGI旨在将这些不同的技能结合到一个展示出通用智能的单一系统中。对智能基础更深层次理解的追求激发了这种全面的AI研究和开发方法,为可能彻底改变我们与技术互动、处理挑战性问题和理解人类心智功能的创新打开了大门。鉴于这些规格,AGI确实有资格被称为世界模型。然而,基于我们在前几节的讨论,我们可以推断AGI模型是纯数学的,没有考虑手动控制在“真实”世界中固有存在的内在方面。例如,像ChatGPT这样的LLM完全是基于执行纯矩阵操作的变换器构建的。这反映了研究人员尝试通过NLP建模世界的方式,在1990年,当他们认识到世界建模的难度超出了将实体和属性作为语言中的基本本体论连接起来时[15]。尽管存在这些情况,科学家们仍在不断前进,以实现在完美适合用户理解的模型中建模浩瀚宇宙的梦想。凭借这些属性,研究人员一直在创新各种方式,让模型看到真实世界的环境。通过游戏[76]、虚拟化身[142]和带有人类反馈的强化学习[23]等方法进行的代理建模,是挖掘真实世界经验的方法之一。