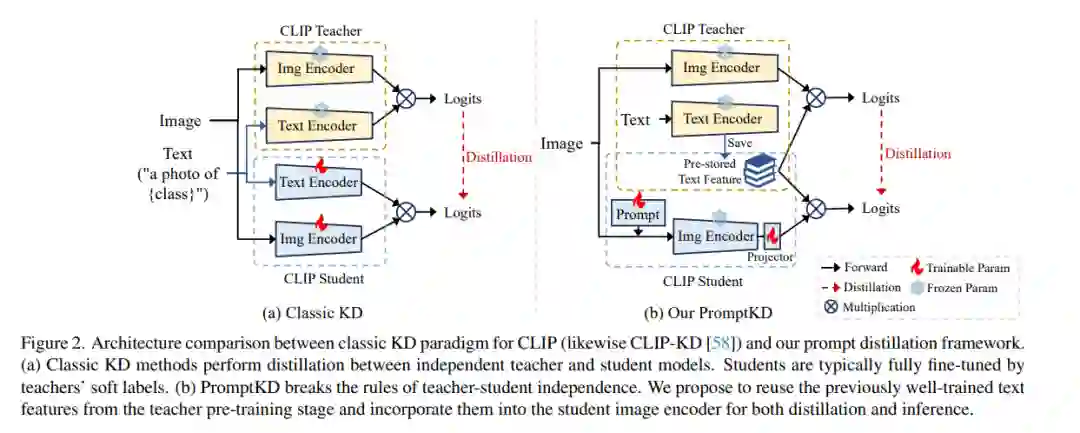

提示学习已成为增强视觉-语言模型(如CLIP)用于特定领域下游任务的宝贵技术。现有工作主要集中在设计各种学习形式的提示上,忽略了提示作为从更大教师模型学习的有效蒸馏器的潜力。在本文中,我们介绍了一个无监督领域提示蒸馏框架,旨在通过使用未标记领域图像的提示驱动模仿,将较大教师模型的知识转移到轻量级目标模型上。具体来说,我们的框架包含两个不同阶段。在初始阶段,我们使用领域(小样本)标签预训练一个大型CLIP教师模型。预训练后,我们利用CLIP独特的解耦模态特性,通过教师文本编码器一次性预计算并存储文本特征作为类向量。在后续阶段,存储的类向量在教师和学生图像编码器之间共享,用于计算预测的logits。此外,我们通过KL散度对齐教师和学生模型的logits,鼓励学生图像编码器通过可学习的提示生成与教师相似的概率分布。提出的提示蒸馏过程消除了对标记数据的依赖,使算法能够利用领域内大量的未标记图像。最后,训练良好的学生图像编码器和预存储的文本特征(类向量)用于推理。据我们所知,我们是第一个(1)为CLIP执行无监督领域特定提示驱动的知识蒸馏,以及(2)建立文本特征作为教师和学生之间共享的类向量的实用预存储机制的。在11个数据集上的广泛实验证明了我们方法的有效性。代码可在https://github.com/zhengli97/PromptKD公开获取。

https://www.zhuanzhi.ai/paper/b8be501403f12a07dab22fdf0bb2ae7f

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

86+阅读 · 2023年4月4日