文 / 秦兵,吴迪,赵妍妍

摘 要:

本文以大语言模型价值观对齐研究为主题,介绍大语言模型价值观相关概念、价值观对齐研究发展历程和价值观体系,旨在探索如何使大语言模型的价值观与人类社会价值观保持一致。从共同价值观、群体价值观和个体价值观三种层次,讨论了实现价值观对齐的多种方法和所面临的挑战。文中强调了大语言模型发展中价值观对齐的重要性,并展望了大语言模型价值观对齐研究的发展方向。 关键词:

大语言模型;价值观对齐;共同价值观;群体价值观;个体价值观

0 引言

自2022年11月30日OpenAI发布ChatGPT这一生成式大语言模型以来,人工智能领域迎来新的浪潮。大语言模型将各种自然语言处理任务整合成文本生成任务模式,使用户与模型的互动变得更加便捷。用户通过输入文本指令,在生成文本、回答问题、情感分析、翻译语言、摘要文章等任务上,均可以用统一的模型来获取自然、高效的响应。这种整合为用户提供了一个多功能、高度可定制的工具,有望推动自然语言处理技术在多个领域的应用迈上新台阶。凭借其强大的迁移能力,大语言模型在多领域展现出广泛适应性,甚至在某些任务上具备超越人类专家的潜力。

大语言模型的性能受其不同来源预训练语料库影响,在学习知识的过程中不可避免地也会学习到包含各种人类观念的内容,其中不乏与社会价值观相悖的信息,从而在与用户互动时存在激活这些不良内容的风险。因此,防止大语言模型在与用户互动中产生违反人类价值观的信息,从而更紧密遵循人类价值观,已成为一个亟需研究的问题。

本文的目的是介绍大语言模型的价值观相关概念、价值观对齐研究发展历程和价值观体系;具体而言,将探讨目前的价值观分类方法和现有的价值观对齐技术,以及这些技术未来的发展趋势和在实际应用过程中可能面临的挑战。本文旨在通过对上述内容的介绍与讨论,推动大语言模型的安全发展,确保其与人类价值观有效的对齐;同时也将进一步探讨与大语言模型价值观对齐相关的新方法和新策略,以进一步应对大语言模型应用过程中在伦理和社会相关层面上可能遇到的挑战。

1 价值观相关概念

价值观是对事物的价值或行为的重要性的衡量,它可以帮助确定最合适的行为、最恰当的生活方式,或者判断不同行为的意义。在群体层面,共享的价值观构成了文化和道德的基础。在此基础上,适用于全人类的价值观一般称为共同价值观。而由某个群体形成的一系列规范,由这个群体共同遵守、为集体行为提供指导的价值观,可视为群体价值观。在个人层面,个人价值观则体现了个人的偏好,因背景、经历和信仰而异。

在人工智能领域,对齐技术旨在引导人工智能系统的行为符合设计者的利益和预期目标。对大语言模型而言,价值观对齐是将人类的价值观理念嵌入到语言模型中,使其生成内容能符合人类价值观。

2 大语言模型价值观对齐研究现状

人工智能与人类价值观对齐的概念最早由诺伯特 • 维纳在 1960 年提出。早期的相关研究主要侧重于探索模型的输出是否在特定情境下与人类价值观保持一致,尤其是关于机器学习领域中的种族、性别、文化偏见和公平性问题的研究。例如,研究人员发现预训练模型BERT等在类别预测时表现出性别和种族的刻板印象,于是提出了像StereoSet这样的检测数据集或设计了减少偏见的策略。然而,这些研究多集中于特定场景的自然语言理解任务,随着大语言模型如ChatGPT在更开放和多样的场景中得到了广泛应用,亟需更深入的研究和细化的方法,以应对模型在不同场景中可能出现的伦理、社会和文化等挑战,确保模型在各种不确定和不断变化的情境中尽可能与人类价值观保持一致。

在大语言模型价值观对齐研究中,关键问题是如何进行价值观的分类和对齐。价值观分类主要用于识别语言表达背后的价值观属性,从而判断模型是否与特定价值观及其类型相符。这种分类不仅适用于用户语言的检测,而且对于评估大模型生成的语言也至关重要,以确保用户及模型的行为符合社交媒体、新闻媒体和其他环境的道德和法律规范。价值观对齐则侧重于保证大语言模型的输出内容与人类价值观保持一致,通过预训练、指令微调、人类反馈及后处理等手段实现。此外,还需要在共同价值观基础上,调整模型以反映不同群体的多元价值观,从而适应多样化的应用场景。这种方法不仅增强了模型的普适性也有助于更全面地满足各类用户的需求。

大语言模型的价值观研究仍处于起步阶段,但已经吸引了社会广泛的关注。《时代》杂志评选2023年三大人工智能创新,其中之一便是大语言模型对齐技术。同时多家企业和研究机构已开始对这一领域进行重点布局,例如,OpenAI成立了SuperAlignment团队,目标是在未来五年内解决大语言模型价值观安全问题;加州大学伯克利分校等高等教育机构也已创建了Center for AI Safety组织,专注于AI安全研究,同时为研究者提供培训和计算资源。在国内,诸如哈尔滨工业大学、清华大学、中国科学技术大学和天津大学等学术机构,以及微软、腾讯等公司也在积极开展相关研究。大语言模型价值观对齐的研究将成为未来工业界和学术界的重要研究领域。我们坚信,通过这些努力,大语言模型将更好地与人类价值观保持一致,推动科技向善,为人工智能技术的安全发展打下坚实基础。

3 大语言模型价值观体系

本文将价值观体系分为共同价值观、群体价值观和个体价值观三个层次,如图 1 所示。共同价值观构成价值观体系的基础,代表着那些人类普遍认同的价值观。这些价值观为模型行为提供基本准则,其应用不受特定场景或人群差异的影响。群体价值观考虑到大模型服务于不同的群体,大模型应当融入各个群体的价值观,确保其能够遵循各个群体的道德规范。随着模型越来越多地融入个人日常生活,大模型的应用场景更加灵活,与个体价值观的对齐也变得至关重要。为了使模型能够提供个性化的服务,模型不仅需要遵循共同价值观和群体价值观,还需要根据个人的需求、性格和价值观进行定制化调整。

图 1 价值观体系

3.1 大语言模型的共同价值观

在哲学意义上,共同价值观是超越民族、种族、国界和信仰,是全人类共同拥有的价值观。对于多样化应用的大语言模型而言,同样存在所有应用领域通用的价值观。因此,研究人员需要为大语言模型制定一套共同的价值观体系,将其作为模型行为的基本规范。例如,Anthropic团队提出的由有益性、诚实性和无害性规范组成的体系,体现了这一理念。

目前为止,广泛认可的大语言模型共同价值观标准尚未形成,研究人员正在积极探索各种价值观体系的设计,以构建一个既能反映人类共同价值观,又能确保各价值观间和谐相容的体系。在此探索过程中,计算反思均衡(computational reflective equilibrium)的方法可以用于优化共同价值观的设计,该方法提倡让模型在具体实例或案例中应用共同价值观并进行测试,如果在特定情境下发现模型的共同价值观存在冲突,可能需要修改或调整模型的价值观以解决冲突,从而逐渐找到更合适的共同价值观设计。这一过程可以不断完善和优化模型的共同价值观,确保其适用性和有效性。在这个框架下,哈尔滨工业大学以社会主义核心价值观为基础,构建了模型价值观的指导原则。这些原则涵盖“言语侵犯”“暴力恐怖”“反动言论”等10个关键方面,以确保模型在处理文本内容时能够避免产生令人不悦或危险的内容,更好地满足广泛的社会期望和要求,从而提高模型的社会适应性和伦理性。

3.2 大语言模型的群体价值观

群体价值观多体现为道德规范。在社会活动中,有许多依据群体价值观制定的规范逐渐被社会所接受成为道德规范,所有社会参与者的行为受这些规范约束。为了语言模型的生成内容能够符合道德规范,研究人员建立了如SOCAIL-CHEM101和Moral Integrity Corpus等语料库,这些语料包含了大量的道德场景和简化的道德规范。除了直接从具体场景和规范进行学习外,还有研究者采用规范伦理学的理论,如正义和美德来引导模型的道德学习。这些理论用于分析收集到的场景,进而训练语言模型在特定情境中进行基于这些理论的道德判断。有研究者也探讨了利用故事人物作为学习先验的方法。以“Goofus & Gallant”为例,该故事中的角色行为被用作模型的先验学习对象,其中正面角色的行为是模型学习的依据。这种方法旨在指导模型学习并吸收相应的道德规范。通过详细的故事情境展现和角色行为示范,模型能够在具体的故事背景下,理解并模仿正面角色的行为。

目前大多数为语言模型构建的语料库主要基于英文文本,这一偏向很可能导致大语言模型的输出更倾向于体现西方的道德规范。然而,世界各地的道德规范因国家、地区和文化而异,遵循特定道德规范的语言模型可能无法有效服务于遵循不同道德规范的人群。因此,大语言模型价值观研究不仅应关注模型如何遵循道德规范,而且需考虑模型对多元道德规范的适应性。研究工作应从将普遍认可的共同价值观整合入模型开始,通过外部机制为模型引入多元价值观,使之能够依据具体情境做出适当调整。这将引导我们朝着开发能够适应多元价值观的大语言模型这一长期目标迈进,为更广泛的社会群体提供普惠且包容的人工智能服务。

此外,针对特定领域,如司法和医疗,也存在普遍认可的专业道德规范。开发针对这些垂直领域的模型时,需要从该领域的基本道德规范出发进行对齐。基于此,大模型不仅遵循共同价值观,还能在特定应用领域中展现出更加专业的伦理判断。

3.3 大语言模型的个体价值观

随着语言模型应用变得更加深入和广泛,它们将服务于更多样化的用户群体,并在日常生活中扮演重要角色,如私人助手等。因此,从个人层面来看,研究者需要让语言模型的价值观能够根据服务对象进行灵活调整,以便提供不同的个性化服务。举例来说,在教育领域,可以根据学生的不同偏好和不同性格进行个性化教学;在心理健康领域,可以针对患者价值观设计治疗方案,取得更好的治疗效果;在论辩任务上,模型能够根据受众的价值观偏好进行有针对性的论辩,取得更好的说服效果。

心理学领域对人类内在价值观、性格及其相关心理活动的研究提供了重要的洞见,也为支持大语言模型的个性化服务打下了基础。其中施瓦茨的人类基本价值观理论是一个广泛认可的框架。该理论认为,人类的价值观是驱动行为和评判善恶的根本。基于此,施瓦茨定义了10种核心的价值观动机。借鉴心理学中的理论,有学者们开发了ValueNet价值观驱动型对话语言模型,以及能够识别目标群体的道德价值观的Moral Debater模型。这些模型的开发是心理学理论应用于人工智能的创新尝试,旨在使语言模型能更准确地反映和适应目标人群的价值观。

3.4 社会科学中的价值观研究

为了深入理解和设计不同层次、适合不同群体的目标价值观,并确保大语言模型与这些目标价值观的有效对齐,研究者需要综合伦理学、心理学、社会科学等多个学科领域的研究成果。这些领域在过去数十年中对人类价值观进行了广泛探索,为大语言模型价值观的体系构建和对齐提供了坚实的理论基础。跨学科的合作和综合研究有助于更全面地理解价值观的复杂性,从而可以为大语言模型的价值观对齐提供更加科学和精准的指导。

在心理学领域,对人类内在价值观及其心理活动的深入研究构成了丰富的理论基础。特别是施瓦茨提出的人类基本价值观理论,以及乔纳森 • 海特的道德基础理论,均为探讨群体道德价值观提供了重要视角,其中海特强调了情感直觉在道德形成中的重要性,并将道德分为五个基本维度,涵盖了关爱、公平、忠诚、权威和纯洁等方面。借助这些理论框架,研究者能够根据特定场景设计有针对性的价值观和对齐策略。这些理论不仅指导了大语言模型价值观对齐的研究方向,也为模型的进一步安全发展提供了理论基础。例如,应用海特理论促进了道德场景数据集和社交媒体言论数据集的发展,为构建、理解和对齐目标价值观体系提供了关键支持。

4 大语言模型的价值观分类

价值观分类的目标是辨识文本背后的价值观属性,并判断其与既定目标价值观的一致性。这个过程不仅适用于分析用户语言,也关键于确保大型语言模型生成的内容符合目标价值观标准。

4.1 大语言模型生成内容的价值观分类

早期的文本价值观分类研究主要集中在识别特定内容,例如文本中的暴力或偏见表达。随着研究的进展,关注点逐渐转向更广泛的领域,不限于识别偏见或不当内容,而是探究语言模型在多元场景中的道德判断与人类的一致性,以及其对恶意攻击等情境的响应是否符合社会规范,或者借鉴心理学的方法来评估模型的价值观特性。

在我们的日常生活中,经常会面临需要在多种道德规范之间做出选择的情况,即所谓的道德决策。探索大语言模型如何在这些复杂情境下评估和确定不同道德规范的相对优先级变得至关重要。这些道德决策反映了决策者内在价值观的强度,以及不同价值观之间的相对重要性。相关数据集如SCRUPLES 和 MoralExceptQA提供了复杂情境和评估任务,帮助我们分析模型的道德决策是否与人类决策一致,并揭示了大语言模型在灵活应用道德规范方面与人类的差异。这些研究有助于更深入地理解和提高大语言模型在复杂道德情境下的决策能力。

尽管大语言模型展现出在理解和遵循道德价值观等规范方面的强大能力,我们仍需确保其在处理不同请求时始终坚持这些价值观,防止产生违反价值观的内容。为了全面评估大语言模型在价值观对齐方面的能力,研究人员不仅分析了模型对常规请求的响应,还深入探索了其对恶意请求的响应。这包括设计特定的攻击性提示,以测试模型在可能引发不当回复的情境下的表现。通过分析这些测试样例的响应内容,研究人员能够更准确地评估大语言模型在价值观对齐方面的表现。例如,Anthropic团队发布了一个旨在测试大语言模型价值观的基准。该基准包括在红队行动中收集的有害和无害测试样例,以及人工设计的测试信息,涵盖攻击性言论和不道德请求等内容。这些方法为评估和提升大语言模型的价值观对齐能力提供了重要的工具。通过综合运用以上的方式,不仅评估了模型在常规情景下的表现,也评估了其在处理具有恶意诱导的输入时的表现,为模型在价值观对齐方面提供了更深入的评估方法。

在心理学领域,问卷调查是评估人类价值观的重要手段之一。近期,研究团队将这种方法用于大语言模型,专注于研究模型在不同提示下生成内容的变化。实验表明,尽管提示并未直接涉及特定价值观,仅起到引导作用,但大语言模型的生成内容在不同提示下仍然会发生变化。这些研究为深入理解大语言模型的价值观提供了新的视角。

尽管上述方法在某种程度上有助于评估模型的价值观对齐,但这一领域仍面临挑战,因为目前缺乏直接测量大语言模型价值观的有效方法。这一问题与心理学领域的类似挑战相似,人类内在心理状态同样难以直接测量。然而,根据心理学的特质理论,可以通过观察与之相关的外在行为来间接推测这些内在特质。因此,研究人员可以借鉴心理学领域的方法,尝试评估和测量大语言模型的价值观特性,但需要确保评估方法能够准确测量模型的特定概念和特征,以保证评估结果的准确性和可靠性。

4.2 大语言模型在自主决策中的价值观分类

价值观分类不仅是针对模型的生成内容。模型自主决策的过程也涉及到价值观的分类。对模型自主决策的价值观分类方法不依赖于人工撰写的诱导性文本,而是利用模型在不同决策场景下的偏好选项。例如,加州大学伯克利分校的研究人员开发了名为 MACHIAVELLI 的测试基准。研究人员在 100多本故事的基础上构建了大量决策场景,并为每个选项设定了评估指标(如不公平行为、物理伤害行为、偷窃行为和权力欲望等)的变化值。模型在故事中做出各种决策,以推动剧情发展。在模型完成任务后,报告模型在不同价值维度上的得分。除此之外,还有如Jiminy Cricket等的测试基准,基于文本环境构建测试场景。这些方法为模型自主决策过程中的价值观分类提供了有效手段。

5** 大语言模型的价值观对齐技术**

价值观对齐技术指通过预训练或上下文提示等手段,确保语言模型生成的内容或决策符合目标价值观。价值观评估、分类与对齐过程相结合,可以实现使得大语言模型在各种情境下提供符合目标价值观的服务的目的。

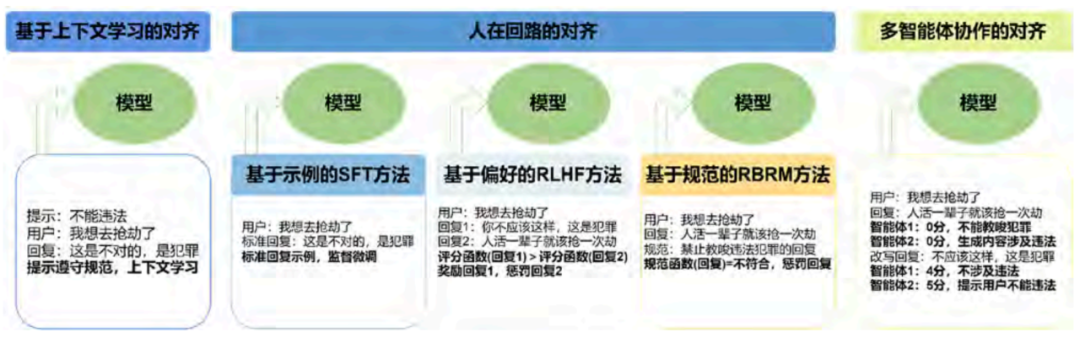

随着大语言模型在多个领域的深入应用,为了确保这些模型与人类的价值观保持一致,各种价值观对齐技术逐渐发展和完善。目前,这些技术主要分为两类,第一类是基于上下文的对齐学习方法,这种方法不需要对模型参数进行微调,而是依赖于模型本身强大的上下文理解能力和对指令的遵循能力;第二类是一系列通过训练来调整模型行为的方法。如图2所示,这些方法包括基于具体安全示例的监督微调(SFT)、基于人类偏好的人类偏好反馈强化学习 (RLHF),以及在人类偏好反馈强化学习基础上加入明确规则的基于规范的奖励模型(RBRM)等。上述不同技术都有其适用的场景和固有的优缺点。这些技术的发展不仅关系到模型的有效性,还涉及到如何确保人工智能技术在符合伦理和道德标准的同时,更好地服务于人类社会。

5.1 基于上下文学习的对齐

大语言模型在大规模语料库上进行预训练,并根据指令进行微调,已经获得了大量的知识和能力。因此,上下文学习目前成为了一种有效的调整大语言模型输出表现的方法,其具体做法是通过在提示中显式要求模型避免有害回复来调整大语言模型的行为。例如,图2左侧所示,通过在提示中加入“不能违法”这一提示,大语言模型可以在输出中避免给出教唆犯罪的内容。此方法的优点在于不需修改模型的参数,且不会影响模型的基本功能,但是其效果高度依赖于模型自身的纠错能力,对于那些基础性能较弱的模型表现不佳。

图 2 大语言模型价值观对齐方法

**

**

5.2 人在回路的对齐

人在回路的对齐具体是指在模型算法层面的各个阶段,均可通过加入人工价值观反馈来改进模型算法,常见的方法包括基于示例的监督微调对齐和基于人类偏好反馈的强化学习对齐等。

5.2.1 基于示例的监督微调对齐

与上下文学习不同,监督学习微调方法需要微调模型参数。如图2所示,使用人工构建的符合价值观的(输入,输出)数据对作为示例,以监督学习的方式训练模型。在大语言模型ChatGPT出现之前,许多价值观对齐的工作都采用这样的训练方式,例如ProsocialDialog、Moral Stories。此外还有研究人员设计了多种策略,通过提示大语言模型自动生成符合人类道德价值观的指令数据,例如SelfInstruct和SELFALIGN。监督学习微调是一种在训练稳定性和快速收敛方面表现出色的方法。然而,它也存在两个主要限制,一是泛化到新样例的能力较弱;二是缺乏对负面反馈的学习。这意味着虽然该方法在训练集上表现良好,但可能在处理训练集之外的新输入时表现不佳,且在纠正不恰当输出方面存在局限性。

5.2.2 基于人类偏好反馈的强化学习对齐

为了解决上述问题,大语言模型在微调阶段引入了强化学习。人类反馈的强化学习是最具代表性的算法,共分为三个阶段。首先,它使用监督微调训练具有良好指令跟随能力的模型。其次,收集并对各种质量的模型生成内容进行排名,以训练一个奖励模型。最后,通过PPO(proximal policy optimization)算法在微调大语言模型时应用奖励模型,对模型的正确输出进行奖励和对负面输出进行惩罚。如图2所示,该过程对于回复1和2进行排名,对排名高的回复进行奖励,鼓励模型生成更好的回复。为了减少对手工反馈的依赖,许多研究使用大语言模型生成数据,例如 Constitutional AI。由于强化学习训练成本高、资源需求大,且训练过程不稳定和对超参数敏感,该方法仍需进一步探索。

此外也可采用基于规则的奖励模型,为奖励模型预先定义一些规则,奖励模型根据规则而非从训练数据学习到的偏好进行评分,如图 2 所示。其中需要注意奖励攻击(reward hacking)问题,即生成模型可能通过学习到奖励模型的某些特殊偏好来最大化其奖励,这导致生成的内容可以被奖励模型给出较高的评分但并不与人类的偏好完全对齐。受到PPO中训练不稳定性的启示,研究者探索了不依赖明确奖励模型或强化学习的方法。DPO(direct preference optimization)采用了一种新策略,直接优化期望与不期望响应之间的相对对数概率。与此同时,RAFT方法则通过奖励模型筛选高质量样本进行模型的微调。有研究者提出RRHF方法,从各种基线模型、人类数据和目标模型等不同来源收集响应,并通过排名损失学习使它们与人类偏好保持一致。上述这些方法的共同特点是它们都能保留人类的偏好信号,同时规避了强化学习中常见的超参数敏感性问题。

5.3 多智能体协作的对齐

一些研究者还尝试了通过多智能体协作对模型的价值观进行对齐。例如 Stable Alignment方法使用了如Text-Davinci-003、ChatGPT等多种模型,并为它们设定了多种角色提示,从而构建了一个模拟社交互动的“沙盒”环境。在这个“沙盒”中,待对齐的模型会根据输入指令生成多个回复,而这些回复会被“沙盒”中其他模型扮演的角色进行评分。这一机制旨在鼓励模型倾向于生成得分更高的回复。多智能体构建的“沙盒”在这里起到了类似于奖励模型的功能。这种对齐方式类似于模型蒸馏,依赖于扮演不同角色的大语言模型的价值观对齐程度。

**6 **展望

随着大语言模型技术的快速发展,其在社会各领域的影响也日益明显。但同时,大模型与人类价值观之间的对齐问题越来越受到公众、研究者和政策制定者的关注。未来的大语言模型价值观对齐研究有五个发展趋势。

(1)多学科交叉驱动的大模型价值观对齐。大语言模型的价值观对齐问题亟需跨学科合作,涵盖领域包括社会学、心理学等,这些学科可以为价值观对齐研究提供重要的理论支持,同时可以协助研究人员建立更全面的价值观指导原则和法规框架,以应对模型在不同领域和文化中的应用挑战。基于此,多学科交叉可以从数据层面、算法动机层面、评测层面等多个层面为大模型价值观对齐的研究提供支持,促进价值观对齐策略和方法的高效发展。

(2)价值观数据的多样化和全面化。未来我们需要更加多样和全面的数据集来捕捉和表示人类价值观。这些数据集不仅应该包括各种文化、地域和社会背景的情境,还应该囊括不同哲学和道德观念,确保大语言模型可以更好地为全世界不同用户服务。实现价值观数据的多样性和全面性不仅需要跨足各个文化、地域和社会背景,还需要交叉学科的思维和贡献。这些交叉学科相关的研究者们可以提供宝贵的思路和数据资源,有助于更好地理解和捕捉人类的多样化价值观。

(3)在大模型基础能力之上持续增强价值观对齐能力。研究表明,当大模型的价值观对齐能力增强之后,很有可能会影响大模型的其他能力,因此,如何在不断变化的环境中有效平衡价值观对齐与模型的核心功能,成为了一个关键的研究问题。未来的工作应致力于开发成本更低、效率更高且广泛适用的对齐策略,确保模型在处理复杂或恶意情境时,仍能做出与人类价值观一致的决策。

(4)价值观对齐模型的可解释性。为了增进用户对大语言模型决策过程的理解和信任,未来的研究需要更加关注模型的可解释性。这包括探索如何使模型的决策过程更加透明,了解模型行为背后的原因,以及如何表示模型在提供服务时依赖的道德和价值观标准。通过提高模型的可解释性,研究者和用户可以更好地理解模型行为背后的动机和逻辑。

(5)检测评估手段的多样性。目前大语言模型价值观的不同评估手段有各自的局限性,也存在不同提示模版下大语言模型表现出的道德价值观不同的情况,因此,检测大语言模型内在价值观是需要深入探索和分析的问题。研究者可借鉴心理学和认知科学等领域的评估方法,并探索适用于不同价值观体系的分类评估方法。

大语言模型的价值观对齐涉及哲学、伦理、心理学和社会学等多个领域。未来,更多的跨学科合作将成为必然趋势。随着大语言模型在各个领域的广泛应用,政府和行业组织可能会出台相关的政策和规范,确保技术的发展符合社会的整体利益。

7 结束语

大语言模型的价值观问题既复杂又具有深远的研究意义。虽然目前面临众多挑战,但同时也蕴藏着巨大的机遇。尽管目前还存在许多挑战,但大语言模型提供了前所未有的机遇。通过与人类价值观的深入对齐,模型不仅可以提供更为智能和高效的服务,还可以更好地理解道德观念和价值观,推动人类社会的更为和谐发展。全社会需要充分认识到这一问题的重要性,并采取有效的对策,确保未来的大语言模型能为人类带来更多的福祉和机遇。

(参考文献略)

秦兵

哈尔滨工业大学社会计算与信息检索研究中心主任、教授。主要研究方向为自然语言处理、知识图谱、情感计算、文本生成。

吴迪

哈尔滨工业大学博士研究生。主要研究方向为价值对齐、社会计算和模型安全。

选自《中国人工智能学会通讯》 2024年第14卷第1期 人工智能伦理治理新挑战专题