本文探讨了无处不在的人工智能对战斗本质的改变。将目光从人工智能取代专家转向人机互补的方法。利用历史和现代实例,展示了由人工智能操作员和人工智能/机器学习代理操作员组成的团队如何有效管理自主武器系统。方法基于互补原则,为管理致命自主系统提供了一种灵活、动态的方法。最后,提出了实现机器加速战斗综合愿景的途径,即由人工智能操作员操作战场人工智能,观察战场内的行为模式,以评估致命自主系统的性能。与任何纯粹的自主人工智能系统相比,这种方法能开发出更符合道德规范、以机器速度运行并能应对更广泛动态战场条件的作战系统。

2022 年 11 月,ChatGPT 的发布标志着人工智能(AI)发展史上的一个关键时刻。几十年来,人工智能一直是人们热衷研究的课题,但对于普通人来说,它仍然是一个抽象的概念,更多的是科幻小说或技术演示,比如 IBM 的沃森赢得了《危险边缘》(Jeopardy)。然而,有了 ChatGPT,人工智能走出了实验室,人们可以用与朋友和同事交流的方式与人工智能对话。ChatGPT 将公众对人工智能的看法从未来的可能性转变为实实在在的现实。与此同时,在距离开发 ChatGPT 的办公室千里之外,乌克兰正在将人工智能融入战场。面对俄罗斯大规模的射频干扰,乌克兰部署了人工智能增强型无人机,能够在敌对条件下,在无人监督的情况下有效运行。人工智能的这一应用并不是要进行对话或模拟类似人类的互动,而是要在传统系统失灵的情况下,增强对大型对手的作战能力。ChatGPT 的认知能力与乌克兰无人机对人工智能的功利性应用之间的对比,说明了人工智能在不同领域的多样性和变革性。

这两项人工智能应用促使美国国防部(Department of Defense,DoD)关于战场人工智能的战略思想发生了潜在转变。最初的人工智能条令强调,对人工智能系统 "适当程度的人为判断 "至关重要,"要有明确的程序来激活和关闭系统功能,并对系统状态提供透明的反馈"[5]。对 "自主和半自主武器系统的人机界面"[5] 的要求意味着一定程度的人类直接互动,通常称为 "人在回路中"(HITL)或 "人在回路中"(HOTL)。这种人类直接参与人工智能或监控错误的方式,证明了对关键流程自动化的谨慎态度。

之所以会出现这种转变,是因为人们认识到,人工智能及其不可避免的技术普及,将不仅仅是补充,而是从根本上改变战场上的行动和情报搜集,就像它已经开始改变社会上几乎所有其他地方一样。这种演变并非首次发生。就在上一代,互联网的出现和智能手机的普及彻底改变了通信和信息获取方式,以至于国防部别无选择,只能适应。与这些创新一样,人工智能也正走在一个类似的基本层面上。现在的挑战不在于试图支配人工智能的整合,而在于适应其不可避免的普遍性,在担心数据偏差、计算 "幻觉 "的情况下确保军事系统的可靠性和有效性,同时确保致命性自主武器系统的行为符合国际人道主义法(IHL)。本文件旨在探讨这些挑战,并提出缓解这些挑战的途径,同时认识到人工智能增强战争的进程不仅不可避免,而且已经开始。

讨论

2022 年,人工智能达到了一个拐点。随着电子战的加剧,乌克兰冲突迫使自主无人机快速发展。与此同时,像 ChatGPT 这样的强大语言模型的发布吸引了全球观众,尽管它们的局限性也变得显而易见。这些系统容易出现事实错误和赤裸裸的捏造,凸显了将模式识别误认为真正理解的风险。在人工智能颠覆整个行业的同时,我们也认识到,人工智能的流畅性往往掩盖了根本无法分辨真假的缺陷。

人工智能在军事上的应用提出了独特而棘手的伦理问题。根据特定数据训练的人工智能系统是实现其设计目的的强大工具。它们擅长模式识别和快速执行所学任务。但人工智能系统适应新情况的能力,尤其是在人命关天的情况下,仍然不太清楚。

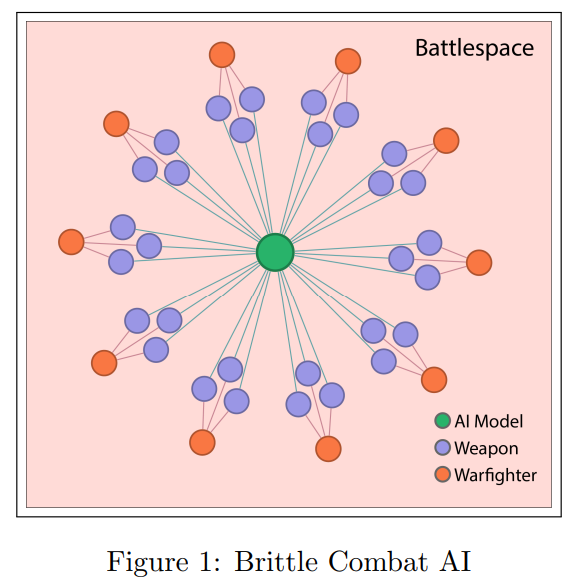

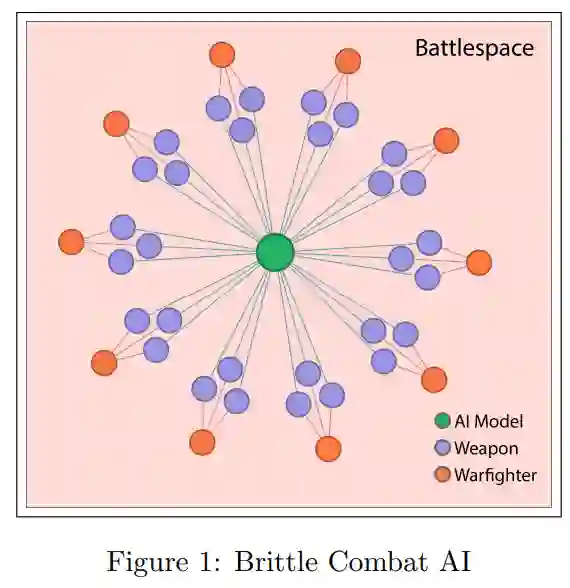

虽然人工智能在数据处理和分析方面的能力毋庸置疑,但它在道德框架内指导行为的能力却不那么确定。图 1 展示了战场自主人工智能的典型组织结构。作战人员(橙色圆圈)直接操作一套武器系统(蓝色圆圈),每套系统都通过一个人工智能模型进行调解,该模型经过训练,可控制特定武器与敌人交战。然而,如果敌人已经找到了欺骗人工智能模型的方法,作战人员往往无法改变模型的行为。相反,作战人员必须依靠其他可能风险更大的手段与敌人交战。在战争中强调简化、精简的人工智能模型会带来一种危险的脆性。当人工智能模型被愚弄时,它可能会使作战人员面临更大的风险,同时将关键优势拱手让给敌人。

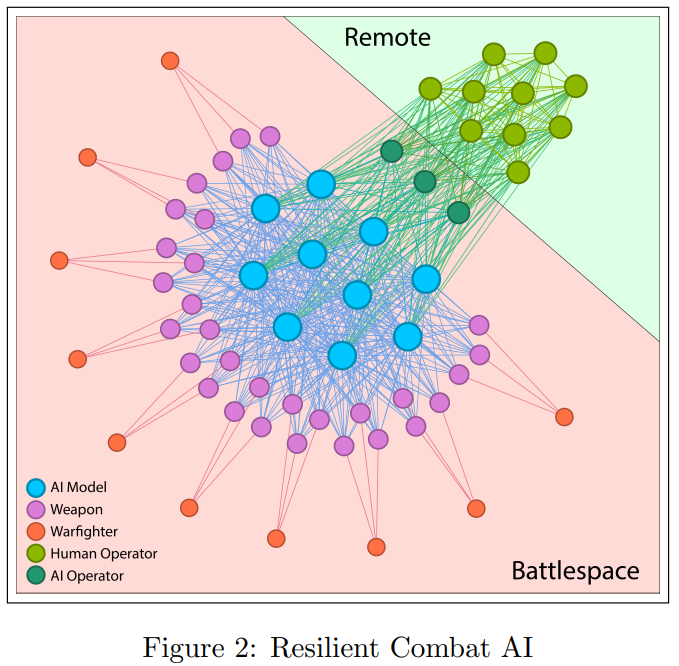

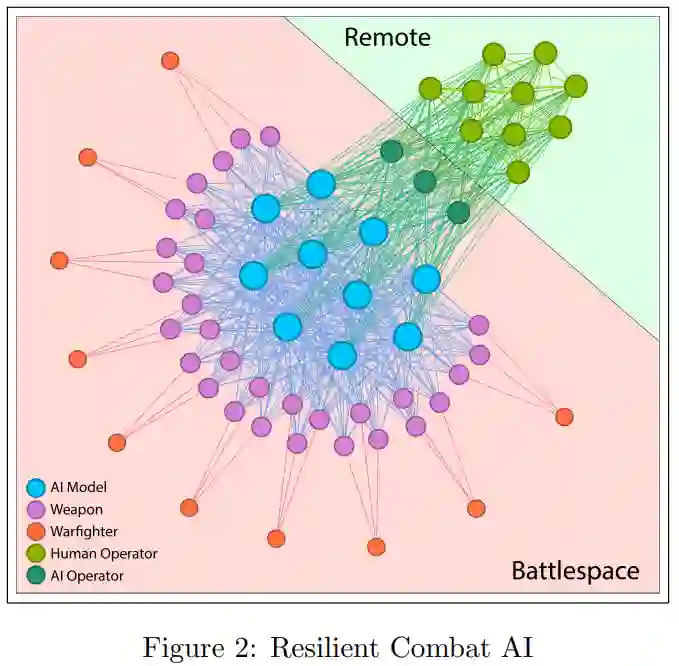

在本文中,我们提出了 3.8 节中介绍的人工智能操作员或 "马夫 "的角色。这种角色延伸了加里-卡斯帕罗夫(Garry Kasparov)在 "高级国际象棋 "中提出的 "半人马"(centaur)概念,即人类与多个国际象棋程序合作,将人类的战略洞察力与机器的计算能力相融合,以达到超高水平的竞争[21, 13]。这些相互促进或互补的领域已被证明优于任何一个单独的组成部分[23]。互补的概念是将多个元素结合在一起,产生一个比任何一个部分都更有效的整体,这与更常见的替代做法有着本质区别,替代做法是单独使用能力最强的部分--人类、自动化或人工智能。替代系统的实际结果是,它们的强大取决于最薄弱的部分。由作战人员、战场人工智能、远程人类操作员及其本地人工智能代理组成的网络可确保人类和人工智能的优势得到最大程度的发挥(图 2)。半人马概念在军事战略中的演变说明,未来人类与人工智能的合作不仅有益,而且对于在高度动态和竞争激烈的环境中取得优势至关重要。

要想让人工智能系统在军事环境中可靠运行,人类操作员必须了解人工智能的决策过程。这就意味着要对具有不同技能和背景的操作员进行培训。就像棋手调整策略一样,操作员应能根据需要切换人工智能模型。不能指望单一的人工智能模型在每一种战场场景中都能完美发挥作用。情况是不可预测的;在一种情况下最好的模型在另一种情况下可能会失效。操作员必须了解每种人工智能模型的优缺点,以确保使用最有效的工具来完成手头的任务。这种适应性是人工智能成功融入军事行动的关键。

在军事行动中,采用这种灵活的方法将人类与人工智能配对,可创建出比人工智能单独运作的系统更灵活、适应性更强的系统。这种人类与人工智能的共生关系可以破坏对手的 "观察、定位、决策、行动"(OODA)循环[18],有效地 "反客为主"。人工智能在人类直觉和经验的充实下,引入了不可预测性和复杂性,纯人工智能对手可能难以理解或实时处理这些不可预测性和复杂性。这可能会使天平向有利于人类-人工智能团队的方向发生决定性的倾斜,使他们在关键时刻超越和思考纯人工智能系统,从而获得战术优势。

人类可以利用自己的创造力和创新力提出人工智能无法提出的新想法和解决方案。例如,将人类对已知危险和风险的了解融入自主系统,可以让操作员确定并预测基于人工智能的控制器在遇到真实世界的风险因素时的行为[6]。我们还能理解人工智能忽略的细微差别和情境,这对决策至关重要。最后,人类在群体中表现最佳,每个人都能带来不同的视角和技能,从而提供深度理解,而目前的人工智能似乎可以模仿,但却无法复制。