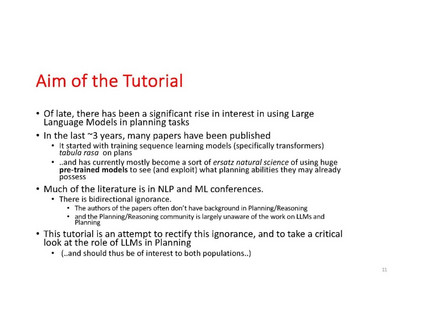

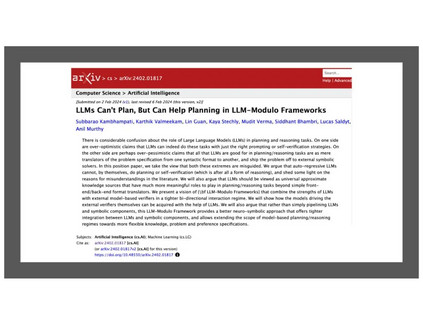

大型语言模型(LLMs,或称为加强版的n-gram模型),最初被训练用于通过反复预测上下文中前一系列词语之后的下一个词来生成文本,已经吸引了AI(以及全世界)社区的注意。部分原因是它们能够为几乎所有人类智力活动领域的提示生成有意义的完成。这种极端的多功能性也导致了人们声称这些预测文本完成系统可能具备抽象推理和规划的能力。在这个教程中,我们将批判性地审视LLMs在规划任务中的帮助能力——无论是在自主模式下,还是在辅助模式下。我们特别感兴趣的是,在AI规划社区广泛研究的问题和框架上下文中,描述这些能力(如果有的话)。 https://yochan-lab.github.io/tutorial/LLMs-Planning/index.html

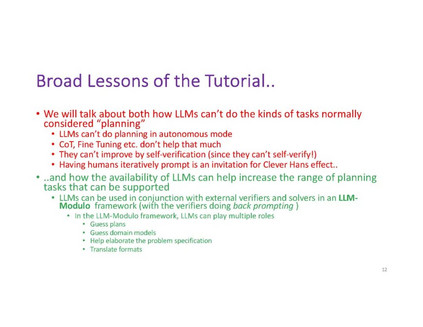

本教程将指出LLMs在生成通常需要通过组合搜索解决子目标交互的计划时的根本限制,并展示LLMs作为补充技术与AI规划社区开发的可靠规划器的建设性用途。除了介绍我们在这一领域的工作,我们还提供了许多相关努力的批判性综述,包括规划社区之外的研究人员的工作。 The preliminary list of topics to be covered in this tutorial includes: 1. Background on LLMs, and patterns of LLM use–including prompting techniques 1. Differentiating the use of transformer architectures vs. Pre-trained LLMs in planning

Mention Word2vec to plan, decision transformers, Our work on using GPT2 with fine tuning , learning verifiers 1. LLMs & Planning - Autonomous mode

Prompting in natural language or direct PDDL; effect of fine tuning; chain-of-thought prompting etc. * Limitation of self-critiquing and verification abilities of LLMs in reasoning/planning. 1. LLMs as heuristics/idea generators for planning

Connections to Case-Based and Model-Lite planning 1. Search by Back-prompting LLMS

Automated vs. Human-driven back-prompts (and the Clever Hans problem with the latter) 1. LLMs as model acquisition techniques 1. LLMs as vehicles to support general types of planning

Incompletely specified (highly disjunctive) goals; HTN planning; “generalized planning” * Use of LLMs in RL settings (to get rewards, preferences)