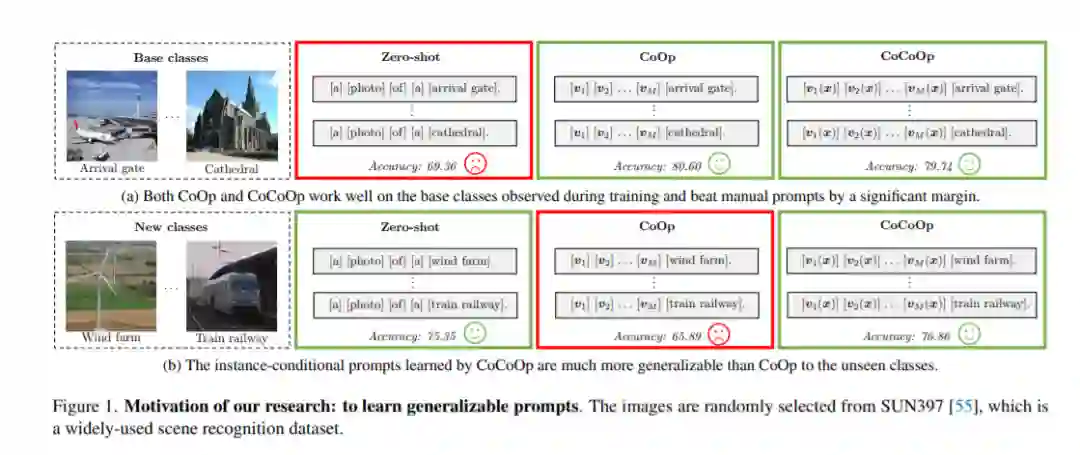

随着功能强大的预训练视觉语言模型(如CLIP)的兴起,研究如何使这些模型适应下游数据集变得非常必要。最近提出的一种名为上下文优化(CoOp)的方法将提示学习的概念引入视觉领域,以适应预训练的视觉语言模型。具体来说,CoOp将提示中的上下文单词转换为一组可学习的向量,并且仅使用少量标记的图像进行学习,可以在经过大量调整的手动提示中实现巨大的改进。在我们的研究中,我们确定了CoOp的一个关键问题: 学习的上下文不能泛化到同一数据集内更广泛的不可见类,这表明在训练期间观察到的CoOp基类过拟合。 为了解决这个问题,我们提出了条件上下文优化(CoCoOp),它通过进一步学习一个轻量级神经网络来为每幅图像生成一个输入条件标记(向量)来扩展CoCoOp。与CoOp的静态提示相比,我们的动态提示适应每个实例,因此对类迁移不那么敏感。大量的实验表明,对于不可见的类,CoCoOp的泛化效果要比CoOp好得多,甚至在单个数据集之外还显示出很好的可迁移性; 具有较强的域泛化性能。代码可在https://github.com/ KaiyangZhou/CoOp

https://www.zhuanzhi.ai/paper/8fc04028caefdfdb427ca26bc1005d6e

成为VIP会员查看完整内容