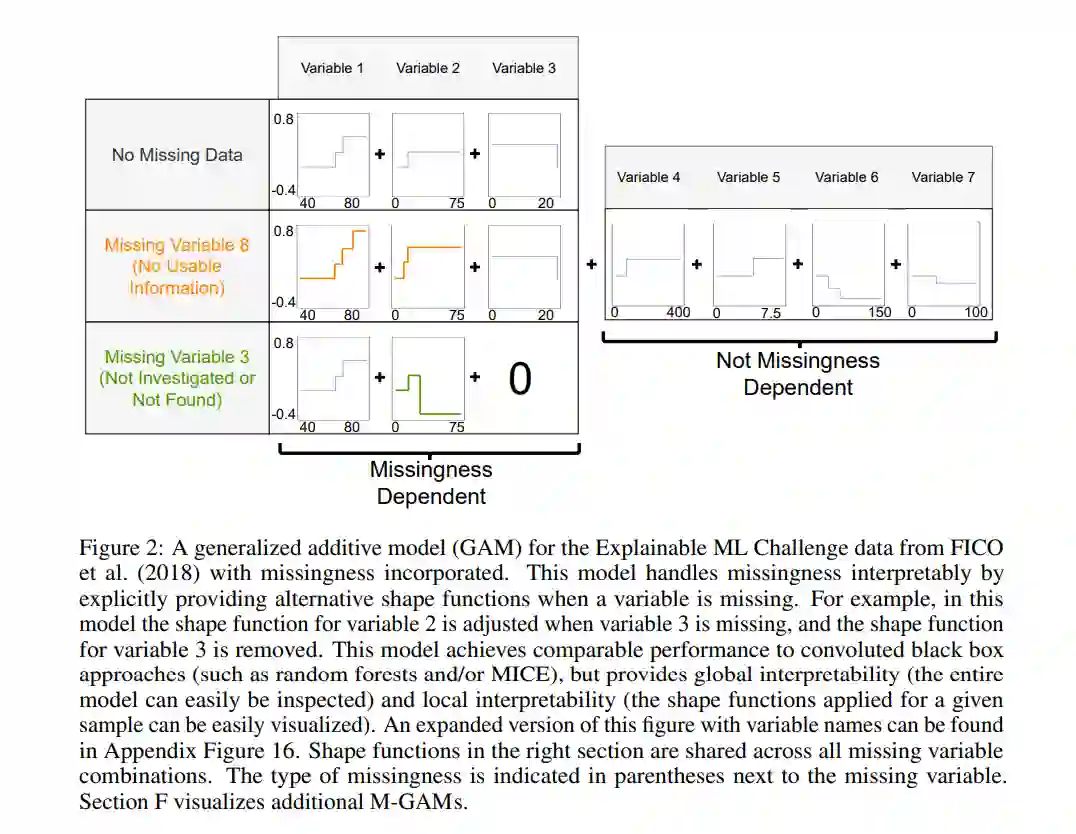

许多重要的数据集包含缺失一个或多个特征值的样本。在存在缺失数据的情况下,保持机器学习模型的可解释性是一项挑战。对缺失值进行单次或多次填补会使得模型从特征到标签的映射变得更加复杂。另一方面,基于表示缺失的指示变量进行推理会引入大量的额外项,从而牺牲了稀疏性。我们通过M-GAM解决了这些问题,M-GAM是一种稀疏的广义加性模型方法,它结合了缺失指示变量及其交互项,同时通过ℓ0正则化保持了稀疏性。我们展示了M-GAM在准确度上与现有方法相当或更优,同时相对于填补方法或简单地将指示变量纳入模型,显著提高了稀疏性。

成为VIP会员查看完整内容

相关内容

Arxiv

224+阅读 · 2023年4月7日