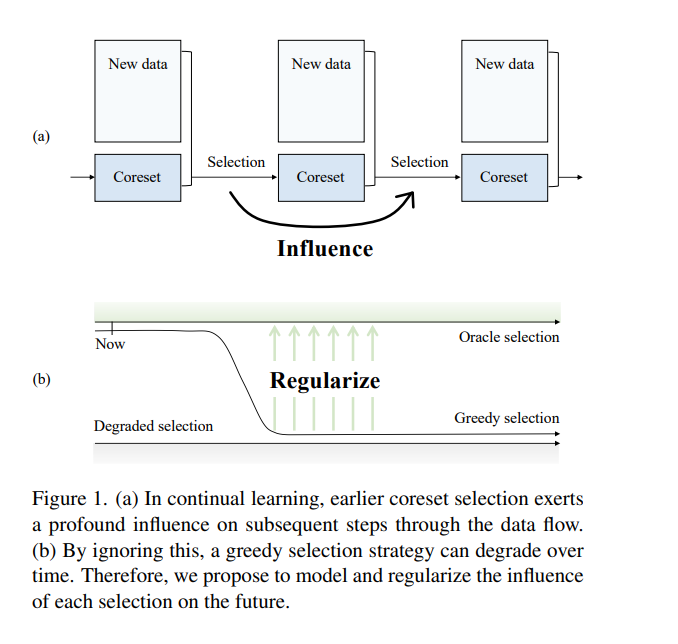

持续学习旨在在非平稳数据流上进行学习,而不会灾难性地忘记之前的知识。流行的基于重放的方法通过在一个保存已见数据的小缓冲区上排练来解决这一挑战,为此需要一个精细的样本选择策略。然而,现有的选择方案通常只寻求当前选择的效用最大化,而忽略了连续几轮选择之间的干扰。受此启发,在一个建立在影响函数上的框架内,剖析了顺序选择步骤的相互作用。本文设法确定了一类新的二阶影响,它将逐渐放大重播缓冲区中的偶然偏差,并损害选择过程。为了正则化二阶效应,提出了一个新的选择目标,它也与两个广泛采用的准则有明确的联系。此外,还提出了一种高效的实现方法来优化所提出的准则。在多个持续学习基准上的实验表明,所提出方法比最先进的方法具有优势。代码可以在https://github.com/ feifeiobama/InfluenceCL找到。

https://www.zhuanzhi.ai/paper/28e20eefe083e1afdda340661412ac46

成为VIP会员查看完整内容

相关内容

CVPR 2023大会将于 6 月 18 日至 22 日在温哥华会议中心举行。CVPR是IEEE Conference on Computer Vision and Pattern Recognition的缩写,即IEEE国际计算机视觉与模式识别会议。该会议是由IEEE举办的计算机视觉和模式识别领域的顶级会议,会议的主要内容是计算机视觉与模式识别技术。

CVPR 2023 共收到 9155 份提交,比去年增加了 12%,创下新纪录,今年接收了 2360 篇论文,接收率为 25.78%。作为对比,去年有 8100 多篇有效投稿,大会接收了 2067 篇,接收率为 25%。