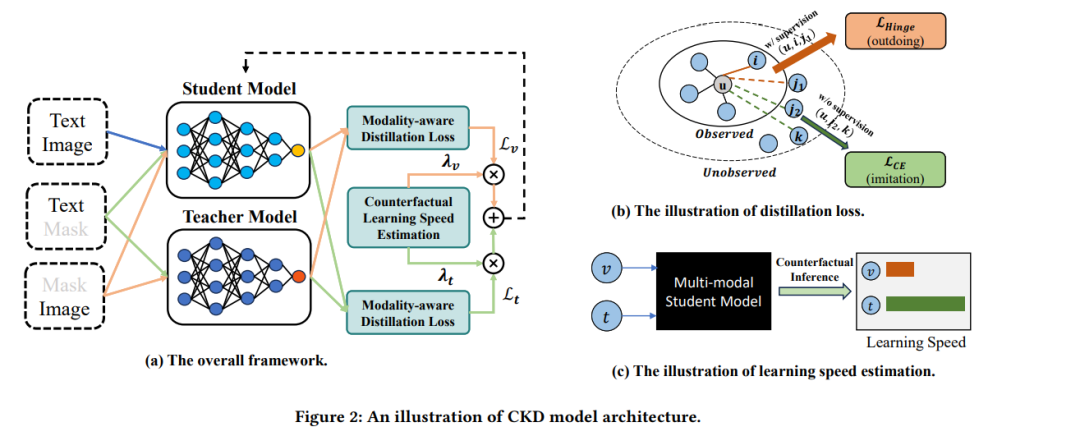

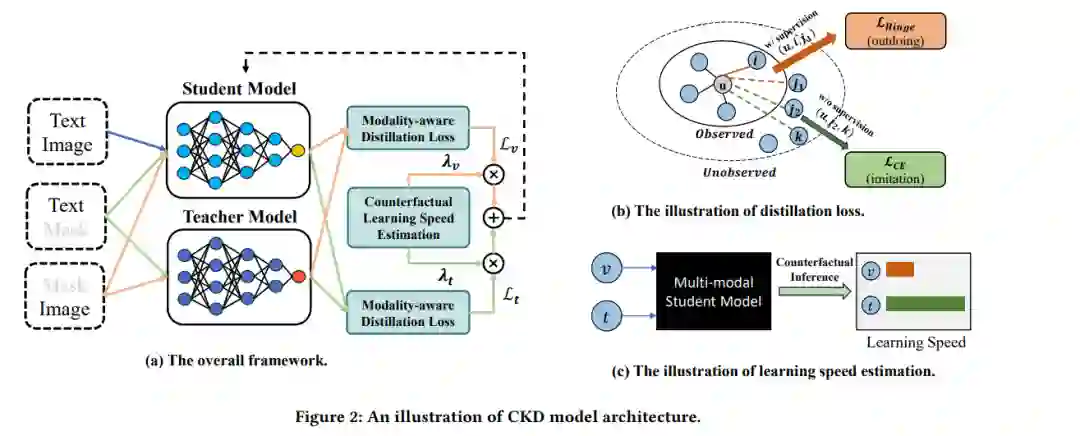

许多推荐模型已经被提出,以研究如何有效地将多模态内容信息融入传统的协同过滤框架中。使用多模态信息有望提供更全面的信息,从而带来更优异的性能。然而,整合多种模态通常会遇到模态不平衡问题:由于不同模态中的信息不平衡,在所有模态上优化相同的目标会导致弱模态的优化不足问题,其表现为收敛速度较慢或性能较低。更糟糕的是,我们发现,在多模态推荐模型中,所有模态都面临着优化不足的问题。为了解决这些问题,我们提出了一种反事实知识蒸馏方法,可以解决不平衡问题并充分利用所有模态。通过模态特定的知识蒸馏,该方法可以引导多模态模型从单模态教师模型中学习模态特定的知识。我们还设计了一种新的通用与特定蒸馏损失,指导多模态学生模型从教师模型中学习更广泛和更深入的知识。此外,为了在训练过程中自适应地重新校准多模态模型对弱模态的关注度,我们使用反事实推断技术估计每个模态对训练目标的因果效应,通过这些技术我们可以确定弱模态,量化不平衡程度并相应地重新加权蒸馏损失。我们的方法可以作为后融合和早融合骨干网络的即插即用模块。我们在六种骨干网络上进行了广泛的实验,结果表明我们提出的方法可以大幅提升性能。源码将发布在 \url{https://github.com/CRIPAC-DIG/Balanced-Multimodal-Rec}。

成为VIP会员查看完整内容

相关内容

ACM 国际多媒体大会(英文名称:ACM Multimedia,简称:ACM MM)是多媒体领域的顶级国际会议,每年举办一次。

Arxiv

42+阅读 · 2023年4月19日

Arxiv

224+阅读 · 2023年4月7日