https://hdl.handle.net/11245.1/53614a81-69a1-4671-a906-fa0672b29a92

尽管当前的神经网络模型在许多感知任务上表现出色,但这是以大量数据和计算为代价的。此外,当神经网络面对与训练数据不同或相差甚远的数据时,往往会表现出脆弱性。一种更实际的代表性结构的动机是,通过赋予神经网络本质上代表任务或手头数据类型的结构,可能避免或减轻对大型数据集和计算的需求以及神经网络的缺乏鲁棒性。非平凡的任务和数据通常具有内部结构,这种结构在输入表示中并没有显式表示。在图像中,相邻像素通常是相关的;视频通常在相邻帧中有小的变化;场景由可以移动的对象组成;时间序列可能具有因果或动态关系等。这种结构构成了任务的本质特征,并且不依赖于训练分布。在没有对网络的结构性约束或指导原则的情况下,这样的网络可能无法区分对任务本质重要的特征和仅由数据偶然给出的特征。这样的网络可能只能检测数据给出的偶然特征中的模式,并且在尊重某个给定任务的本质特征的分布外数据上表现不佳。另一方面,在神经网络的内部表示中表示给定任务的本质特征,可能提高模型的鲁棒性和效率。学习模型设计的任务是找到可以在模型中整合的适当结构,同时保持结构整合和学习、表示的形式和内容之间正确的平衡,而不退化为手工特征工程。

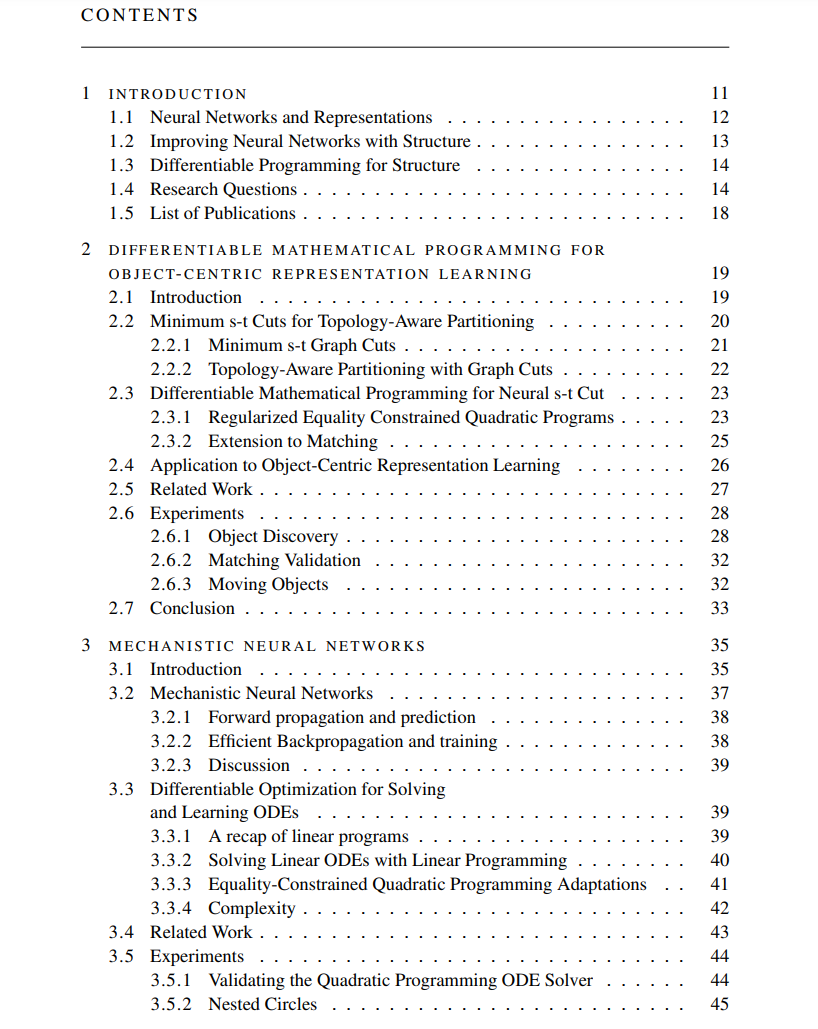

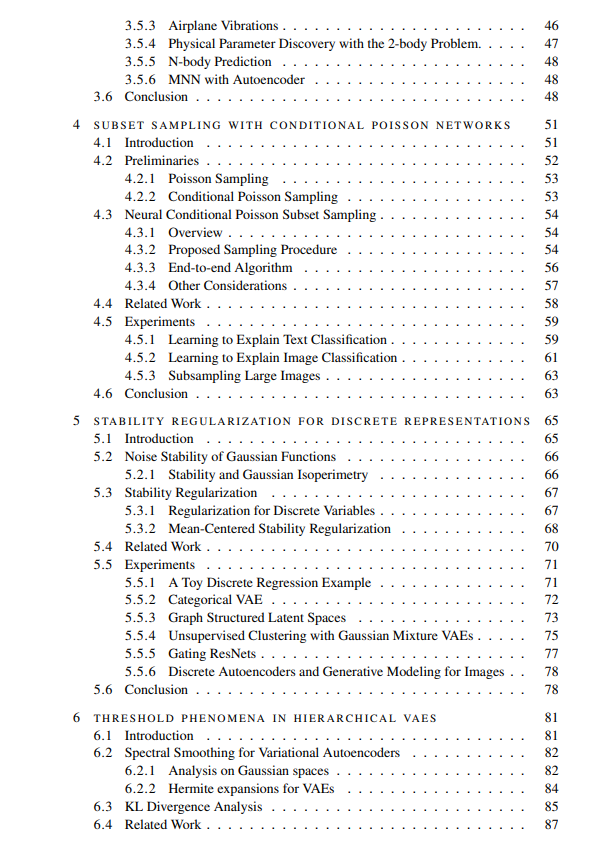

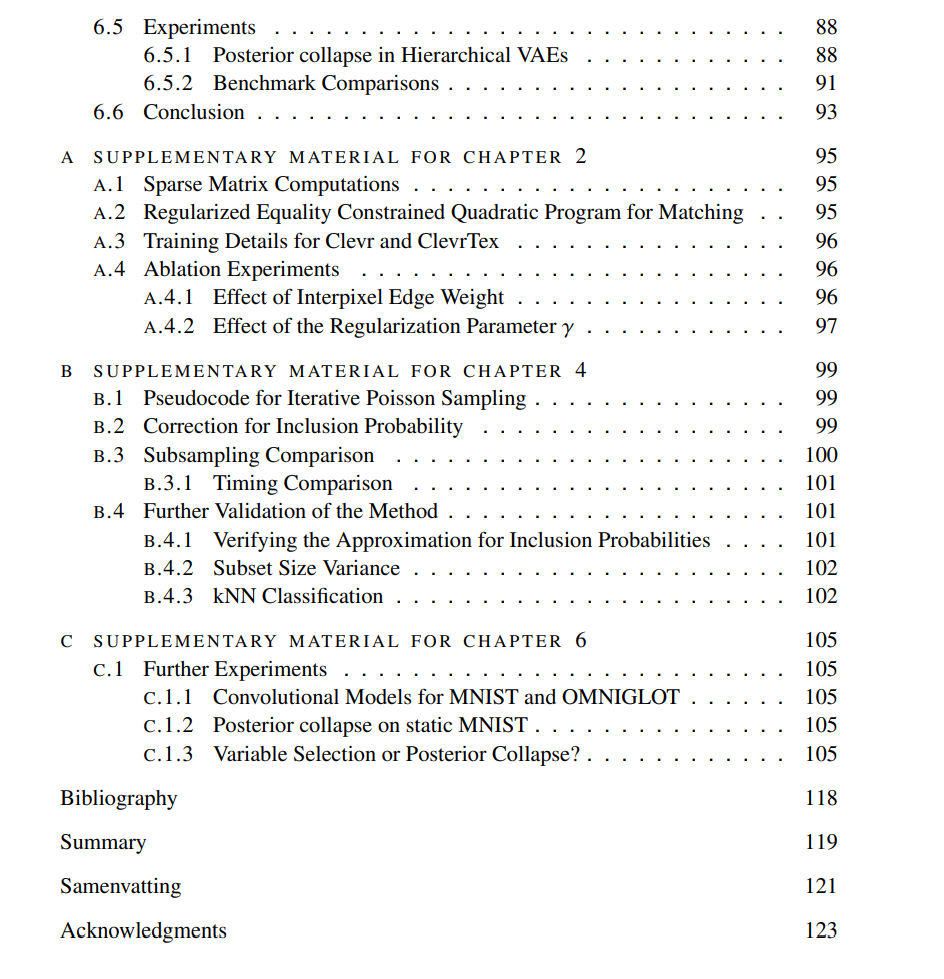

**研究问题1 可微分图分割能否在以对象为中心的表示中提高泛化能力? **在第2章中,我们聚焦于图像和视频中的以对象为中心的学习问题,并考虑特征之间的图结构关系。在本章中,我们提出了一种拓扑感知的特征分区方法,将给定场景特征划分为k个不相交的分区,作为以对象为中心的表示学习方法。对于分区方法,我们建议使用最小s-t图割,该方法表示为一个线性程序。这种方法是拓扑感知的,因为它明确编码了图像图中的邻域关系。为了解决图割问题,我们的解决方案依赖于一个高效、可扩展且可微分的二次规划近似。针对割问题的特定优化使我们能够显著更高效地解决二次规划问题并计算其梯度,与一般的二次规划方法相比。以前的以对象为中心的学习方法在纹理场景和物体以及新颖物体形状存在的情况下通常有困难。在我们的结果中,我们展示了我们的方法在具有纹理场景和物体的对象发现任务上改进了以前的方法,并且在具有新颖和未见过的纹理和形状的分布外数据上提高了泛化性能。对于我们的第二个研究问题,我们考虑代表一个神经网络表示自身动态演化的问题,通过一个可解释且适合分析的生成动态机制来管理。

**研究问题2 神经网络如何生成明确的、可解释的、可分析的动态机制来管理网络自身的内部动态演化? **在第3章中,我们提出了一类新的动态模型,称为机械神经网络,它们生成作为一组线性常微分方程(ODEs)的明确内部机制,进而管理内部神经网络表示的演化。网络表示的演化是通过解生成的ODEs来计算的。我们展示了可微分优化也可以用来在神经网络内部有效地解线性ODEs,同时允许相对于ODE参数计算梯度。该模型可以应用于动态数据以及图像等其他类型的数据,并且在其他神经网络动态系统模型上有所改进。尽管机制是内部神经网络表示的一部分,它们也是明确的,这意味着它们可以被理论和实验分析所研究。接下来,我们探讨具有子集操作的神经网络作为离散结构的下一个示例。作为应用,我们考虑解释性和子采样大图像的任务。在这两种情况下,问题是是否可以选择输入数据示例的一个子集,以某种方式代表原始输入。在解释性任务中,选择的子集是逐实例解释预测的。在子采样任务中,选择的子集是逐数据集的,并且可以看作是原始数据集的替代。以前的方法通常限于小的子集和领域大小。我们的下一个研究问题探索这个任务是否可以快速有效地完成,对于大领域和子集大小。

**研究问题3 条件泊松子集抽样是否提供了一种相比序列抽样在神经网络中更高效且可扩展的替代方案? **在第4章中,我们提出了一种既高效又可扩展到大子集大小的序列抽样的替代方法。当前神经网络方法用于抽样子集通常属于序列抽样方法(Tillé, 2006)。使用序列抽样时,如Gumbel分布这样的排名分布被用来独立地对给定全集中的每个元素进行排名,这产生了可能子集上的概率分布。要获得大小为k的子集样本,选择最大(或最小)的k个元素。选择最大k个元素(Top-k)的操作自然不是连续可微的,并且已经为Top-k操作开发了近似可微分程序。然而,这些方法对于抽样大子集在时间和内存方面都是昂贵的。此外,使用这些方法时子集大小参数不是可微分的,且使用逐实例子集大小是麻烦的。在这项工作中,我们提出使用泊松和条件泊松抽样之间的一个可微分替代方案作为序列抽样的替代方案。这种方法效率高且可扩展,内存和计算成本低,且允许可微分的子集大小。接下来,我们考虑具有离散变量的神经网络,并考虑正则化高斯函数以近似离散变量。

**研究问题4 高斯函数稳定性是否为训练具有离散变量的神经网络提供了一种可行的方法? **在第5章中,我们检查了使用高斯函数稳定性概念作为训练具有离散变量的神经网络的正则化方法。用于学习具有离散变量的网络的放松方法依赖于手动温度调整,因为网络没有指导性激励去获得离散表示。这项工作提出了一种正则化方法,其中放松的程度作为稳定性项包含在损失函数中。粗略地说,高斯函数的噪声稳定性是衡量其对噪声的抵抗力的度量。Borell的等周定理(Borell, 1985)指出,对于某个固定体积的有界函数,其范围为[0, 1],噪声稳定性由半空间的指示函数最大化。鉴于半空间指示符在高斯空间中最大化噪声稳定性,我们通过优化稳定性作为将高斯输入转换为二进制向量的简单有效方法来开发我们的方法。在最后一章中,我们从高斯函数的谐波分析的角度考虑了一个层次模型,层次变分自编码器。

**研究问题5 高斯分析对层次VAE的改进和后验坍塌的缓解有何建议? **在第6章中,我们从高斯函数分析的角度检查具有高斯变量的层次变分自编码器。具有深层随机层次的变分自编码器已知存在后验坍塌的问题,其中顶层回落到先验并变得独立于输入。在本章中,我们提出通过引入一个由高斯分析激发的平滑参数来概括VAE神经网络,以减少更高频率分量并因此参数化函数的方差。我们证明,平滑操作在层次VAE目标的KL散度项中引入了偏差-方差权衡。我们进一步展示,在这种平滑下,VAE损失表现出一个相变,其中顶层KL散度在平滑参数的一个临界值处急剧降至零,对于同一模型跨数据集是相似的。