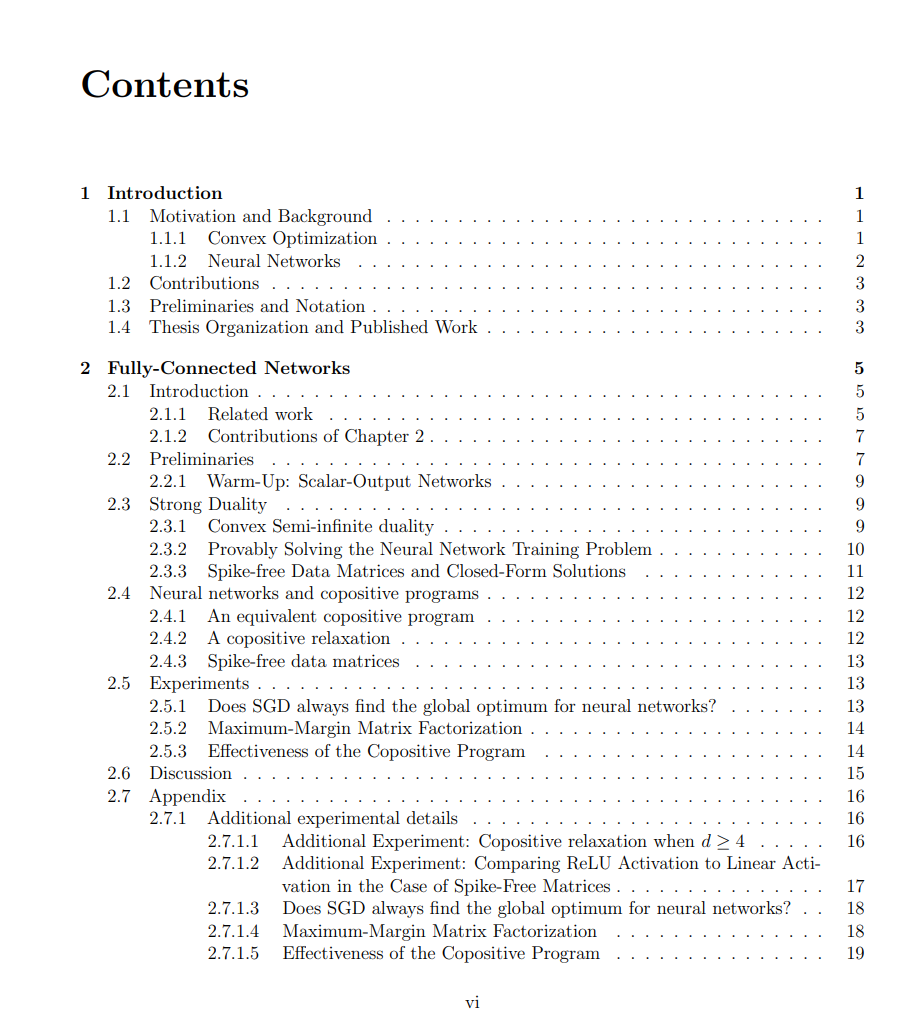

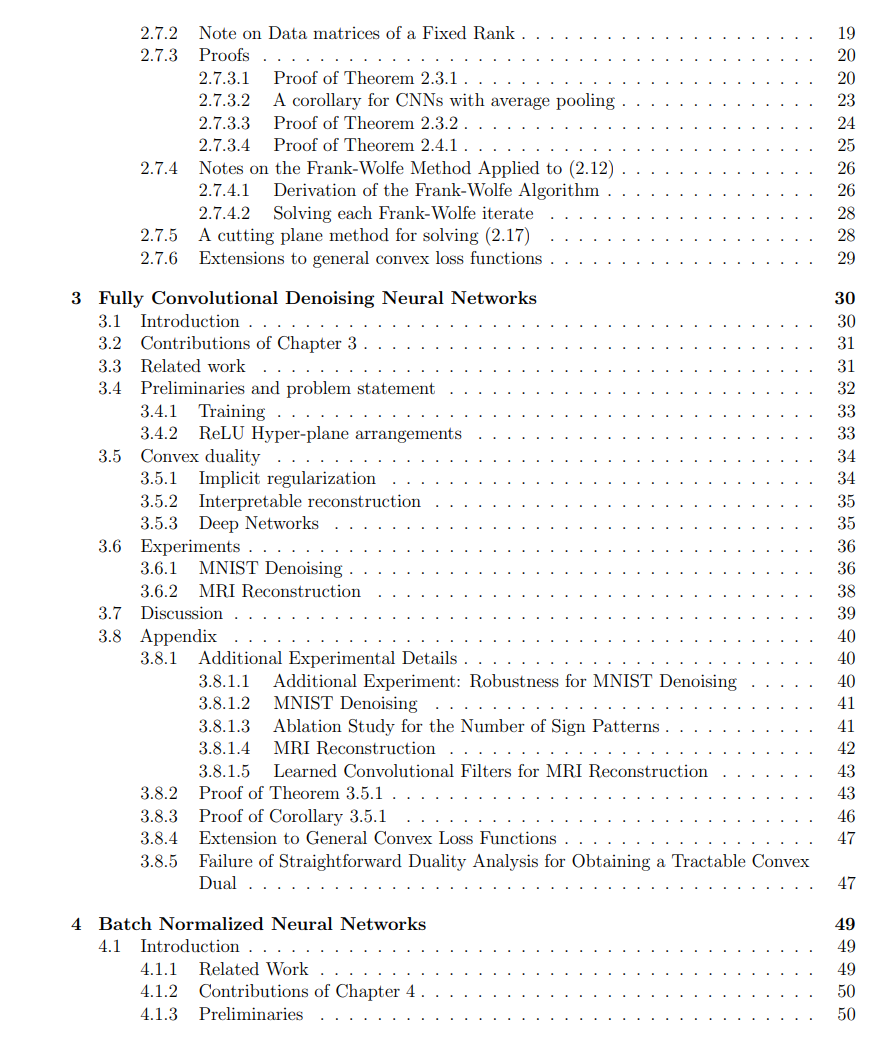

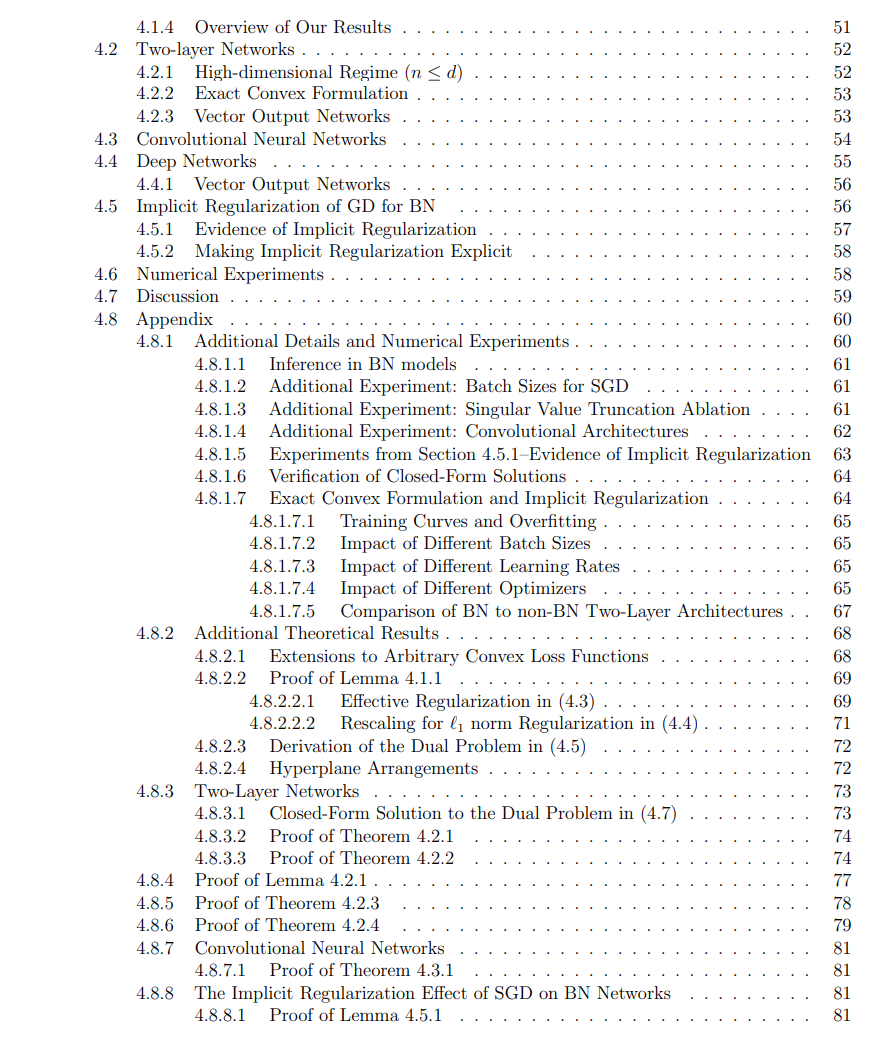

神经网络在各种机器学习任务和不同领域取得了巨大的进步。通常,神经网络依赖于启发式地优化非凸目标,这引发了对它们的透明度、效率和经验性能的质疑。在这篇论文中,我们展示了各种神经网络架构都可以适应凸优化,意味着它们的非凸目标可以通过半无限对偶公式重新构成为凸优化问题。我们首先展示对于具有ReLU激活函数的双层全连接神经网络,优化问题是凸的,并且与共积程序编程有着独特的联系,该程序具有一种促进网络中使用的激活模式数量稀疏性以及每种激活模式中活跃的神经元数量稀疏性的正则化器。我们展示了在某些数据情况下,这种公式能够获得封闭形式的解决方案,并使用共积程序编程来放松问题,使其在问题维度上为多项式时间,对于固定秩的数据矩阵而言。我们展示了解决凸形式的重构问题会比应用于原始非凸目标的启发式算法(如梯度下降)找到更好的解决方案。

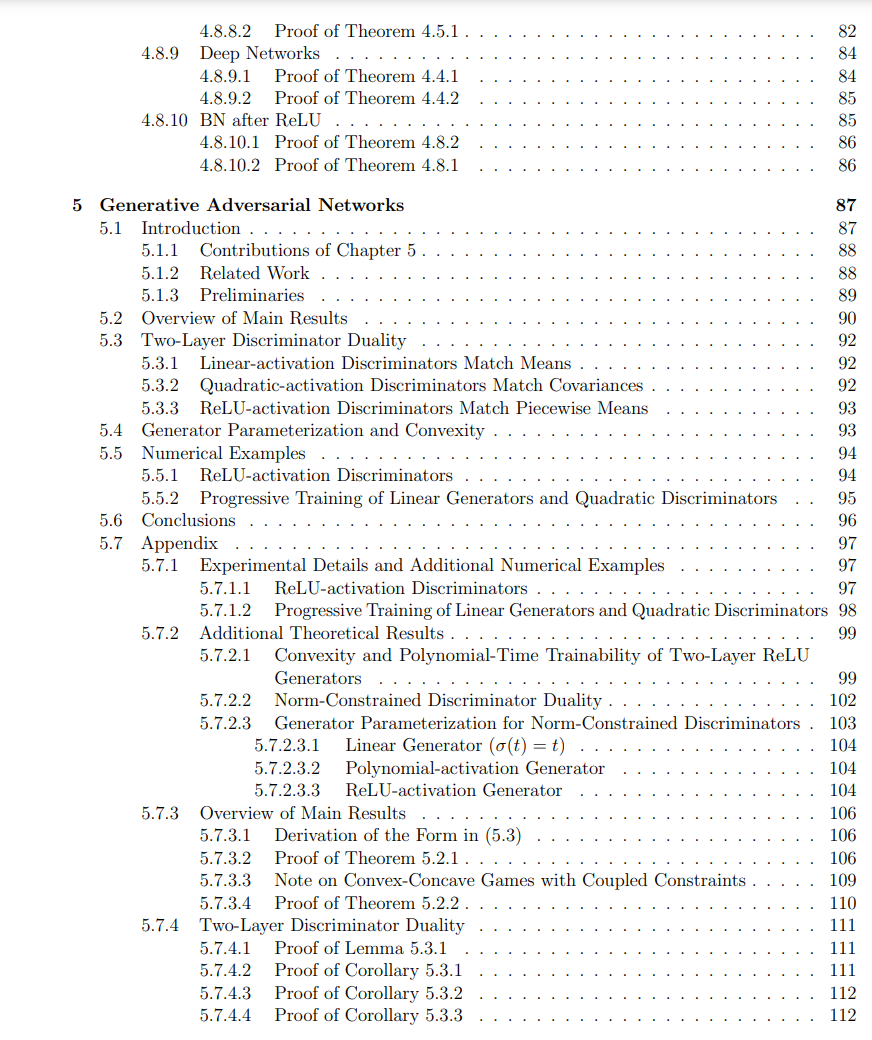

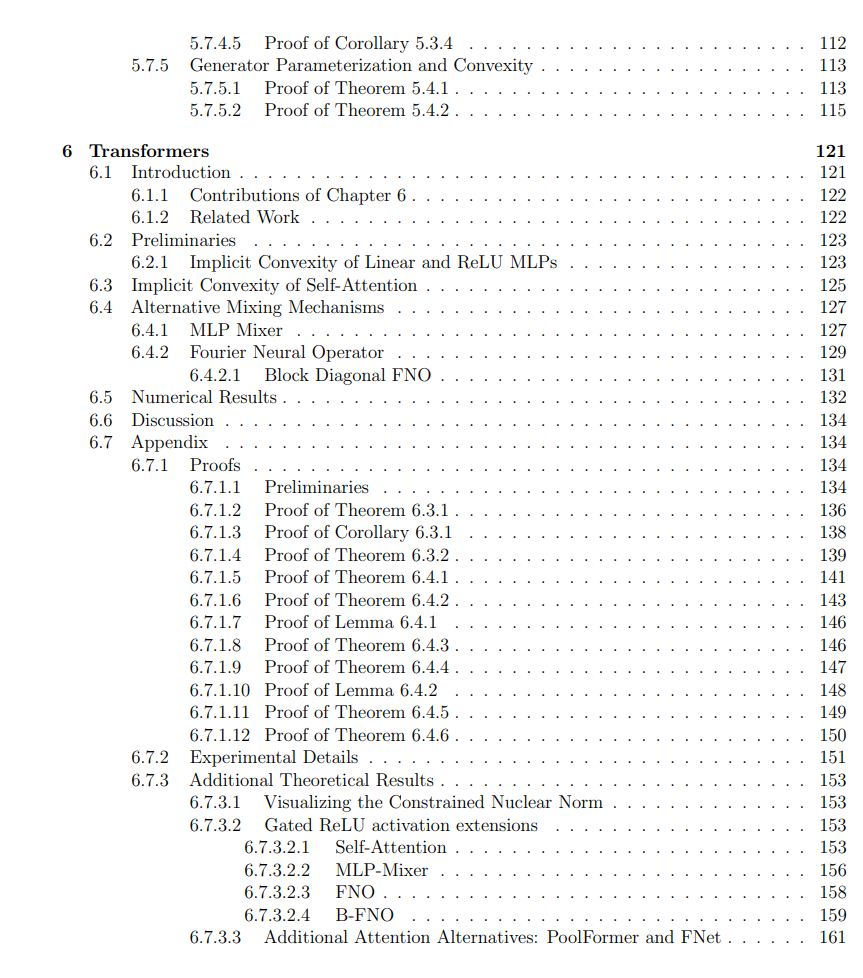

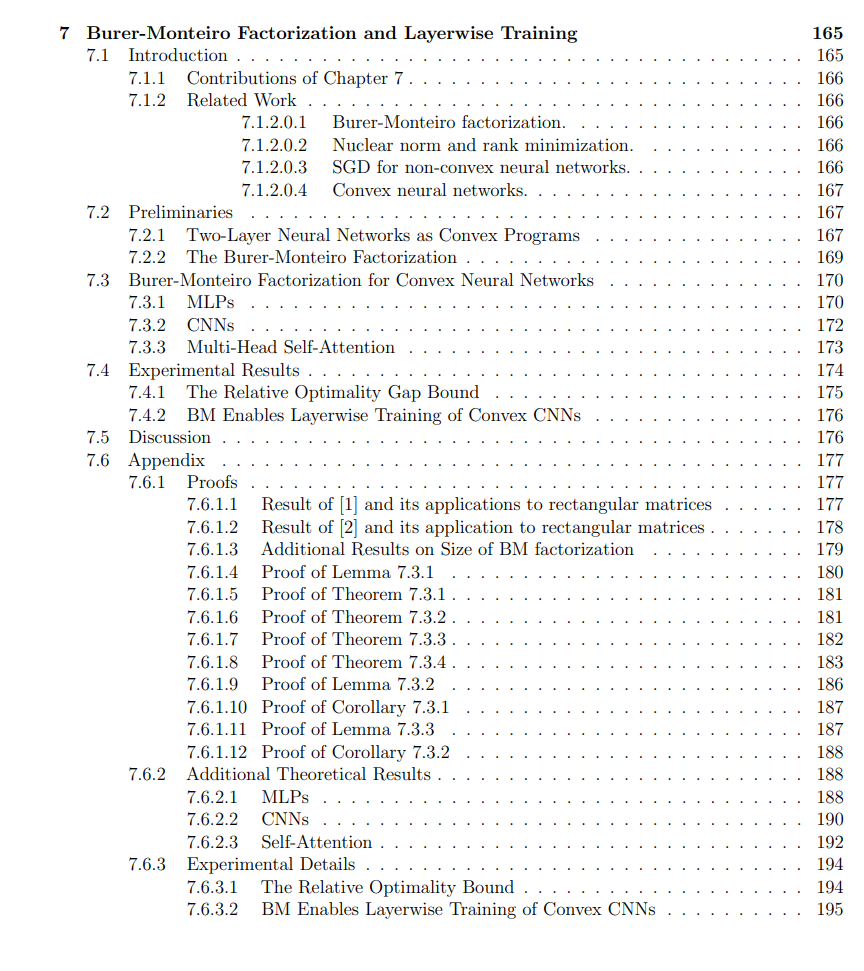

在本论文的其余部分,我们探索了不同的神经网络架构和训练机制,这些机制对凸优化公式提出了新的挑战。我们展示了对于卷积神经网络和Transformer架构,优化问题也可以接受凸重构。我们还展示了对于具有批量归一化和生成对抗网络的神经网络,相同的凸重构技术可以解开非凸优化中无法解释的方面,并对实际问题提供更快、更稳健的解决方案。最后,我们展示了这些方法可以通过Burer-Monteiro分解凸目标来扩展到更深的网络,同时保持凸保证,但允许以可扩展的方式逐层堆叠凸子网络。

神经网络在多种任务中的应用变得越来越强大和广泛。它们广泛使用的最新原因是深度学习的出现,深度学习已被证明在多种任务中有效,包括图像分类和自然语言处理。近年来,深度学习和在机器学习的基础问题上应用大规模计算和数据的步伐改变,带来了人工智能的许多突破,例如能够生成与人类撰写文本无法区分的文本的大型语言模型(LLMs),以及具有超人类准确度的图像分类器。

然而,尽管取得了成功,神经网络通常被认为是黑盒,很难理解它们为什么如此有效。这种缺乏理解是神经网络进一步发展的主要障碍。具体来说,训练神经网络的优化过程并不被充分理解,尚不清楚为何这种优化过程能产生在未见数据上表现良好的解决方案。这尤其令人困惑,因为并没有保证神经网络会收敛到全局最优解,在许多情况下,众所周知神经网络只会收敛到局部最优,这些局部最优在解决方案空间的某个邻域内是最优的,但不是最佳可能解决方案。这引发了一个问题:是否存在更好的解决方案,以及如何找到它们。此外,由于优化过程不被充分理解,神经网络训练往往是一个效率低下的试错过程,需要重度的直觉和实验来找到一个好的解决方案。在大规模机器学习的世界里,这尤其令人关注,因为训练LLMs的成本对于少数机构来说是高得令人望而却步的。 在这篇论文中,我们旨在通过理解和利用神经网络优化问题的隐含结构来解决这些问题。我们将通过找到神经网络问题的一个等价公式来做到这一点,这个公式是凸的,可以高效地解决。