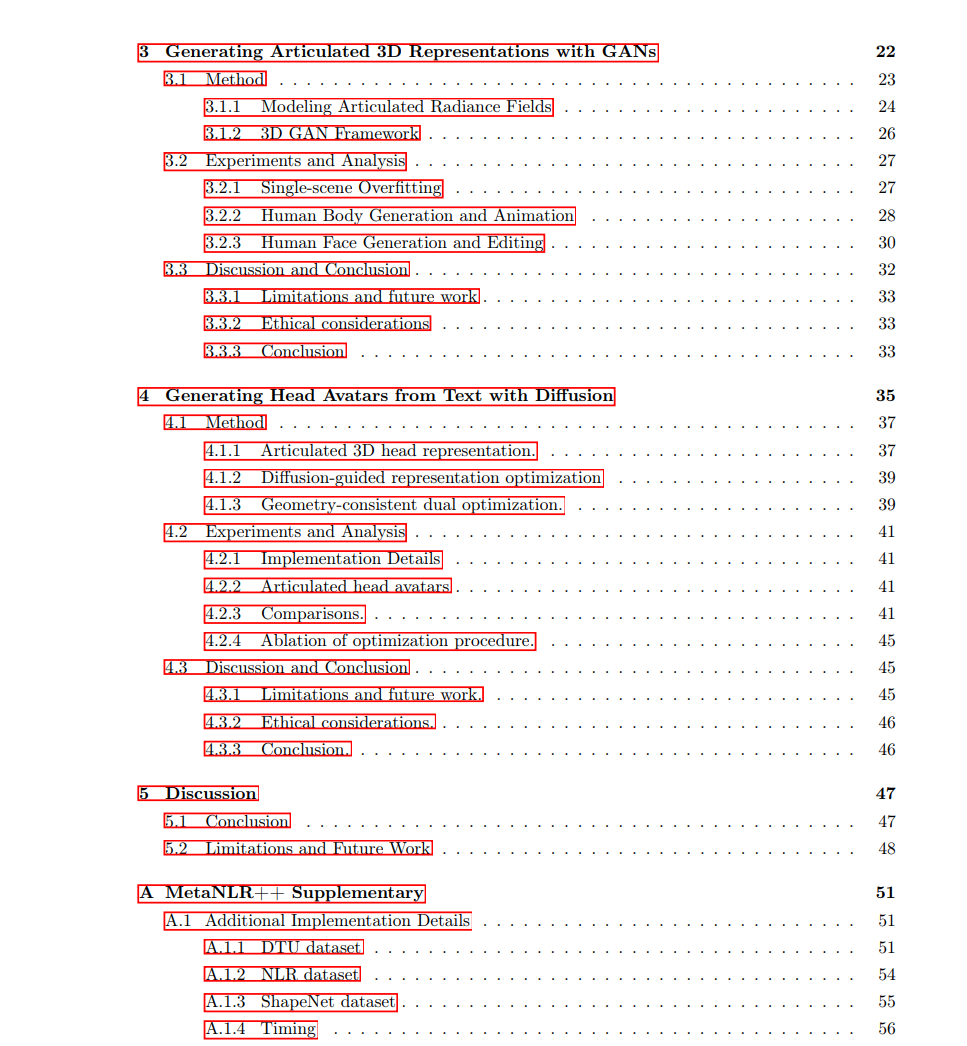

近年来,神经3D场景表示已经成为一种新的方式来存储关于3D环境、它们的属性和行为的信息,其中包括学习到的特征。与传统计算机图形表示的主要区别在于,表示的参数可以通过优化获得,目的是与观察结果保持一致。因此,它们已经成为了将计算机图形技术和机器学习技术结合起来表示3D场景的变革性工具。 这些表示在从机器人技术和遥感到电影摄影和视频编辑的应用中都有所应用。但是,这些表示受到一个事实的限制,即它们只能利用在特定单一场景中捕获的信息。具体来说,只有对单一场景的观察可以用来创建和提高这个场景的神经表示的质量。这导致了一些不受欢迎的属性,例如从观察中慢慢地创建神经场景表示,或者无法生成完全新的真实的神经场景表示。在这篇论文中,学习神经场景表示的先验知识,我提出了一种利用超出单一场景的数据中学到的信息来创建神经3D场景表示的新方法。我探讨了使用3D、图像和预训练模型作为从中学习神经3D场景表示先验的信息来源。此外,我展示了如何在我们的神经场景表示架构中构建标准计算机图形方法,以简化从未捕获完整3D几何形状的数据中学习先验的过程。

具体来说,在这篇论文中: • 我们展示了如何使用元学习从3D扫描和物体图像数据集中学习先验知识,以加速创建新物体的神经场景表示所需的优化。我们证明了使用元学习可以将从图像中的优化和神经场景表示的图像渲染时间从数小时缩短到几分钟。 • 我们提出了一个新的框架,使用生成对抗网络从仅有的2D图像集合中学习生成全新的人体和面部的3D表示。为了能够生成如人体这样的复杂物体类别,我们的方法提出了一个新颖的生成对抗网络架构,允许对生成的3D人体的身份和姿势进行独立控制。这允许对生成的3D人体进行可解释的控制。 •** 我们开发了一种方法,使用存储在2D扩散模型中的信息,仅根据文本提示创建可操作的人头的3D表示**。我们展示了使用我们的方法生成的3D资产与一个可变形的头部模型对齐,因此可以动画化面部表情和形状,与其他仅使用文本的3D资产生成方法不同。