**可解释性AI是打开AI黑盒的解释性技术的实践指南。**本实用指南将前沿研究简化为透明和可解释的AI,提供实用的方法,您可以轻松地用Python和开源库实现。从所有主要的机器学习方法的例子,这本书演示了为什么AI的一些方法是如此的不透明,教你识别你的模型已经学习的模式,并提出了建立公平和公正的模型的最佳实践。当你完成这一任务时,你将能够提高你的AI在训练中的表现,并构建鲁棒系统来抵消偏差、数据泄漏和概念漂移带来的错误。

https://www.manning.com/books/interpretable-ai

**随着图像识别、自然语言理解和桌面游戏等领域的突破,人工智能和机器学习正在彻底改变医疗、制造、零售和金融等各个行业。**随着复杂的机器学习模型被部署到生产中,理解它们变得非常重要。缺乏深刻的理解会导致模型传播偏见,我们在刑事司法、政治、零售、面部识别和语言理解中都见过这样的例子。所有这些都对信任产生不利影响,从我的经验来看,这是企业抵制在整个企业部署人工智能的主要原因之一。解释人工智能是研究和行业的一个热门话题,因为现代机器学习算法是黑盒,没有人真正了解它们是如何工作的。此外,在GDPR的“解释权”下,欧盟现在有解释人工智能的规定。因此,对于人工智能从业者来说,可解释性人工智能是一个非常重要的话题。有一些资源可以与这个活跃的研究领域保持同步,如调研论文、博客文章和一些书籍,但没有一个单一的资源涵盖所有对实践者有价值的重要技术。也没有关于如何实现这些尖端技术的实用指南。本书旨在通过提供对可解释性技术的简化解释,以及如何在Python中使用开放的公共数据集和库实现这些技术的实用指南,来填补这一空白。本书将展示代码片段,并分享源代码,以便您跟随和再现书中的图形和视觉效果。这本书旨在为您提供实现和部署最先进的可解释性技术的实用技巧。具备概率论、统计学、线性代数、机器学习和Python的基本知识。

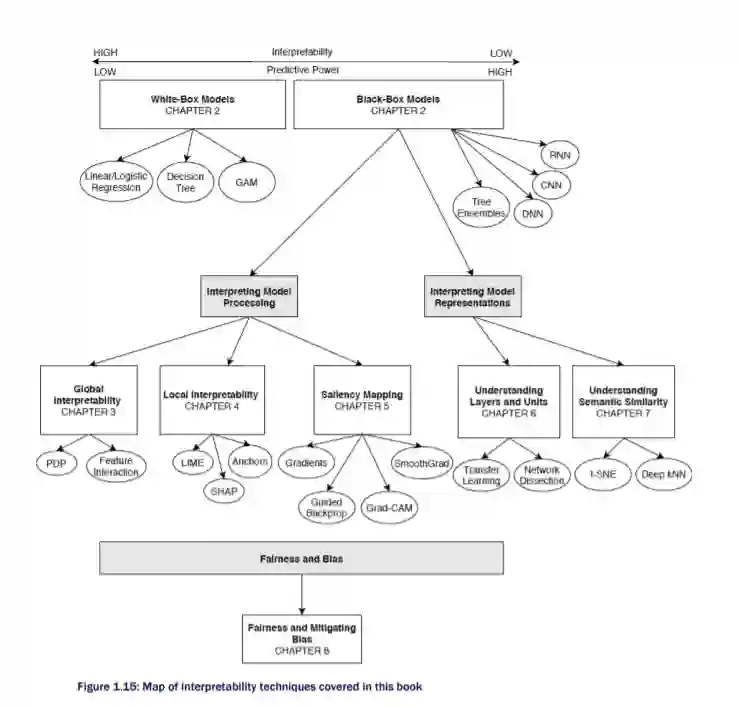

本书共分四部分,共九章。第一部分向你介绍可解释AI的世界:

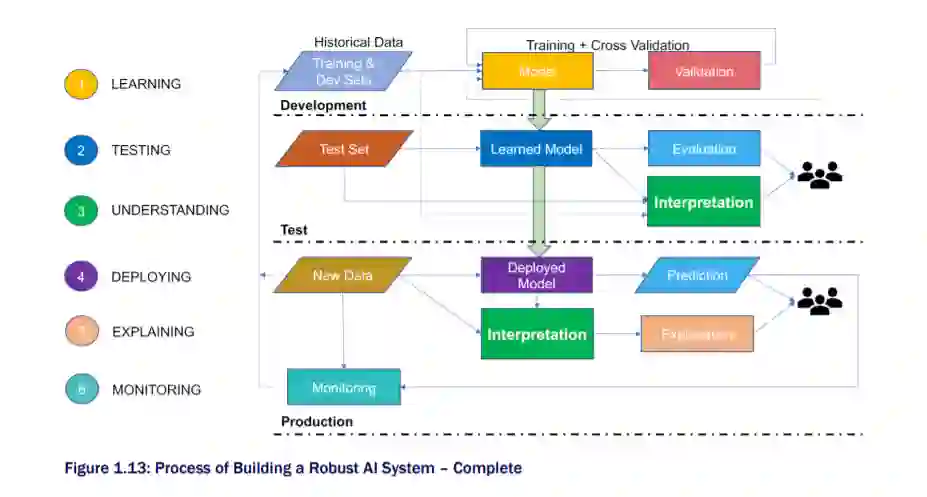

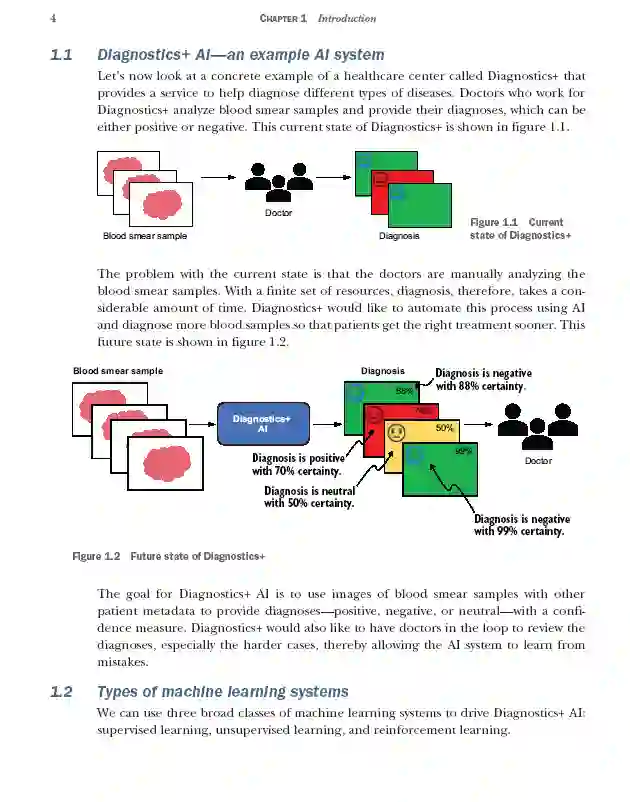

- 第一章涵盖了不同类型的AI系统,定义了可解释性及其重要性,讨论了白盒和黑盒模型,并解释了如何构建可解释性AI系统。

- 第二章介绍了白盒模型以及如何解释它们,特别关注线性回归、决策树和广义可加模型(GAMs)。

第2部分关注黑盒模型,并理解模型如何处理输入并达到最终预测:

- 第3章介绍了一种被称为树集合的黑盒模型,以及如何使用全局范围内的事后模型不可知方法来解释它们,例如部分依赖图(PDP)和特征交互图。

- 第4章涵盖深度神经网络,以及如何使用局部范围内的事后模型不可知性方法来解释它们,如局部可解释模型不可知性解释(LIME), SHapley加性解释(SHAP)和锚定。

- 第5章涵盖了卷积神经网络,以及如何使用显著性映射来可视化模型的重点,特别是关注诸如梯度、引导反向传播、梯度加权类激活映射(Grad-CAM)、引导Grad-CAM和平滑梯度(SmoothGrad)等技术。

第3部分继续关注黑盒模型,但转向理解它们学到了什么特征或表示:

- 第6章涵盖了卷积神经网络,以及如何解剖它们,以理解由神经网络中的中间或隐藏层学习的数据表示。 *- 第7章涵盖了语言模型,以及如何使用主成分分析(PCA)和t分布随机邻居嵌入(t-SNE)等技术来可视化学习的高维表示。

第四部分关注公平和偏见,为可解释AI铺平道路:

- 第8章涵盖了公平的各种定义,以及检查模型是否有偏差的方法。它还讨论了减少偏差的技术,以及使用数据表记录数据集的标准化方法,这将有助于提高与AI系统的利益相关者和用户的透明度和问责性。

- 第9章通过理解如何构建这样的系统,为可解释的AI铺平了道路,还包括使用反事实的例子进行对比解释。