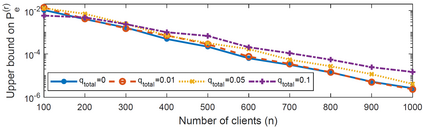

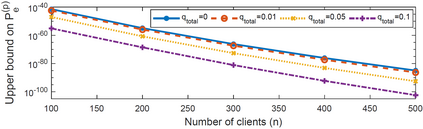

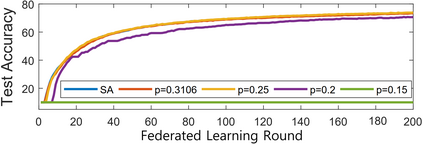

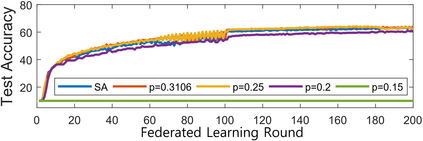

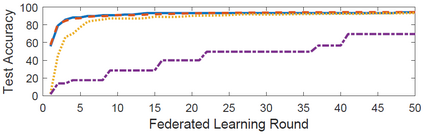

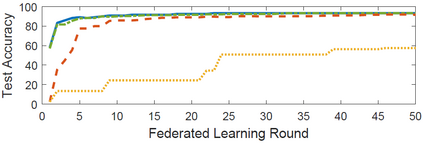

Federated learning has been spotlighted as a way to train neural networks using data distributed over multiple nodes without the need for the nodes to share data. Unfortunately, it has also been shown that data privacy could not be fully guaranteed as adversaries may be able to extract certain information on local data from the model parameters transmitted during federated learning. A recent solution based on the secure aggregation primitive enabled privacy-preserving federated learning, but at the expense of significant extra communication/computational resources. In this paper, we propose communication-computation efficient secure aggregation which substantially reduces the amount of communication/computational resources relative to the existing secure solution without sacrificing data privacy. The key idea behind the suggested scheme is to design the topology of the secret-sharing nodes as sparse random graphs instead of the complete graph corresponding to the existing solution. We first obtain the necessary and sufficient condition on the graph to guarantee reliable and private federated learning in the information-theoretic sense. We then suggest using the Erd\H{o}s-R\'enyi graph in particular and provide theoretical guarantees on the reliability/privacy of the proposed scheme. Through extensive real-world experiments, we demonstrate that our scheme, using only $20 \sim 30\%$ of the resources required in the conventional scheme, maintains virtually the same levels of reliability and data privacy in practical federated learning systems.

翻译:联邦学习被作为培训神经网络的一种方式,利用在多个节点上传播的数据来培训神经网络,而不需要节点来分享数据; 不幸的是,还表明数据隐私不能得到充分保障,因为对手可能能够从联合会学习期间传输的模式参数中提取某些关于当地数据的信息; 最近的一个解决方案是基于安全的聚合原始促成隐私保护的联合会学习,但以大量额外的通信/计算资源为代价; 在本文件中,我们提议通信-通信高效安全聚合,在不牺牲数据隐私的情况下,大大降低通信/通信资源相对于现有安全解决方案的数量; 所建议办法背后的关键思想是设计秘密共享节点的表层,作为稀散的随机图,而不是与现有解决方案相对的完整图; 我们首先在图表上获得必要和充分的条件,以保障信息-理论意义上的可靠和私人反馈学习; 我们然后建议特别使用Erd\H{o}-enyyal 图表,在不牺牲数据隐私的情况下,为现有保密方案提供理论保证; 仅用实际的30美元计划所需的数据水平,通过我们所拟议的常规计划的实际数据系统, 显示实际的可靠性/privevevisal sal plan。