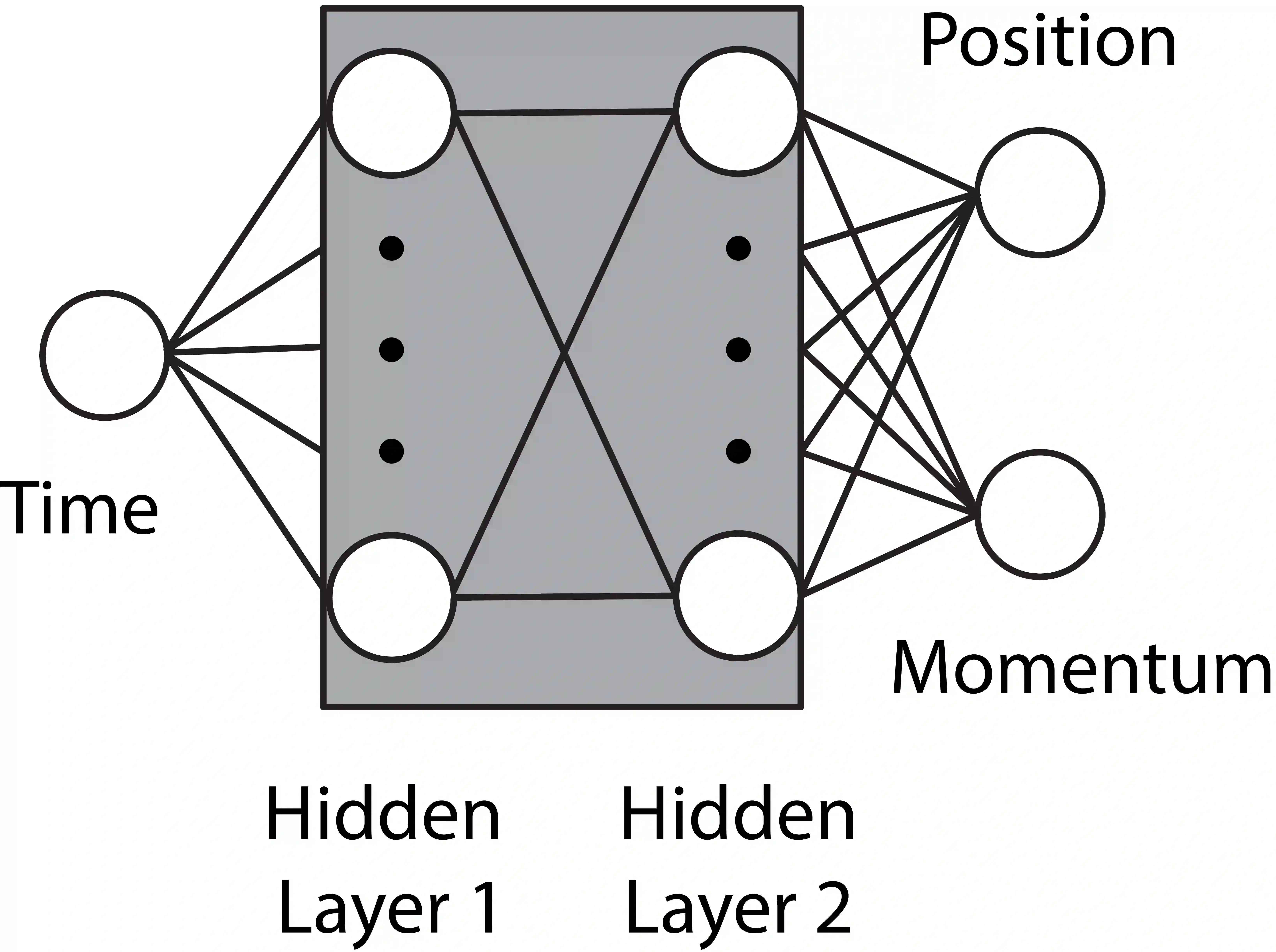

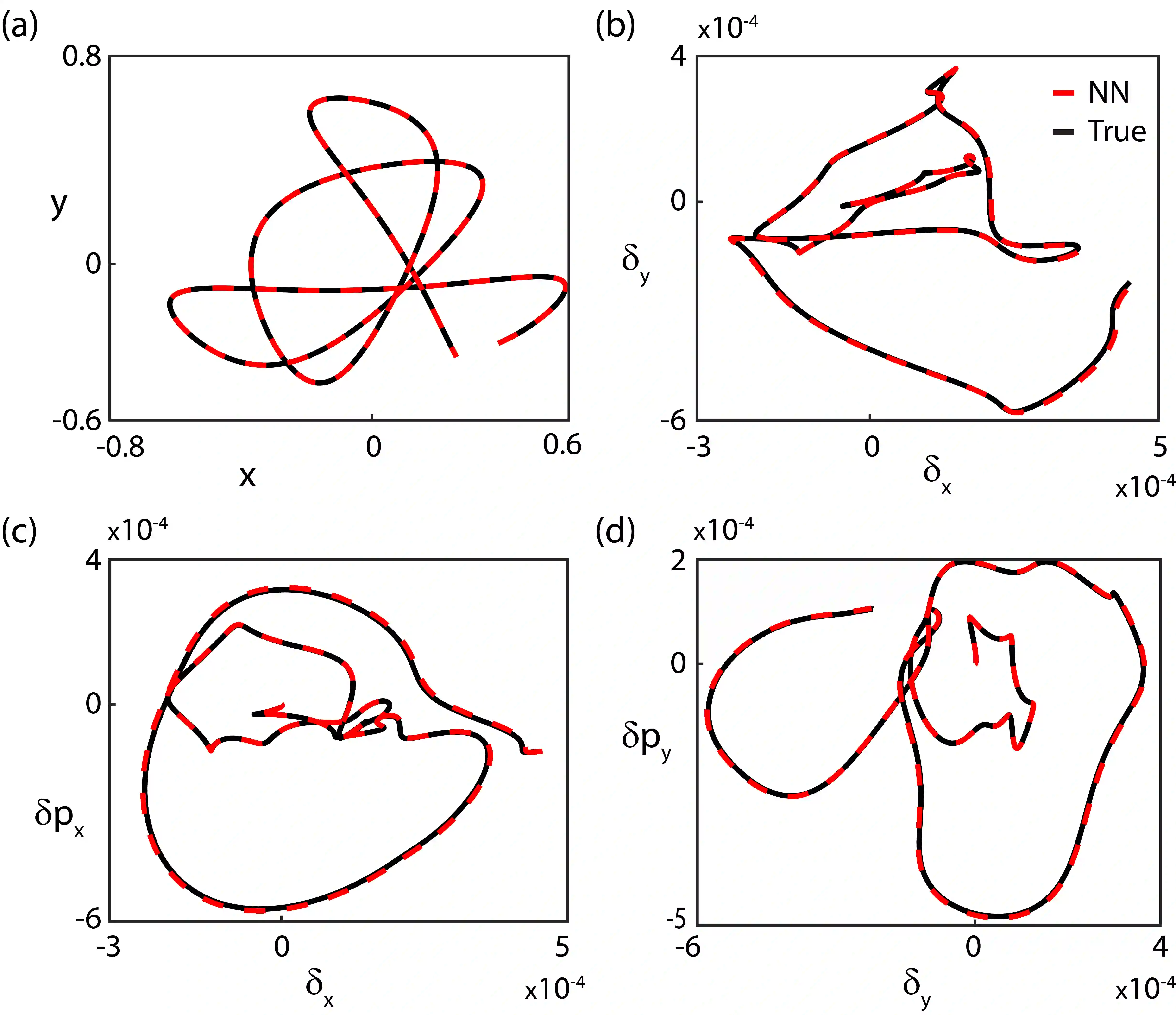

Neural networks have been identified as powerful tools for the study of complex systems. A noteworthy example is the neural network differential equation (NN DE) solver, which can provide functional approximations to the solutions of a wide variety of differential equations. Such solvers produce robust functional expressions, are well suited for further manipulations on the quantities of interest (for example, taking derivatives), and capable of leveraging the modern advances in parallelization and computing power. However, there is a lack of work on the role precise error quantification can play in their predictions: usually, the focus is on ambiguous and/or global measures of performance like the loss function and/or obtaining global bounds on the errors associated with the predictions. Precise, local error quantification is seldom possible without external means or outright knowledge of the true solution. We address these concerns in the context of dynamical system NN DE solvers, leveraging learnt information within the NN DE solvers to develop methods that allow them to be more accurate and efficient, while still pursuing an unsupervised approach that does not rely on external tools or data. We achieve this via methods that can precisely estimate NN DE solver prediction errors point-wise, thus allowing the user the capacity for efficient and targeted error correction. We exemplify the utility of our methods by testing them on a nonlinear and a chaotic system each.

翻译:神经网络已被确定为研究复杂系统的强大工具,一个值得注意的例子是神经网络差异方程式(NNDE)求解器,它可以提供功能近似于各种差异方程式解决方案的功能性近似,这些求解器能够产生强大的功能表达方式,非常适合对利益数量进行进一步操纵(例如取衍生物),并且能够利用同步和计算能力方面的现代进步。然而,在精确误差量化在其预测中可以发挥的作用方面缺乏工作:通常,重点是模棱两可和(或)全球性能衡量方法,如损失函数和(或)获得与预测有关的错误的全球界限。精确的、本地性错误量化不可能在没有外部手段或完全了解真正解决方案的情况下出现。我们在动态系统NNDE解答器中解决了这些关切,利用NDE解答器所学到的信息来制定方法,使其更加准确和高效,同时仍然采用不依赖外部工具或数据的方法。我们通过这种方法实现这一点,可以精确地估计NEDE解算出与预测错误相关的全球界限。