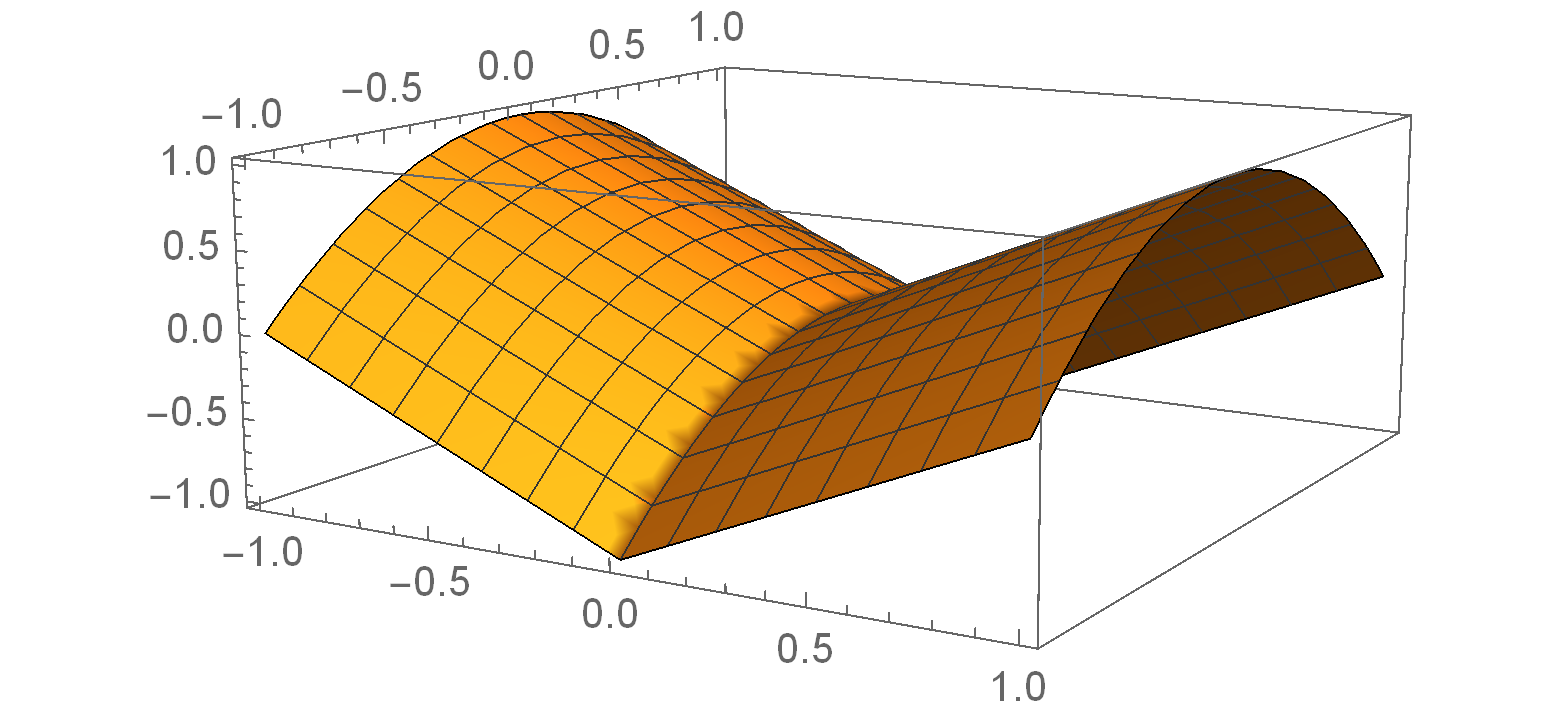

Nonsmooth optimization problems arising in practice tend to exhibit beneficial smooth substructure: their domains stratify into "active manifolds" of smooth variation, which common proximal algorithms "identify" in finite time. Identification then entails a transition to smooth dynamics, and accommodates second-order acceleration techniques. While identification is clearly useful algorithmically, empirical evidence suggests that even those algorithms that do not identify the active manifold in finite time -- notably the subgradient method -- are nonetheless affected by it. This work seeks to explain this phenomenon, asking: how do active manifolds impact the subgradient method in nonsmooth optimization? In this work, we answer this question by introducing two algorithmically useful properties -- aiming and subgradient approximation -- that fully expose the smooth substructure of the problem. We show that these properties imply that the shadow of the (stochastic) subgradient method along the active manifold is precisely an inexact Riemannian gradient method with an implicit retraction. We prove that these properties hold for a wide class of problems, including cone reducible/decomposable functions and generic semialgebraic problems. Moreover, we develop a thorough calculus, proving such properties are preserved under smooth deformations and spectral lifts. This viewpoint then leads to several algorithmic consequences that parallel results in smooth optimization, despite the nonsmoothness of the problem: local rates of convergence, asymptotic normality, and saddle point avoidance. The asymptotic normality results appear to be new even in the most classical setting of stochastic nonlinear programming. The results culminate in the following observation: the perturbed subgradient method on generic, Clarke regular semialgebraic problems, converges only to local minimizers.

翻译:实际中出现的非摩擦优化问题往往显示有利于平稳的亚结构:它们的域会分解成“动态元件”的顺差的“活性元件 ”, 通常的准分子算法在有限的时间内“ 识别” 。 识别随后意味着向平稳的动态加速技术过渡, 并容纳二阶加速技术。 虽然识别在逻辑上显然有用, 经验证据表明, 即使那些在有限的时间内没有识别活动元件的算法 -- -- 特别是亚梯度方法 -- 也会受到它的影响。 这项工作试图解释这种现象, 询问: 活跃的元件如何在非摩擦优化的“ 活性元件 ” 中“ 分解”? 在这项工作中, 我们通过引入两种有逻辑作用的特性来解析这个问题 -- 目的和亚分级的“ 目标”, 我们通过引入两个有目标的、 和亚分级的“ 平流” 来解的“ 常规” 和“ 平流” 排序结果, 然后我们开发一种( ) 平流的“ 平流的“ 平流” 方法, 在平流的平流的“ 平流”, 在平流的 平流的 平流的 平流的 平流的 的,, 的 的 的 的 的 平流结果,, 我们的 平流的平流的, 我们的 平流的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的, 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的, 我们的 的 的 的 的 和 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的 的