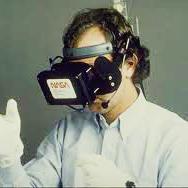

Virtual Reality (VR) is an exciting new consumer technology which offers an immersive audio-visual experience to users through which they can navigate and interact with a digitally represented 3D space (i.e., a virtual world) using a headset device. By (visually) transporting users from the real or physical world to exciting and realistic virtual spaces, VR systems can enable true-to-life and more interactive versions of traditional applications such as gaming, remote conferencing, social networking and virtual tourism. However, as with any new consumer technology, VR applications also present significant user-privacy challenges. This paper studies a new type of privacy attack targeting VR users by connecting their activities visible in the virtual world (enabled by some VR application/service) to their physical state sensed in the real world. Specifically, this paper analyzes the feasibility of carrying out a de-anonymization or identification attack on VR users by correlating visually observed movements of users' avatars in the virtual world with some auxiliary data (e.g., motion sensor data from mobile/wearable devices held by users) representing their context/state in the physical world. To enable this attack, this paper proposes a novel framework which first employs a learning-based activity classification approach to translate the disparate visual movement data and motion sensor data into an activity-vector to ease comparison, followed by a filtering and identity ranking phase outputting an ordered list of potential identities corresponding to the target visual movement data. Extensive empirical evaluation of the proposed framework, under a comprehensive set of experimental settings, demonstrates the feasibility of such a de-anonymization attack.

翻译:虚拟现实(VR)是一种令人兴奋的新消费技术,它为用户提供了一种沉浸的视听体验,他们可以通过这种体验,利用耳机设备与数字代表的3D空间(即虚拟世界)进行导航和互动。通过(视觉)将用户从真实或物理世界传送到令人兴奋和现实的虚拟空间,VR系统能够让真实生活和更多的互动版本的传统应用,如游戏、远程会议、社交网络和虚拟旅游等。然而,与任何新的消费技术一样,VR应用程序也给用户带来了重大的用户-隐私挑战。本文研究一种新型的隐私攻击,通过将虚拟世界可见的3D空间(即虚拟世界的3D空间,即虚拟世界的3D空间(即虚拟世界)的3D空间(即虚拟世界的3D空间)与实际世界感知到的物理空间空间。具体来说,VR系统系统可以通过将虚拟世界用户的直观观测到的对对应的对等等应用程序的流动与某些辅助数据联系起来(例如移动/可weabel 目标设备对综合的视觉数据进行移动/直观评估,通过用户所持的直观评估的直观评估,从而将这种直观数据转换为在虚拟世界的直观定位上显示的直观数据转换为一种直观数据流流,从而可以使世界的直观的直观的直观数据转换为一种可转换为一种可判变动的直观数据活动,使世界的直观数据流数据流到一种可转换到一种可转换到一种可转换到一种可转换到一种可转换到一种可转换到一种可转换到一种可转换到的物理活动。