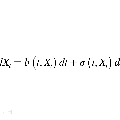

Score-based diffusion models learn to reverse a stochastic differential equation that maps data to noise. However, for complex tasks, numerical error can compound and result in highly unnatural samples. Previous work mitigates this drift with thresholding, which projects to the natural data domain (such as pixel space for images) after each diffusion step, but this leads to a mismatch between the training and generative processes. To incorporate data constraints in a principled manner, we present Reflected Diffusion Models, which instead reverse a reflected stochastic differential equation evolving on the support of the data. Our approach learns the perturbed score function through a generalized score matching loss and extends key components of standard diffusion models including diffusion guidance, likelihood-based training, and ODE sampling. We also bridge the theoretical gap with thresholding: such schemes are just discretizations of reflected SDEs. On standard image benchmarks, our method is competitive with or surpasses the state of the art and, for classifier-free guidance, our approach enables fast exact sampling with ODEs and produces more faithful samples under high guidance weight.

翻译:基于分值的扩散模型学习将数据映射到噪声的随机微分方程的反向过程。然而,对于复杂的任务,数值误差可能会累积,从而导致高度不自然的样本。以前的工作通过阈值处理来缓解漂移,该处理在每个扩散步骤后投影到自然数据域(例如图像的像素空间),但这会导致训练过程与生成过程之间存在不匹配。为了以原则的方式合并数据约束,我们提出了反射扩散模型,其反转在数据支持上演化的反演随机微分方程。我们的方法通过广义分值匹配损失函数学习扰动分值函数,并扩展了标准扩散模型的关键组件,包括扩散指导、基于似然的训练以及 ODE 采样。我们还弥合了阈值处理的理论差距:这些方案只是反射 SDE 的离散化。在标准图像基准测试中,我们的方法与现有技术相比具有竞争力或优于现有技术,并且对于无分类器指导,我们的方法通过 ODE 实现了快速精确采样,并在高指导权重下产生更忠实的样本。