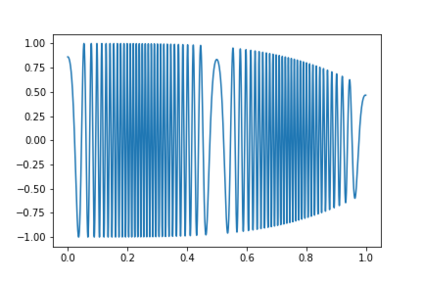

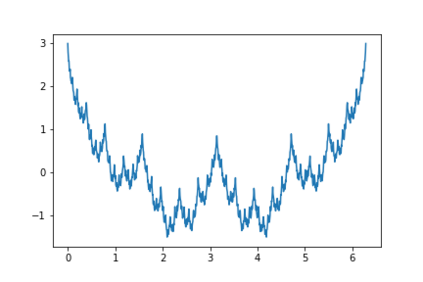

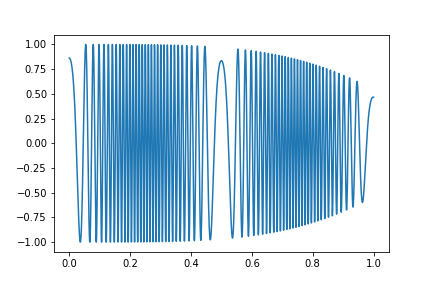

This paper develops fundamental limits of deep neural network learning by characterizing what is possible if no constraints are imposed on the learning algorithm and on the amount of training data. Concretely, we consider Kolmogorov-optimal approximation through deep neural networks with the guiding theme being a relation between the complexity of the function (class) to be approximated and the complexity of the approximating network in terms of connectivity and memory requirements for storing the network topology and the associated quantized weights. The theory we develop establishes that deep networks are Kolmogorov-optimal approximants for markedly different function classes, such as unit balls in Besov spaces and modulation spaces. In addition, deep networks provide exponential approximation accuracy - i.e., the approximation error decays exponentially in the number of nonzero weights in the network - of the multiplication operation, polynomials, sinusoidal functions, and certain smooth functions. Moreover, this holds true even for one-dimensional oscillatory textures and the Weierstrass function - a fractal function, neither of which has previously known methods achieving exponential approximation accuracy. We also show that in the approximation of sufficiently smooth functions finite-width deep networks require strictly smaller connectivity than finite-depth wide networks.

翻译:本文通过描述对学习算法和培训数据数量不施加限制,来发展深神经网络学习的基本限制。 具体地说, 我们认为, 通过深神经网络, Kolmogorov- 最佳近似 科尔莫戈洛夫 是通过深神经网络, 指导主题是 功能( 类) 的复杂性与连接网络的复杂性和存储网络表层及相关四分制重量的记忆要求之间的复杂性之间的关系。 我们开发的理论确定, 深网络是 Kolmogorov- 最优化的, 用于显著不同功能类别, 如Besov 空间和调制空间的单位球 。 此外, 深网络提供指数近似准确性( 类), 即网络中非零加权数的近似误差会急剧衰减- 倍增倍操作、 多元营养学、 类函数 和 某些平滑功能 。 此外, 这也适用于单维的骨质质流和 Weierstra 函数 - 一个显著的分质功能。 此外, 深度网络的精确性功能也不比我们所知道的精确度更小的恒定的精确性网络 。