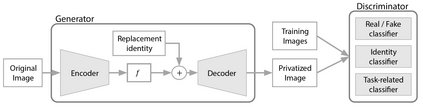

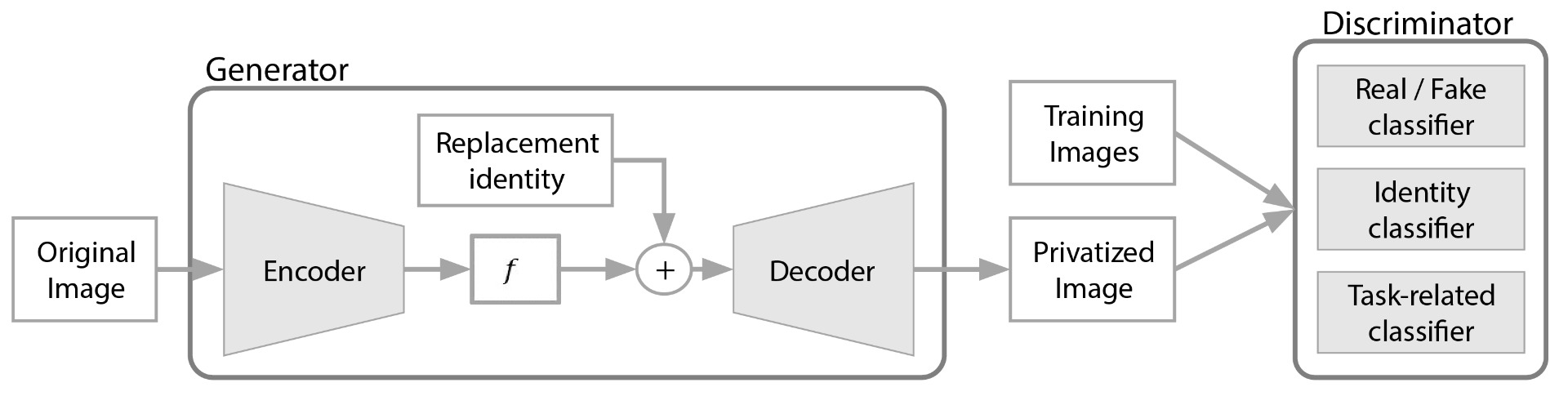

The use of Deep Learning in the medical field is hindered by the lack of interpretability. Case-based interpretability strategies can provide intuitive explanations for deep learning models' decisions, thus, enhancing trust. However, the resulting explanations threaten patient privacy, motivating the development of privacy-preserving methods compatible with the specifics of medical data. In this work, we analyze existing privacy-preserving methods and their respective capacity to anonymize medical data while preserving disease-related semantic features. We find that the PPRL-VGAN deep learning method was the best at preserving the disease-related semantic features while guaranteeing a high level of privacy among the compared state-of-the-art methods. Nevertheless, we emphasize the need to improve privacy-preserving methods for medical imaging, as we identified relevant drawbacks in all existing privacy-preserving approaches.

翻译:医疗领域深层学习的使用因缺乏可解释性而受到阻碍,基于案例的可解释性战略可以为深层次学习模式的决定提供直觉的解释,从而增强信任,然而,由此而产生的解释威胁到患者隐私,促使开发与医疗数据具体内容相符的隐私保护方法,在这项工作中,我们分析现有的隐私保护方法及其在保存与疾病有关的语义特征的同时对医疗数据进行匿名的各自能力。我们发现,PPRL-VGAN深层学习方法是保存与疾病有关的语义特征的最佳方法,同时保证在比较先进的方法中拥有高度的隐私。然而,我们强调需要改进医疗成像方面的隐私保护方法,因为我们发现所有现有的隐私保护方法都存在相关的缺陷。