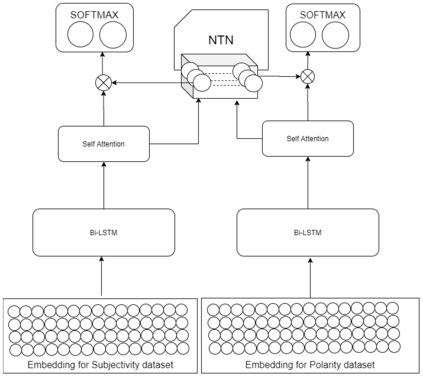

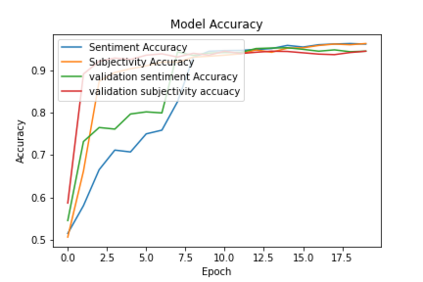

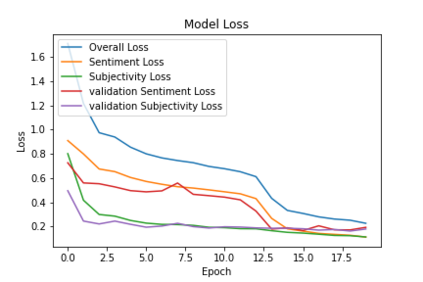

Multitask learning often helps improve the performance of related tasks as these often have inter-dependence on each other and perform better when solved in a joint framework. In this paper, we present a deep multitask learning framework that jointly performs polarity and subjective detection. We propose an attention-based multitask model for predicting polarity and subjectivity. The input sentences are transformed into vectors using pre-trained BERT and Glove embeddings, and the results depict that BERT embedding based model works better than the Glove based model. We compare our approach with state-of-the-art models in both subjective and polarity classification single-task and multitask frameworks. The proposed approach reports baseline performances for both polarity detection and subjectivity detection.

翻译:多任务学习往往有助于改进相关任务的业绩,因为这些任务往往相互依赖,在联合框架内解决时效果更好。在本文件中,我们提出了一个深度多任务学习框架,共同进行极分和主观检测。我们提出了一个基于关注的多任务模型,用于预测极性和主观性。输入句通过预先培训的BERT和Glove嵌入转化为矢量,结果显示BERT嵌入模型比Glove模型效果更好。我们在主观和极分级分类单任务和多任务框架中,将我们的方法与最先进的模型进行比较。拟议方法报告极分检测和主观检测的基线业绩。