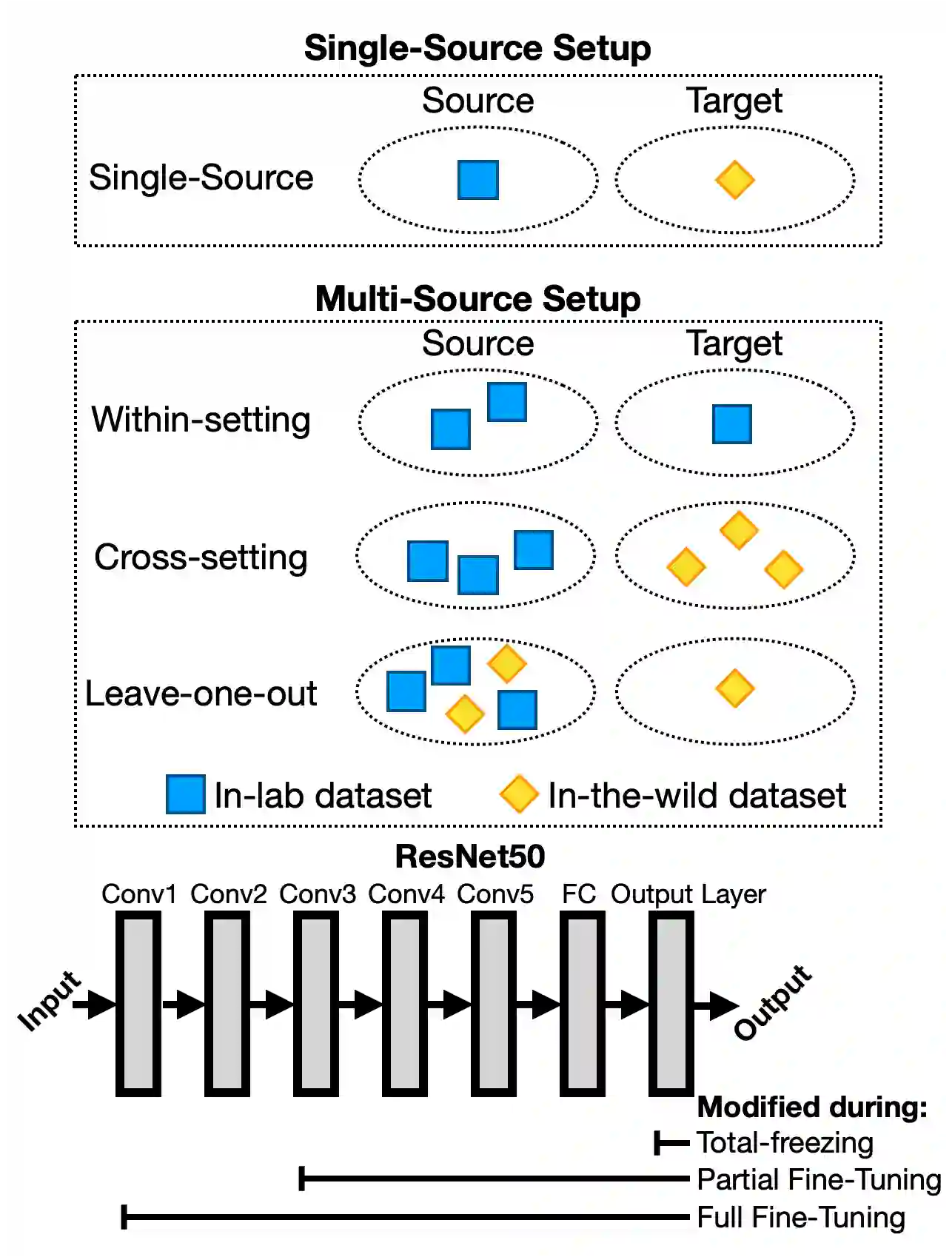

Facial Expression Recognition is a commercially important application, but one common limitation is that applications often require making predictions on out-of-sample distributions, where target images may have very different properties from the images that the model was trained on. How well, or badly, do these models do on unseen target domains? In this paper, we provide a systematic evaluation of domain adaptation in facial expression recognition. Using state-of-the-art transfer learning techniques and six commonly-used facial expression datasets (three collected in the lab and three "in-the-wild"), we conduct extensive round-robin experiments to examine the classification accuracies for a state-of-the-art CNN model. We also perform multi-source experiments where we examine a model's ability to transfer from multiple source datasets, including (i) within-setting (e.g., lab to lab), (ii) cross-setting (e.g., in-the-wild to lab), (iii) mixed-setting (e.g., lab and wild to lab) transfer learning experiments. We find sobering results that the accuracy of transfer learning is not high, and varies idiosyncratically with the target dataset, and to a lesser extent the source dataset. Generally, the best settings for transfer include fine-tuning the weights of a pre-trained model, and we find that training with more datasets, regardless of setting, improves transfer performance. We end with a discussion of the need for more -- and regular -- systematic investigations into the generalizability of FER models, especially for deployed applications.

翻译:显性表达度识别是一个商业上重要的应用,但一个常见的限制是,应用程序往往要求预测标的外光分布,目标图像可能与模型所培训的图像有非常不同的特性。这些模型在看不见的目标域上的效果如何或差?在本文中,我们提供对面部表达式识别方面域适应的系统评估。使用最先进的转移学习技术和六套常用面部表达数据集(在实验室收集的三套,在实验室收集的三套面部表达式数据集),我们进行广泛的圆柱式实验,以审查最先进的CNN模型应用的分类精度。我们还进行多源实验,我们检查模型从多个源数据集转换的能力,包括:(一) 内部设置(例如实验室实验室实验室前的实验室)、 (二) 交叉设置(例如,在模型到实验室时找到的),(三) 混合设置(例如,实验室和野生) 将学习实验转移的精度进行广泛的测试。我们发现清醒的结果是,数据传输的精度的精确性,一般数据传输程度不高。我们发现,数据传输的精度的精确度包括最差的源和最精确性的数据转换,一般的源。