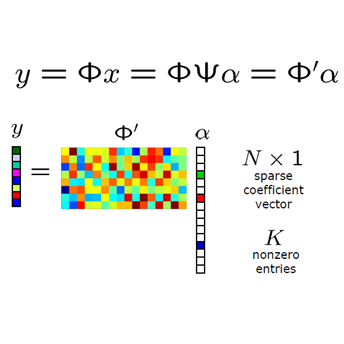

This work is concerned with the problem of recovering high-dimensional signals $\mathbf{x} \in \mathbb{R}^n$ which belong to a convex set of low-complexity from a small number of quantized measurements. We propose to estimate the signals via a convex program based on rectified linear units (ReLUs) for two different quantization schemes, namely one-bit and uniform multi-bit quantization. Assuming that the linear measurement process can be modelled by a sensing matrix with i.i.d. subgaussian rows, we obtain for both schemes near-optimal uniform reconstruction guarantees by adding well-designed noise to the linear measurements prior to the quantization step. In the one-bit case, we show that the program is robust against adversarial bit corruptions as well as additive noise on the linear measurements. Further, our analysis quantifies precisely how the rate-distortion relationship of the program changes depending on whether we seek reconstruction accuracies above or below the noise floor. The proofs rely on recent results by Dirksen and Mendelson on non-Gaussian hyperplane tessellations. Finally, we complement our theoretical analysis with numerical experiments which compare our method to other state-of-the-art methodologies.

翻译:这项工作涉及到恢复高维信号 $\ mathbf{x}\ in\ mathbb{R ⁇ n$ 的问题。 高维信号 $\ mathb{R ⁇ }\ in\ mathb{R ⁇ n$ 属于从少量量化测量得出的低复杂度的组合组合体, 我们提议通过基于两种不同量化方案( 即一位和统一的多位四分制) 的纠正线性单元( ReLUs) 的组合体程序来估计信号。 假设线性测量进程可以通过一个具有i. d. subarussian 列的感应矩阵模型来模拟, 我们两个方案都获得了接近最佳的统一重建保证, 在二次量化步骤之前的线性测量中添加了设计良好的噪音。 在一位中, 我们显示, 方案对于两种不同的量化方法( 即一位数和一位数一致的多位数制) 来说, 强性反应关系是如何精确的, 取决于我们是否寻求重建上层或下层噪音层。 证据依赖于Dirkssen 和Mendal- eximplain- eximalislationalislational- slational- salislationslationwelations