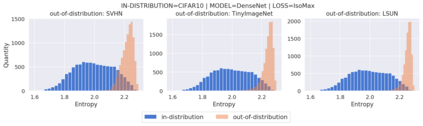

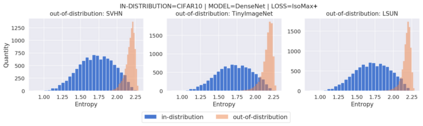

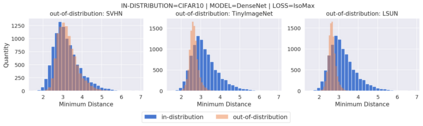

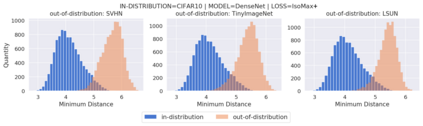

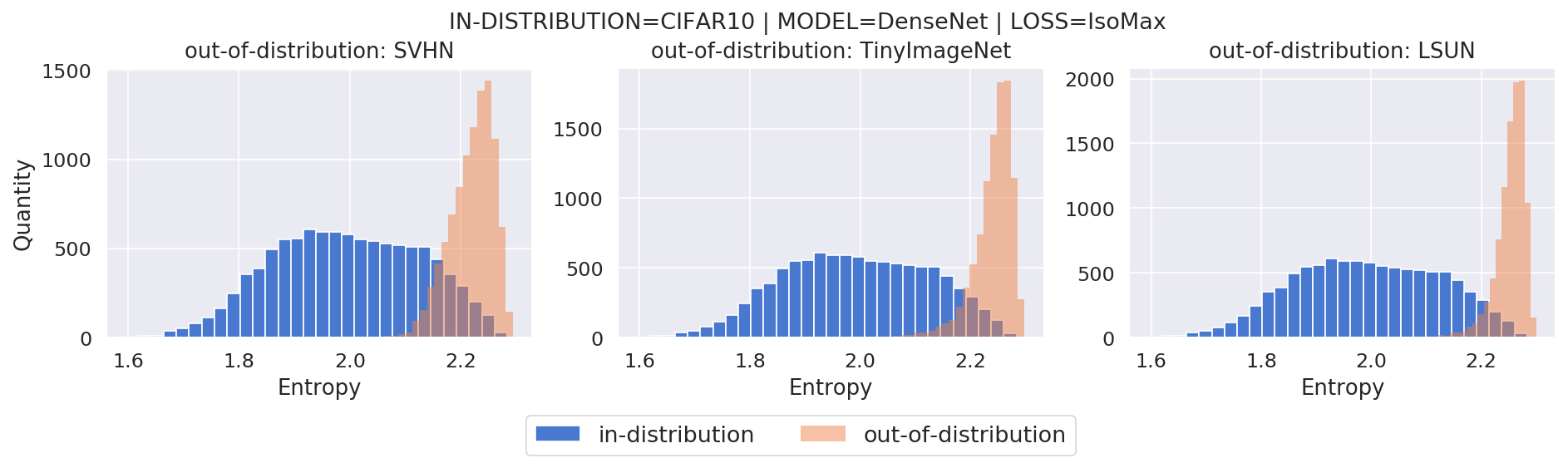

Current out-of-distribution detection approaches usually present special requirements (e.g., collecting outlier data and hyperparameter validation) and produce side effects (e.g., classification accuracy drop and slow/inefficient inferences). Recently, entropic out-of-distribution detection has been proposed as a seamless approach (i.e., a solution that avoids all previously mentioned drawbacks). The entropic out-of-distribution detection solution uses the IsoMax loss for training and the entropic score for out-of-distribution detection. The IsoMax loss works as a drop-in replacement of the SoftMax loss (i.e., the combination of the output linear layer, the SoftMax activation, and the cross-entropy loss) because swapping the SoftMax loss with the IsoMax loss requires no changes in the model's architecture or training procedures/hyperparameters. In this paper, we perform what we call an isometrization of the distances used in the IsoMax loss. Additionally, we propose replacing the entropic score with the minimum distance score. Experiments showed that these modifications significantly increase out-of-distribution detection performance while keeping the solution seamless. Besides being competitive with or outperforming all major current approaches, the proposed solution avoids all their current limitations in addition to being much easier to use because only a simple loss replacement for training the neural network is required. The code to replace the SoftMax loss with the IsoMax+ loss and reproduce the results is available at https://github.com/dlmacedo/entropic-out-of-distribution-detection.

翻译:目前的分配外检测方法通常产生特殊要求(例如,收集输出数据和超参数验证),并产生副作用(例如,分类精度下降和缓慢/低效/低效推算 ) 。 最近,由于将SoftMAx损失与IsoMax损失互换为一种无缝方法(即避免上述所有弊端的解决方案),因此建议对分配外检测方法进行无缝互换(即,避免所有先前提到的弊端的解决方案 ), 目前的分配外检测方法使用IsoMAx损失用于培训和分配外检测。 IsoMAx损失作为SftMAx损失(例如,分类精度下降和慢速/低效/低效率推算)的替补替代。 此外,我们提议用更简单的内压内压损失计算方法来取代简单的内压内压损失(例如),同时以最短的距离内压性测试方法来进行当前测试。