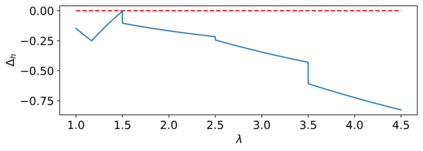

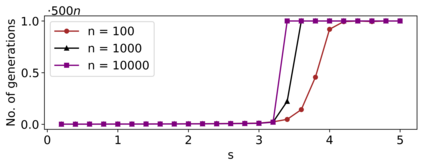

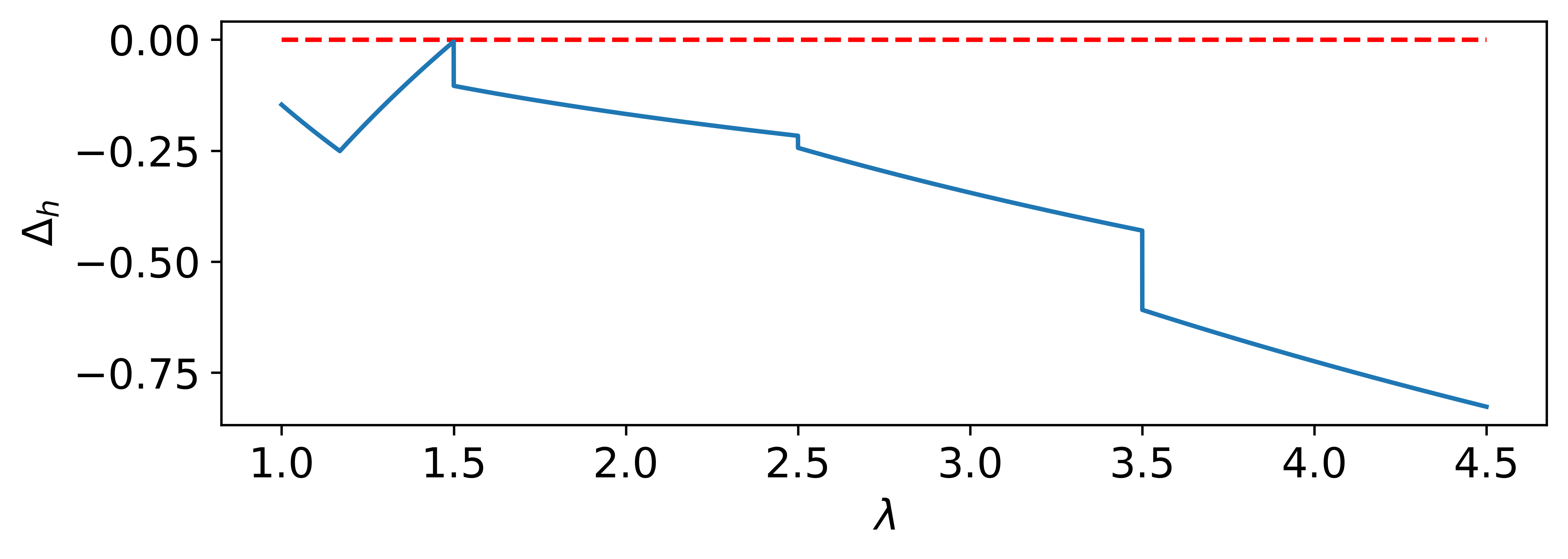

Recent theoretical studies have shown that self-adjusting mechanisms can provably outperform the best static parameters in evolutionary algorithms on discrete problems. However, the majority of these studies concerned elitist algorithms and we do not have a clear answer on whether the same mechanisms can be applied for non-elitist algorithms. We study one of the best-known parameter control mechanisms, the one-fifth success rule, to control the offspring population size $\lambda$ in the non-elitist ${(1 , \lambda)}$ EA. It is known that the ${(1 , \lambda)}$ EA has a sharp threshold with respect to the choice of $\lambda$ where the runtime on OneMax changes from polynomial to exponential time. Hence, it is not clear whether parameter control mechanisms are able to find and maintain suitable values of $\lambda$. We show that the answer crucially depends on the success rate $s$ (i.,e. a one-$(s+1)$-th success rule). We prove that, if the success rate is appropriately small, the self-adjusting ${(1 , \lambda)}$ EA optimises OneMax in $O(n)$ expected generations and $O(n \log n)$ expected evaluations. A small success rate is crucial: we also show that if the success rate is too large, the algorithm has an exponential runtime on OneMax.

翻译:最近的理论研究表明,自我调整机制可以明显地超过关于离散问题的进化算法中的最佳静态参数。 然而,这些研究大多涉及精英算法,我们对于能否将同样的机制应用于非精英算法没有明确的答案。 我们研究的是最著名的参数控制机制之一,即五分之一的成功规则,以控制非精英化的[1,\lambda]$[1,\lambda]$] 的后代人口规模。众所周知,美元[1,\lambda] 的进化算法中最固定的参数参数参数参数参数参数参数参数参数参数参数参数参数参数参数。我们发现,在非精英化的 $ {(1,1,\lambda) $ (1,1,1美元-美元) 的进化参数参数控制机制能否找到并保持合适的美元值。我们表明,答案关键取决于成功率(e,1美元+1, 美元) 和 美元(美元) 成功率。我们证明,在“一百万”的自我-ax” 成功率中,预期成功率是一定的(ial-a) 。