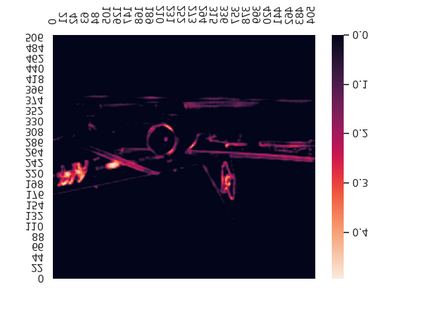

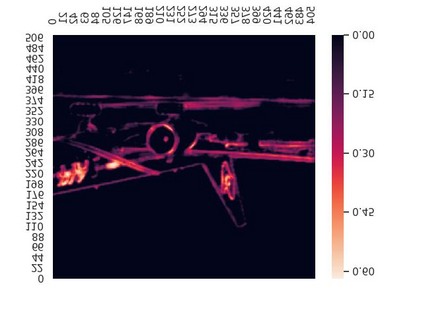

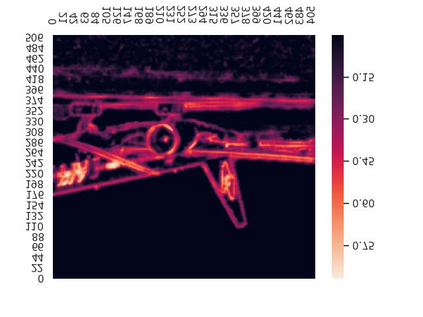

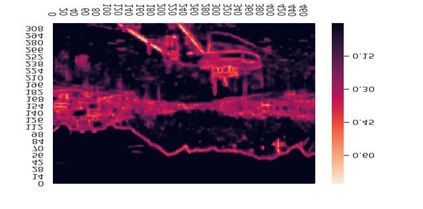

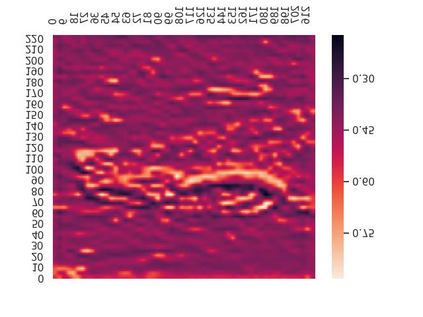

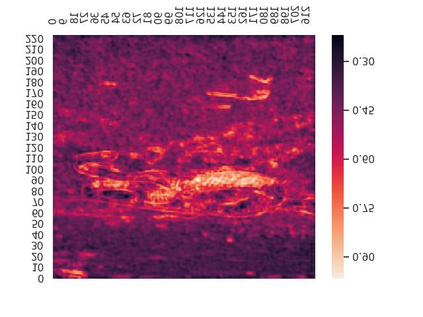

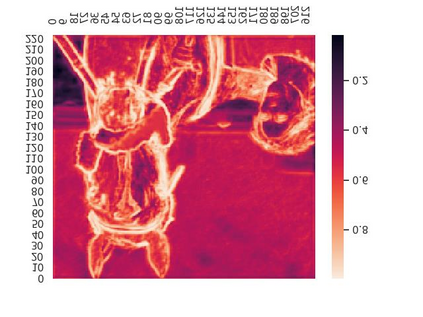

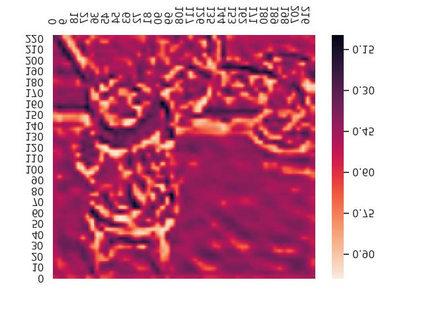

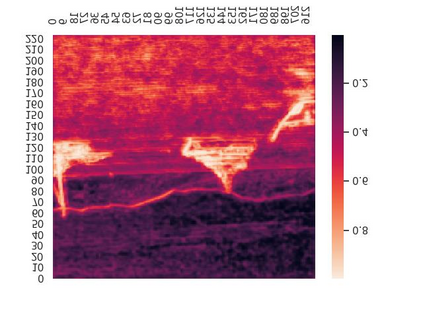

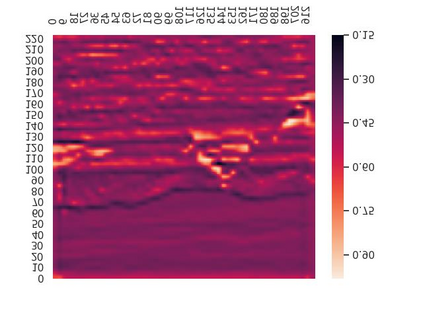

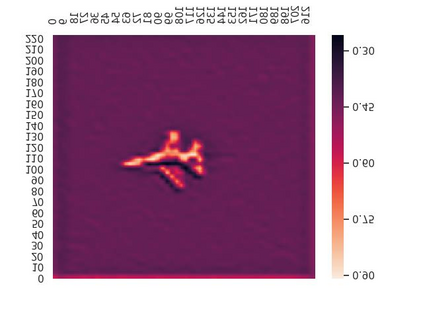

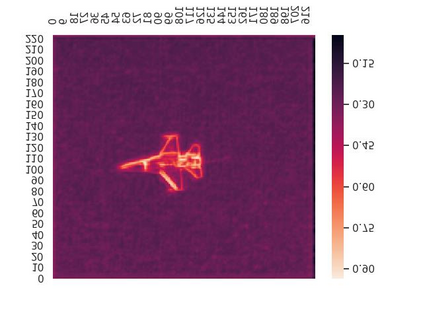

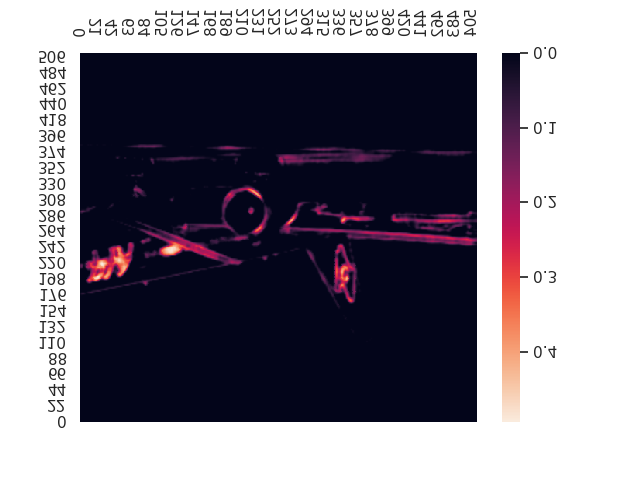

To accelerate deep CNN models, this paper proposes a novel spatially adaptive framework that can dynamically generate pixel-wise sparsity according to the input image. The sparse scheme is pixel-wise refined, regional adaptive under a unified importance map, which makes it friendly to hardware implementation. A sparse controlling method is further presented to enable online adjustment for applications with different precision/latency requirements. The sparse model is applicable to a wide range of vision tasks. Experimental results show that this method efficiently improve the computing efficiency for both image classification using ResNet-18 and super resolution using SRResNet. On image classification task, our method can save 30%-70% MACs with a slightly drop in top-1 and top-5 accuracy. On super resolution task, our method can reduce more than 90% MACs while only causing around 0.1 dB and 0.01 decreasing in PSNR and SSIM. Hardware validation is also included.

翻译:为了加速深入的CNN模式,本文提出一个新的空间适应性框架, 能够根据输入图像动态生成像素宽度。 稀疏计划在统一的重要地图下进行像素精细化和地区性适应, 从而方便硬件的落实。 还提出了一种稀疏的控制方法, 以便能够对不同精确/ 长度要求的应用进行在线调整。 稀疏模式适用于广泛的视觉任务。 实验结果显示, 这种方法有效地提高了图像分类的计算效率, 使用 ResNet-18 和 SRResNet 超分辨率 。 关于图像分类任务, 我们的方法可以节省30%- 70% MACs, 略微降低上层-1 和上部-5 的精确度。 关于超分辨率任务, 我们的方法可以减少超过90% MACs, 而只导致 PSNR 和 SSIM 的0. 1 dB 和 0.01 下降。 硬件验证也包括在内。