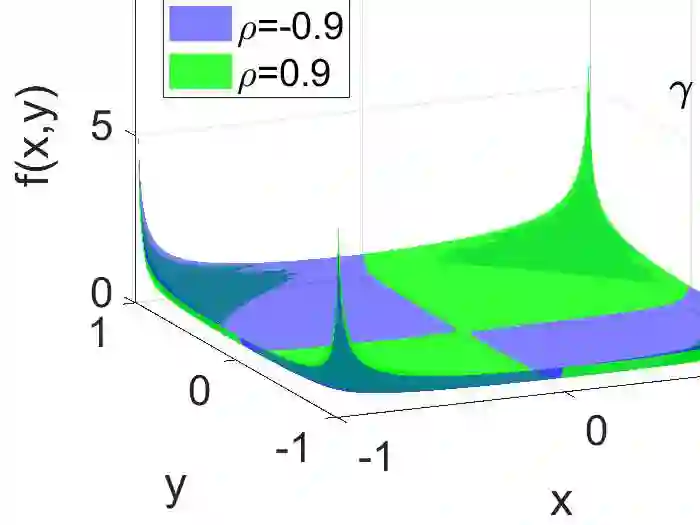

The method of random projection (RP) is the standard technique in machine learning and many other areas, for dimensionality reduction, approximate near neighbor search, compressed sensing, etc. Basically, RP provides a simple and effective scheme for approximating pairwise inner products and Euclidean distances in massive data. Closely related to RP, the method of random Fourier features (RFF) has also become popular, for approximating the Gaussian kernel. RFF applies a specific nonlinear transformation on the projected data from random projections. In practice, using the (nonlinear) Gaussian kernel often leads to better performance than the linear kernel (inner product), partly due to the tuning parameter $(\gamma)$ introduced in the Gaussian kernel. Recently, there has been a surge of interest in studying properties of RFF. After random projections, quantization is an important step for efficient data storage, computation, and transmission. Quantization for RP has also been extensive studied in the literature. In this paper, we focus on developing quantization algorithms for RFF. The task is in a sense challenging due to the tuning parameter $\gamma$ in the Gaussian kernel. For example, the quantizer and the quantized data might be tied to each specific tuning parameter $\gamma$. Our contribution begins with an interesting discovery, that the marginal distribution of RFF is actually free of the Gaussian kernel parameter $\gamma$. This small finding significantly simplifies the design of the Lloyd-Max (LM) quantization scheme for RFF in that there would be only one LM quantizer for RFF (regardless of $\gamma$). We also develop a variant named LM$^2$-RFF quantizer, which in certain cases is more accurate. Experiments confirm that the proposed quantization schemes perform well.

翻译:随机投影法( RP) 是机器学习和许多其他领域的标准技术, 用于降低维度, 近邻搜索, 压缩感测等。 基本上, RP 提供了一种简单而有效的方案, 用于近似双向内部产品和大数据中的 Euclidean 距离。 与 RP 密切相关, 随机 Fourier 特性的方法( RF) 也变得很受欢迎, 用于接近高斯内核。 RFF 的配置是随机预测后, 将随机预测数据进行特定的非线性转换。 在实践中, 使用( 非线性) 高斯内核内核内核, 通常会比线性内核( 内核产品) 产生更好的效果。 部分由于在高斯内核内核调参数 $( gammam), RFF 的调法内核内核磁内核磁M 。 在文献中, 数字内, 数字内核磁内, 数字内核磁内, 数字内, 数字内核磁内, 将发展一个数字内, 。