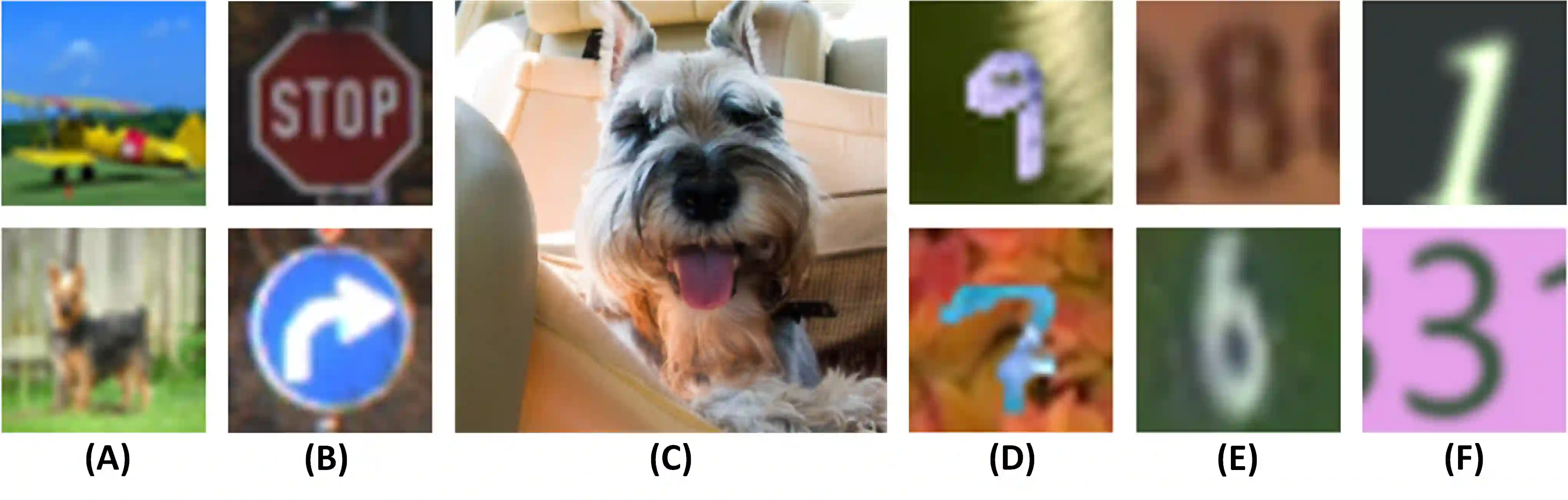

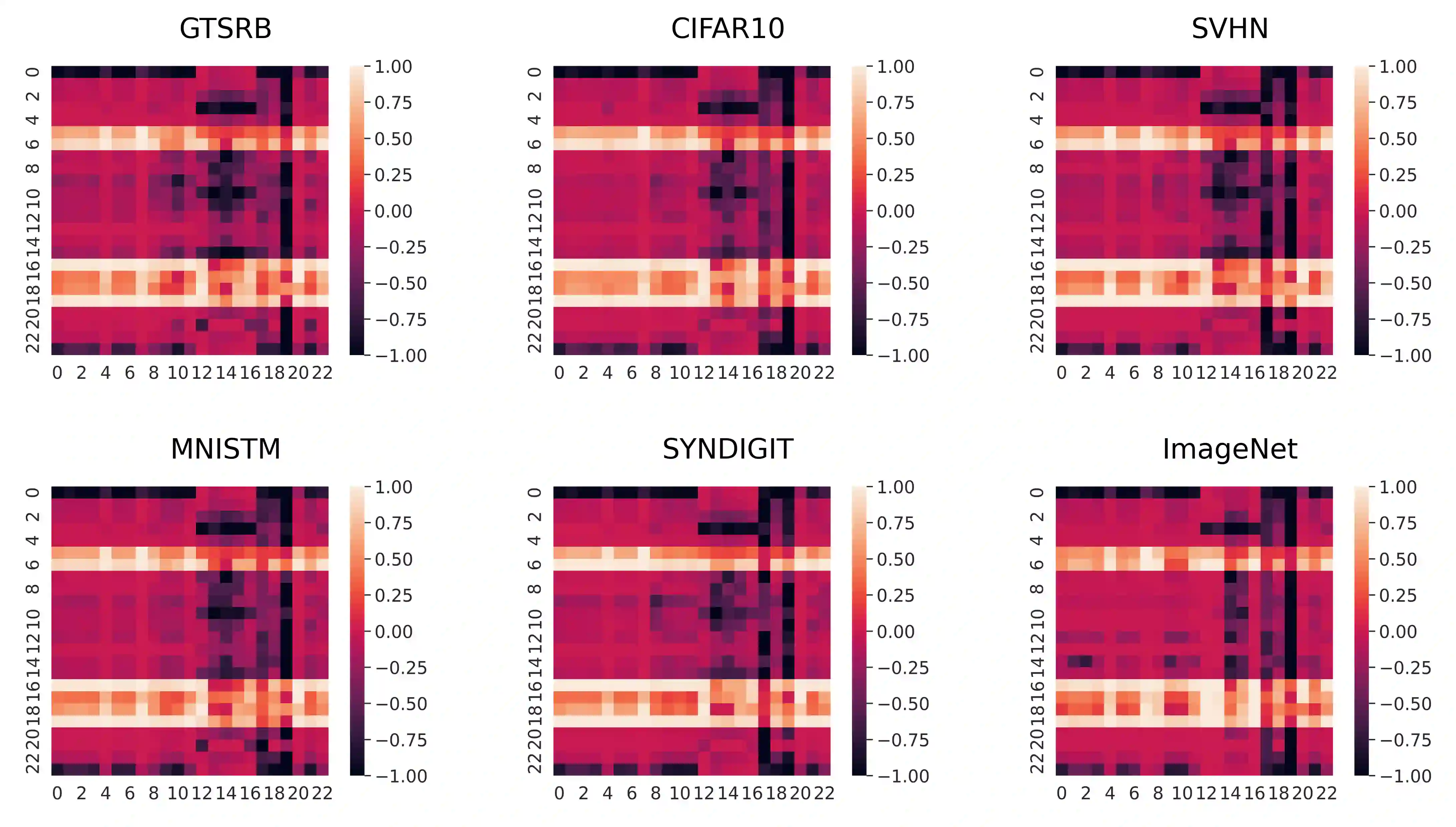

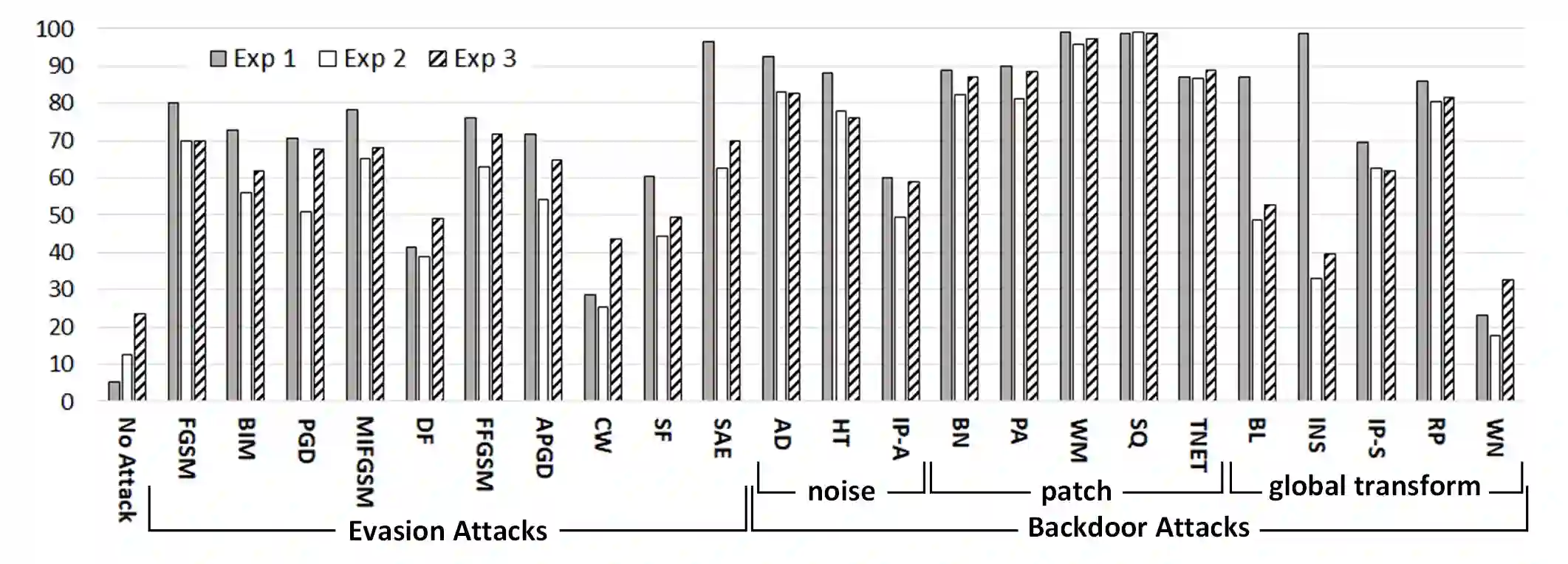

With the growing popularity of artificial intelligence and machine learning, a wide spectrum of attacks against deep learning models have been proposed in the literature. Both the evasion attacks and the poisoning attacks attempt to utilize adversarially altered samples to fool the victim model to misclassify the adversarial sample. While such attacks claim to be or are expected to be stealthy, i.e., imperceptible to human eyes, such claims are rarely evaluated. In this paper, we present the first large-scale study on the stealthiness of adversarial samples used in the attacks against deep learning. We have implemented 20 representative adversarial ML attacks on six popular benchmarking datasets. We evaluate the stealthiness of the attack samples using two complementary approaches: (1) a numerical study that adopts 24 metrics for image similarity or quality assessment; and (2) a user study of 3 sets of questionnaires that has collected 20,000+ annotations from 1,000+ responses. Our results show that the majority of the existing attacks introduce nonnegligible perturbations that are not stealthy to human eyes. We further analyze the factors that contribute to attack stealthiness. We further examine the correlation between the numerical analysis and the user studies, and demonstrate that some image quality metrics may provide useful guidance in attack designs, while there is still a significant gap between assessed image quality and visual stealthiness of attacks.

翻译:由于人工智能和机器学习越来越受欢迎,文献中提出了对深层次学习模式的广泛攻击。逃避攻击和中毒攻击都试图利用对抗性改变的样本来欺骗受害者模式,错误地分类对抗性抽样。虽然这类攻击声称是隐形的,或预期是隐形的,即人类无法察觉的,但这种指控很少得到评估。在本文中,我们介绍了关于攻击深层次学习时使用的对抗性样本的隐形性的首次大规模研究。我们在6个流行基准数据集中实施了20次有代表性的对抗性ML攻击。我们用两种互补方法评估攻击样品的隐形性:(1) 数字研究,采用24个标准来进行图像相似性或质量评估;(2) 用户研究3套调查表,从1 000+的答复中收集了20 000+的注释。我们的研究结果显示,大多数现有攻击都引入了非隐形的侵扰动性。我们进一步分析了有助于攻击隐形的一些因素。我们进一步审查了攻击样品的隐形性,在数字性分析和图像设计中进行重大的图像评估时,可能提供重要的图像质量分析,并表明数字质量设计之间的重大质量分析。