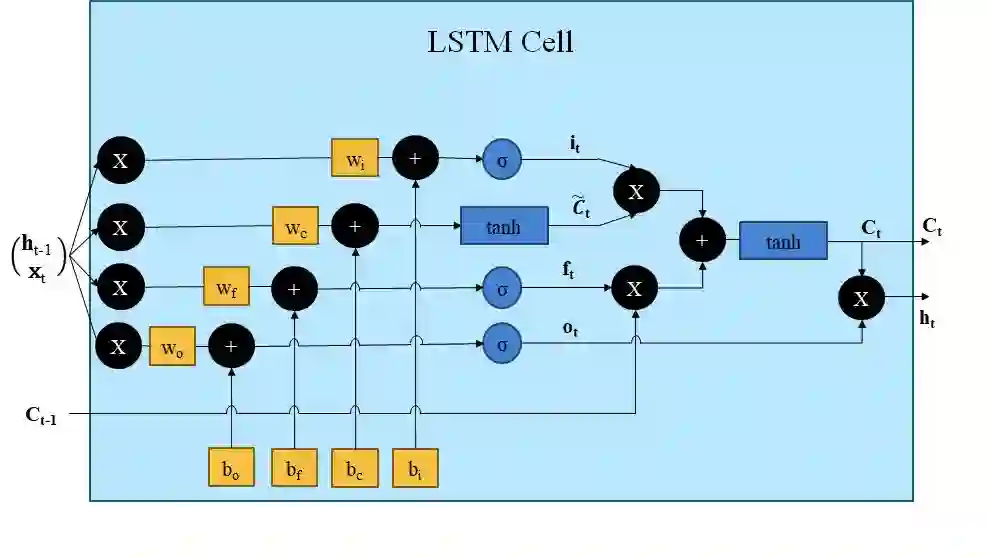

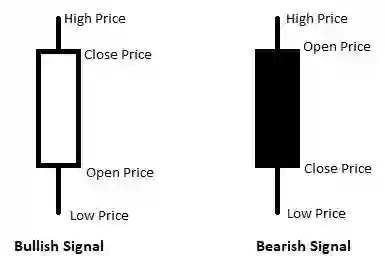

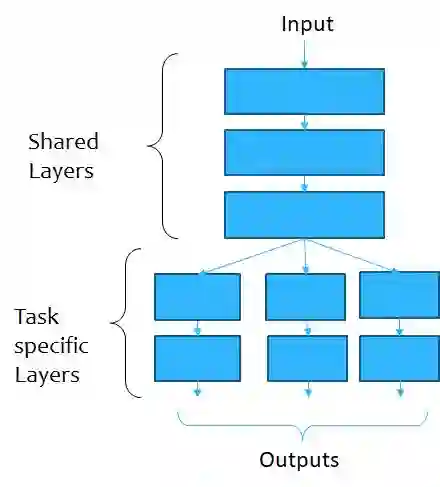

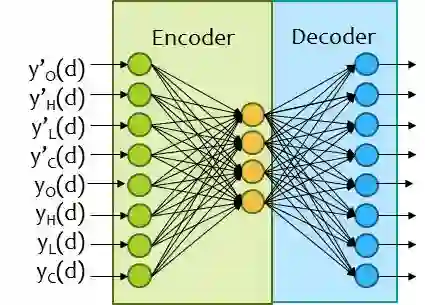

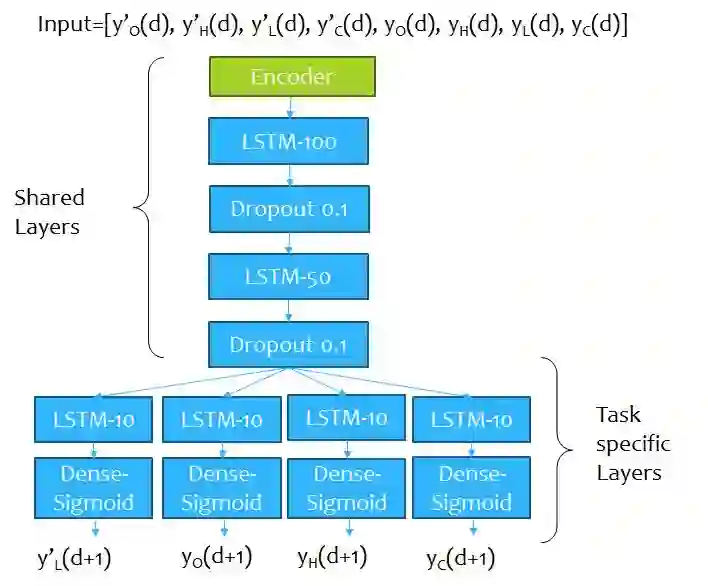

Stock prices are highly volatile and sudden changes in trends are often very problematic for traditional forecasting models to handle. The standard Long Short Term Memory (LSTM) networks are regarded as the state-of-the-art models for such predictions. But, these models fail to handle sudden and drastic changes in the price trend. Moreover, there are some inherent constraints with the open, high, low and close (OHLC) prices of the stocks. Literature lacks the study on the inherent property of OHLC prices. We argue that predicting the OHLC prices for the next day is much more informative than predicting the trends of the stocks as the trend is mostly calculated using these OHLC prices only. The problem mainly is focused on Buy-Today Sell-Tomorrow (BTST) trading. In this regard, AEs when pre-trained with the stock prices, may be beneficial. A novel framework is proposed where a pre-trained encoder is cascaded in front of the multi-task predictor network. This hybrid network can leverage the power of a combination of networks and can both handle the OHLC constraints as well as capture any sudden drastic changes in the prices. It is seen that such a network is much more efficient at predicting stock prices. The experiments have been extended to recommend the most profitable and most overbought stocks on the next day. The model has been tested for multiple Indian companies and it is found that the recommendations from the proposed model have not resulted in a single loss for a test period of 300 days.

翻译:股票价格波动很大,趋势突变往往对传统预测模型造成非常大的问题。标准的长期短期内存(LSTM)网络被视为这类预测的最先进的模型。但是,这些模型未能处理价格趋势的突然和急剧变化。此外,股票公开、高、低和接近(OHLC)价格存在一些内在限制。文学缺乏对OHLC价格固有特性的研究。我们认为,对第二天OHLC价格的预测远比预测储存趋势趋势的预测要丰富得多,因为趋势大多使用OHLC价格计算。问题主要集中于买通即时的卖通货交易(BTST)交易。在这方面,预先接受股票价格培训的AE可能是有益的。提议了一个新框架,在多任务模型预测网络之前,预先训练的encoder会升级。这个混合网络能够利用网络的组合的力量,处理OHLC的制约,以及获取任何突然急剧的检验价格变化,而不是未来多少次的检验期。一个预测期是,一个预测期是预测期的。一个预测期是,一个预测期的,是,一个预测期是,一个比未来更多的试验期的,是预测期的。一个测试期是,一个测试期的。一个超过一天的,是,一个测试期的。一个测试期的,是的,是,一个预测期的,是预测期的。一个周期的,是,在数期的。一个周期的,是,是,是,在数期的,是,在数的。在数的,是,在数的。在数到的。在数的,是,是,是,在数到的。在数的。在数到的。在数的,在数到的,在数到的,是,是,在数到算。