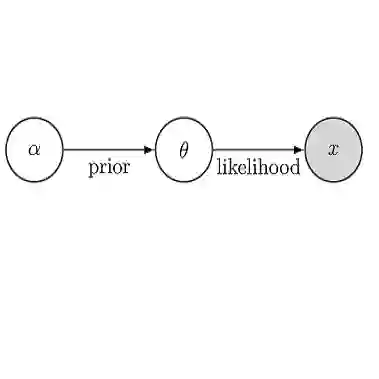

The computational cost of usual Monte Carlo methods for sampling a posteriori laws in Bayesian inference scales linearly with the number of data points. One option to reduce it to a fraction of this cost is to resort to mini-batching in conjunction with unadjusted discretizations of Langevin dynamics, in which case only a random fraction of the data is used to estimate the gradient. However, this leads to an additional noise in the dynamics and hence a bias on the invariant measure which is sampled by the Markov chain. We advocate using the so-called Adaptive Langevin dynamics, which is a modification of standard inertial Langevin dynamics with a dynamical friction which automatically corrects for the increased noise arising from mini-batching. We investigate the practical relevance of the assumptions underpinning Adaptive Langevin (constant covariance for the estimation of the gradient), which are not satisfied in typical models of Bayesian inference, and quantify the bias induced by minibatching in this case. We also show how to extend AdL in order to systematically reduce the bias on the posterior distribution by considering a dynamical friction depending on the current value of the parameter to sample.

翻译:在Bayesian 线性测算尺度中,通常的Monte Carlo 方法在Bayesian 线性测算尺度中,用数据点数线性测算后继法样本的计算成本。将其降低到这一成本的一个选择是,在Langevin动态的未经调整的离散作用中,采用微型吸附法,在这种情况下,只使用数据随机的一小部分来估计梯度。然而,这导致动态增加噪音,从而在由Markov 链抽样的惯性测量上产生偏差。我们主张使用所谓的适应性兰格文动态,即改变标准的惯性兰格文动态动态,以动态摩擦方式自动纠正因微型吸附而增加的噪音。我们调查了适应性兰格文(对梯度估计的一致共差)所依据的假设的实际相关性,这些假设在Bayesian 推算的典型模型中并不令人满意,并量化本案中微型测算引起的偏差。我们还主张如何扩大AdL,以便系统地减少对海床分配的偏差,为此考虑动态摩度的参数,从而根据当前值的参数,将动态摩测算,从而将Sandalmelmexmexmexmission 。