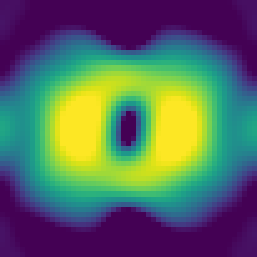

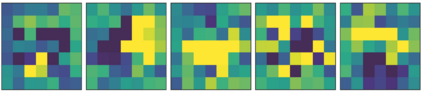

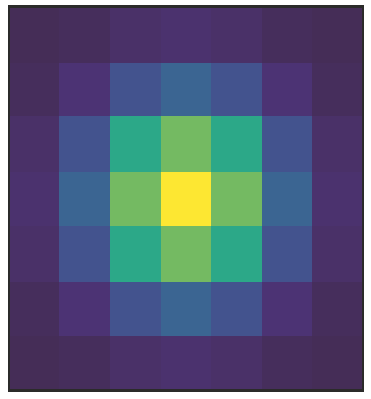

Convolutional layers in CNNs implement linear filters which decompose the input into different frequency bands. However, most modern architectures neglect standard principles of filter design when optimizing their model choices regarding the size and shape of the convolutional kernel. In this work, we consider the well-known problem of spectral leakage caused by windowing artifacts in filtering operations in the context of CNNs. We show that the small size of CNN kernels make them susceptible to spectral leakage, which may induce performance-degrading artifacts. To address this issue, we propose the use of larger kernel sizes along with the Hamming window function to alleviate leakage in CNN architectures. We demonstrate improved classification accuracy over baselines with conventional $3\times 3$ kernels, on multiple benchmark datasets including Fashion-MNIST, CIFAR-10, CIFAR-100 and ImageNet, via the simple use of a standard window function in convolutional layers. Finally, we show that CNNs employing the Hamming window display increased robustness against certain types of adversarial attacks.

翻译:有线电视新闻网的连锁层采用线性过滤器,将输入的内容分解成不同频带。然而,大多数现代建筑在优化关于进动内核大小和形状的模型选择时,忽视了过滤设计的标准原则。在这项工作中,我们考虑到在CNN的过滤操作中,由窗口艺术品造成的众所周知的光谱渗漏问题。我们表明,有线电视新闻网的内核体积小,容易发生光谱渗漏,这可能导致性能降解的文物。为解决这一问题,我们提议使用更大的内核尺寸,同时使用Hamming窗口功能来减轻CNN结构中的渗漏。我们展示了在常规的3-time 3美元内核基线上更高的分类准确度,包括Fashion-MNIST、CIFAR-10、CIFAR-100和图象网,通过在进动层中简单使用标准窗口功能。我们显示,使用Hamming窗口的CNN显示,针对某些类型的对抗性攻击的强度增加了。