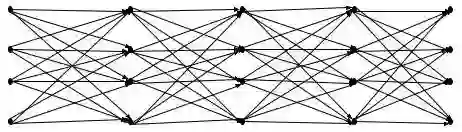

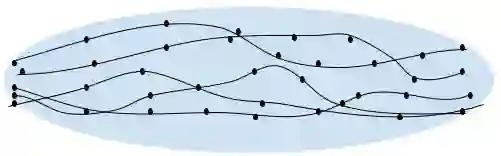

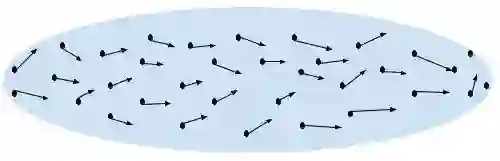

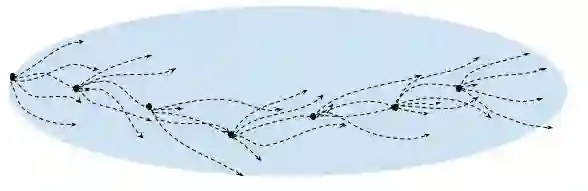

Inverse reinforcement learning (IRL) seeks to infer a cost function that explains the underlying goals and preferences of expert demonstrations. This paper presents receding horizon inverse reinforcement learning (RHIRL), a new IRL algorithm for high-dimensional, noisy, continuous systems with black-box dynamic models. RHIRL addresses two key challenges of IRL: scalability and robustness. To handle high-dimensional continuous systems, RHIRL matches the induced optimal trajectories with expert demonstrations locally in a receding horizon manner and 'stitches' together the local solutions to learn the cost; it thereby avoids the 'curse of dimensionality'. This contrasts sharply with earlier algorithms that match with expert demonstrations globally over the entire high-dimensional state space. To be robust against imperfect expert demonstrations and system control noise, RHIRL learns a state-dependent cost function 'disentangled' from system dynamics under mild conditions. Experiments on benchmark tasks show that RHIRL outperforms several leading IRL algorithms in most instances. We also prove that the cumulative error of RHIRL grows linearly with the task duration.

翻译:反向强化学习( IRL) 试图推断出一种成本函数, 解释专家演示的基本目标和偏好。 本文展示了退缩的地平线反向强化学习( RHIRL), 这是一种新的IRL 算法, 用于使用黑盒动态模型的高维、 噪音、 连续系统。 RHIRL 应对IR的两大挑战: 伸缩性和稳健性。 要处理高维连续系统, RHIRL 将引导的最佳轨迹与当地专家演示相匹配, 其方式是递减地平面方式和“ 缝隙 ”, 并结合当地解决方案来了解成本; 这样可以避免“ 维度的诅咒 ” 。 这与早期的算法截然不同, 与全球高维空间的专家演示相匹配。 要应对不完善的专家演示和系统控制噪音, RHIRL 学习一个基于状态的成本函数在温和条件下“ 分离” 。 基准任务实验显示, RHIRL 在多数情况下, RIRL 超越了几个领先的 IRL 算法。 我们还证明, 直线性错误的累积性与任务持续时间长。