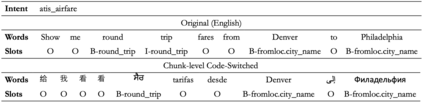

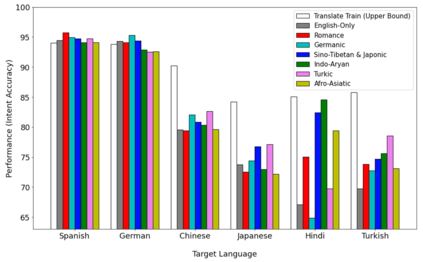

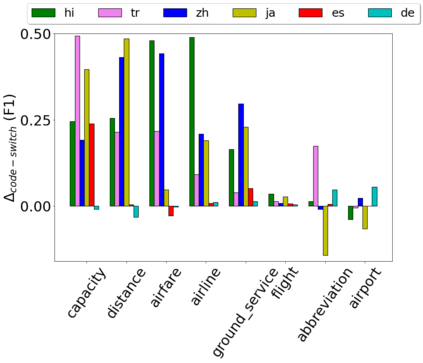

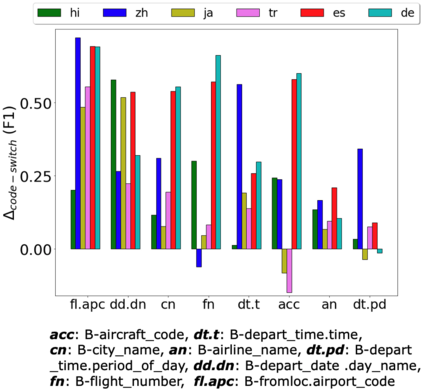

Predicting user intent and detecting the corresponding slots from text are two key problems in Natural Language Understanding (NLU). In the context of zero-shot learning, this task is typically approached by either using representations from pre-trained multilingual transformers such as mBERT, or by machine translating the source data into the known target language and then fine-tuning. Our work focuses on a particular scenario where the target language is unknown during training. To this goal, we propose a novel method to augment the monolingual source data using multilingual code-switching via random translations to enhance a transformer's language neutrality when fine-tuning it for a downstream task. This method also helps discover novel insights on how code-switching with different language families around the world impact the performance on the target language. Experiments on the benchmark dataset of MultiATIS++ yielded an average improvement of +4.2% in accuracy for intent task and +1.8% in F1 for slot task using our method over the state-of-the-art across 8 different languages. Furthermore, we present an application of our method for crisis informatics using a new human-annotated tweet dataset of slot filling in English and Haitian Creole, collected during Haiti earthquake disaster.

翻译:预测用户意图和从文本中探测相应的空格是自然语言理解(NLU)的两个关键问题。在零点学习的背景下,这项任务通常通过使用预先培训的多语言变压器(如 mBERT)的演示,或者机器将源数据转换成已知的目标语言,然后进行微调来完成。我们的工作侧重于在培训期间目标语言未知的特定情景。为此,我们提出了一个新颖的方法,通过随机翻译来增加单语言源数据,使用多种语言代码抽动,在为下游任务微调变压器时,加强变压器的语言中立性。这个方法还有助于发现与世界各地不同语言家庭进行代码转换如何影响目标语言业绩的新洞见。在MultiATIS+++的基准数据集实验中,利用我们对8种不同语言的最新技术,在海地地震中收集的英语和克里奥尔式危机信息,平均提高了4.2%的准确度,在F1中提高了1.8%。