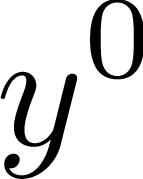

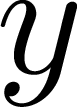

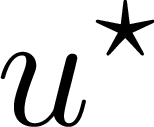

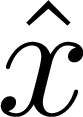

This paper aims to discuss and analyze the potentialities of Recurrent Neural Networks (RNN) in control design applications. The main families of RNN are considered, namely Neural Nonlinear AutoRegressive eXogenous, (NNARX), Echo State Networks (ESN), Long Short Term Memory (LSTM), and Gated Recurrent Units (GRU). The goal is twofold. Firstly, to survey recent results concerning the training of RNN that enjoy Input-to-State Stability (ISS) and Incremental Input-to-State Stability ({\delta}ISS) guarantees. Secondly, to discuss the issues that still hinder the widespread use of RNN for control, namely their robustness, verifiability, and interpretability. The former properties are related to the so-called generalization capabilities of the networks, i.e. their consistency with the underlying real plants, even in presence of unseen or perturbed input trajectories. The latter is instead related to the possibility of providing a clear formal connection between the RNN model and the plant. In this context, we illustrate how ISS and {\delta}ISS represent a significant step towards the robustness and verifiability of the RNN models, while the requirement of interpretability paves the way to the use of physics-based networks. The design of model predictive controllers with RNN as plant's model is also briefly discussed. Lastly, some of the main topics of the paper are illustrated on a simulated chemical system.

翻译:本文的目的是讨论和分析经常性神经网络在控制设计应用方面的潜力; 考虑经常神经网络的主要家庭,即神经非线性自动递减和可解释性(NNARX)、回声国家网络(ESN)、长期短期内存(LSTM)和Gated经常单位(GRU),目的是双重的; 首先,调查最近对享受投入到国家稳定(ISS)和递增输入到国家稳定(xdelta}ISS)保障的网络培训结果; 第二,讨论仍然阻碍广泛使用网络控制的问题,即网络的稳健性、可核查性和可解释性; 前者的特性与网络所谓的全面化能力有关,即它们与基本的实际工厂的一致性,即使存在隐蔽或隐蔽的投入轨迹; 后者与在RNNN模式和基于工厂的快速输入到递增输入到递增到递增的进到国家稳定(xxx)之间提供明确正式联系的可能性有关; 第二,讨论仍然阻碍广泛使用网络控制的问题,即其稳健性、可核查性和可解释性; 前者与所谓SISSISSI和一些模拟文件是朝着稳妥化化系统走向方向的一个重大步骤,同时对NNS的模型加以解释。