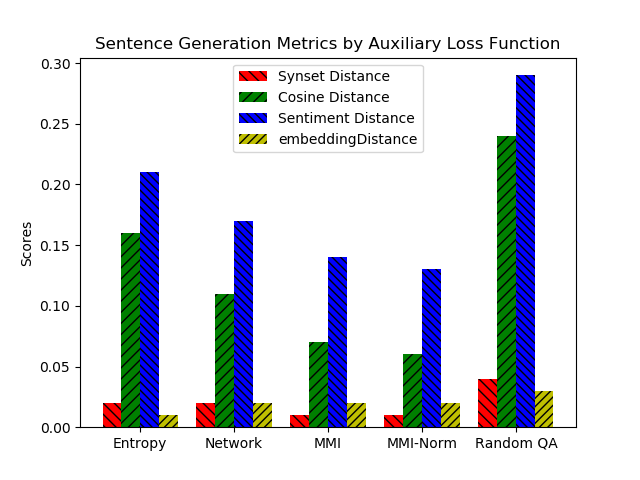

Although people have the ability to engage in vapid dialogue without effort, this may not be a uniquely human trait. Since the 1960's researchers have been trying to create agents that can generate artificial conversation. These programs are commonly known as chatbots. With increasing use of neural networks for dialog generation, some conclude that this goal has been achieved. This research joins the quest by creating a dialog generating Recurrent Neural Network (RNN) and by enhancing the ability of this network with auxiliary loss functions and a beam search. Our custom loss functions achieve better cohesion and coherence by including calculations of Maximum Mutual Information (MMI) and entropy. We demonstrate the effectiveness of this system by using a set of custom evaluation metrics inspired by an abundance of previous research and based on tried-and-true principles of Natural Language Processing.

翻译:虽然人们有能力不费吹灰之力地参与无所事事的对话,但这可能不是一个独特的人性特征。 自1960年代以来,研究人员一直在努力创建能产生人为对话的代理商。这些程序通常被称为聊天机。随着越来越多的使用神经网络来生成对话,一些人得出结论,这一目标已经实现。通过创建产生经常性神经网络(NNN)的对话,通过增强这个网络的辅助损失功能和波束搜索能力,这一研究加入了这一追求。我们的习惯损失功能通过计算最大相互信息(MMI)和英特罗佩(entropy),实现了更好的凝聚力和一致性。我们通过使用一套基于大量先前研究的、以经过考验的自然语言处理原则为基础的定制评估指标,证明了这个系统的有效性。