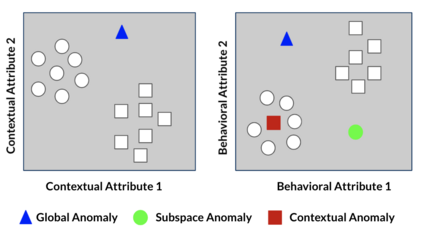

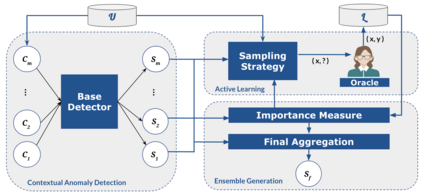

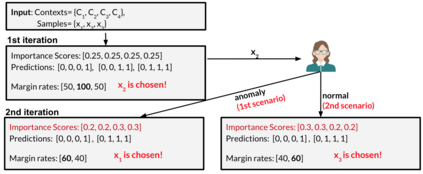

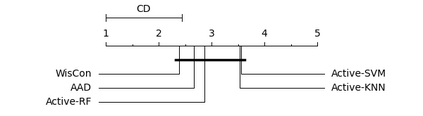

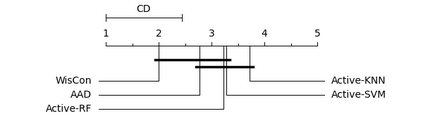

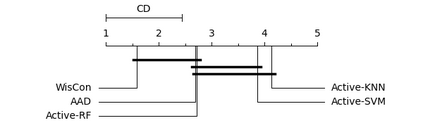

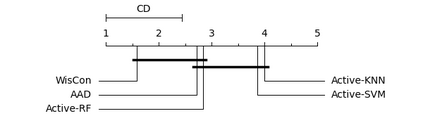

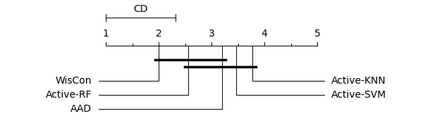

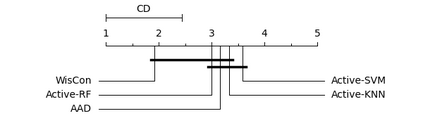

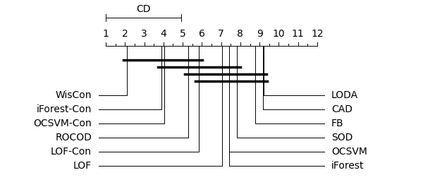

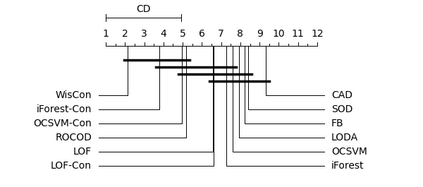

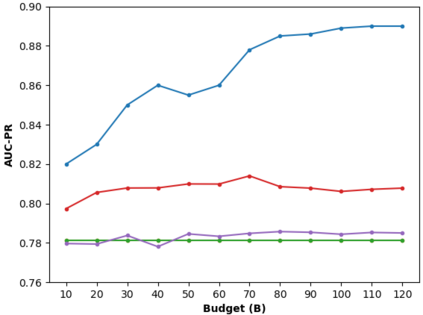

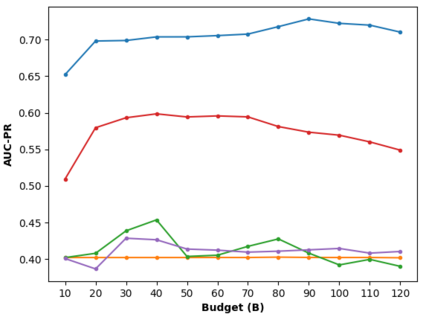

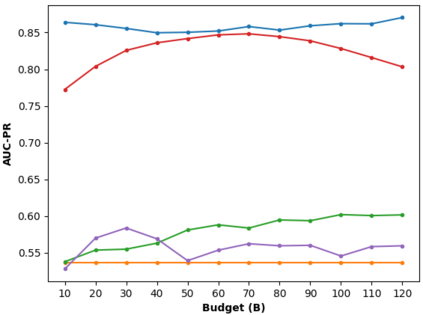

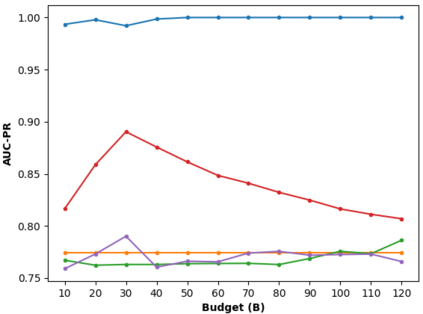

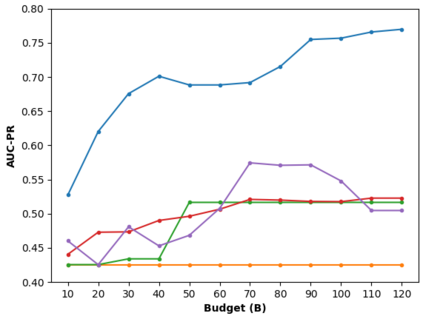

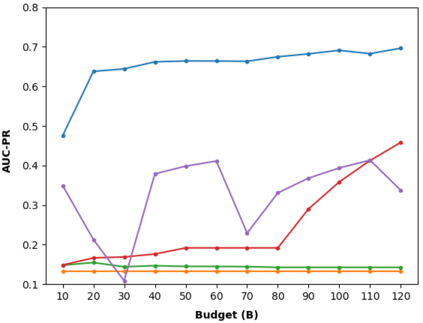

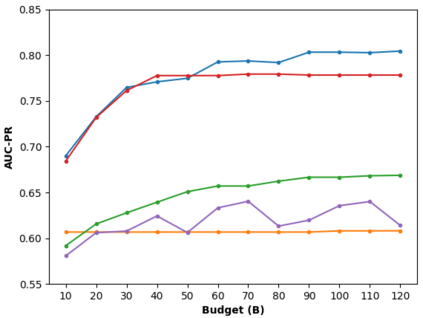

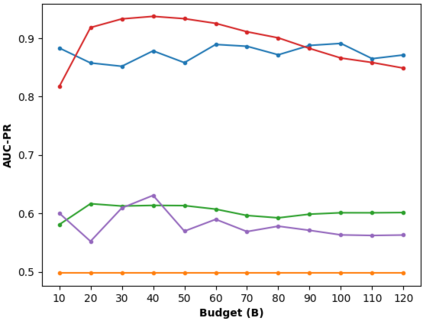

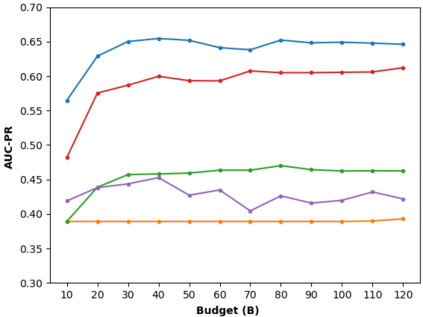

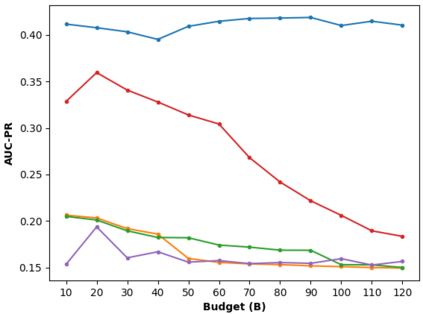

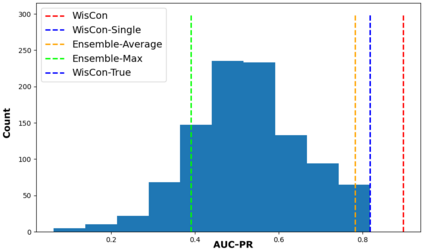

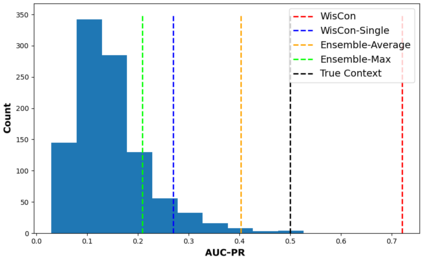

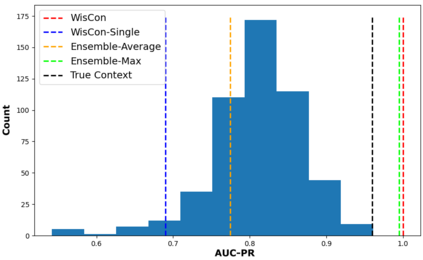

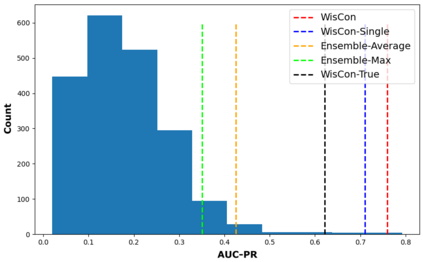

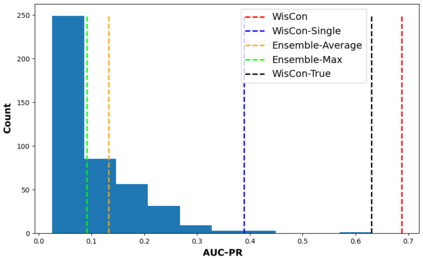

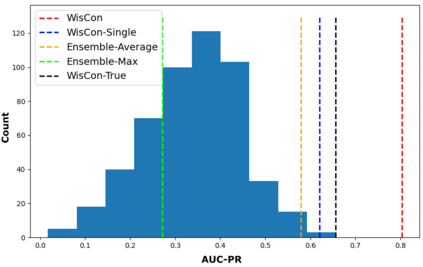

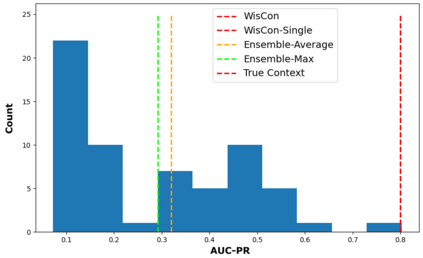

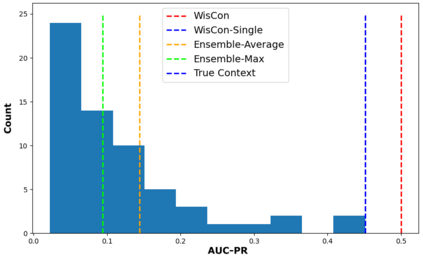

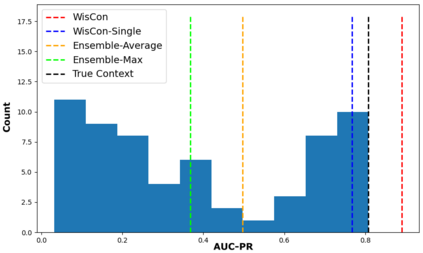

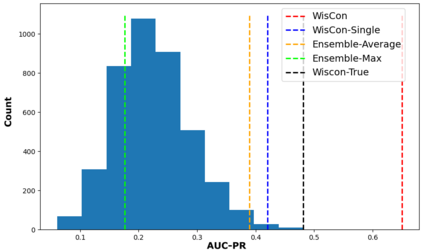

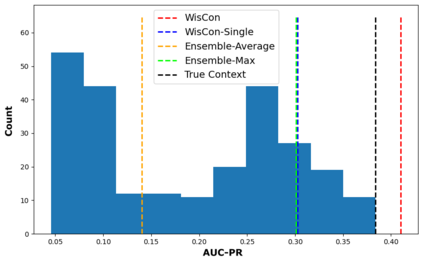

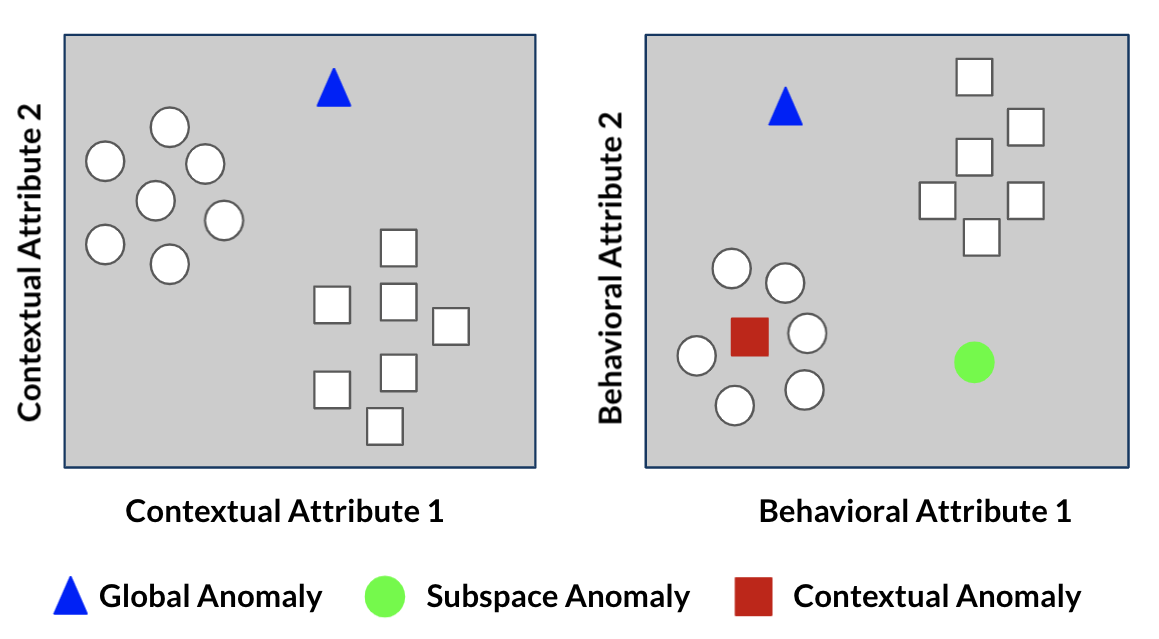

In contextual anomaly detection, an object is only considered anomalous within a specific context. Most existing methods for CAD use a single context based on a set of user-specified contextual features. However, identifying the right context can be very challenging in practice, especially in datasets, with a large number of attributes. Furthermore, in real-world systems, there might be multiple anomalies that occur in different contexts and, therefore, require a combination of several "useful" contexts to unveil them. In this work, we leverage active learning and ensembles to effectively detect complex contextual anomalies in situations where the true contextual and behavioral attributes are unknown. We propose a novel approach, called WisCon (Wisdom of the Contexts), that automatically creates contexts from the feature set. Our method constructs an ensemble of multiple contexts, with varying importance scores, based on the assumption that not all useful contexts are equally so. Experiments show that WisCon significantly outperforms existing baselines in different categories (i.e., active classifiers, unsupervised contextual and non-contextual anomaly detectors, and supervised classifiers) on seven datasets. Furthermore, the results support our initial hypothesis that there is no single perfect context that successfully uncovers all kinds of contextual anomalies, and leveraging the "wisdom" of multiple contexts is necessary.

翻译:在背景异常检测中,对象仅在特定背景下被视为异常。 大多数 CAD 现有方法都使用基于一组用户指定背景特征的单一背景。 然而, 确定正确背景在实践中可能非常具有挑战性, 特别是在数据集中, 具有大量属性。 此外, 在现实世界系统中, 在不同背景下可能出现多种异常, 因此, 需要结合几种“ 有用” 环境来揭发这些异常。 在这项工作中, 我们利用积极学习和集合来有效检测在真实背景和行为属性未知的情况下复杂的背景异常。 我们建议了一种新颖的方法, 叫做 WisCon( 环境环境环境与环境), 从而自动地从功能集中创建环境。 我们的方法根据并非所有有用环境都具有同等价值的假设, 构建了多种环境的组合。 实验显示WisCon 大大超越了不同类别( 即主动分类器、 未经超超超背景背景背景和非背景异常异常特征检测器), 监督的分类师提出了一种新颖的方法, 自动地从功能组创建环境中创建环境。 此外, 我们的多重背景环境环境背景背景环境都无法成功揭示。