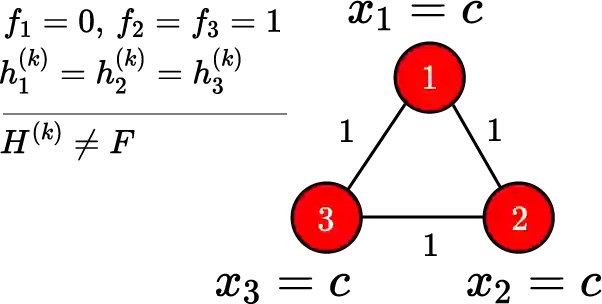

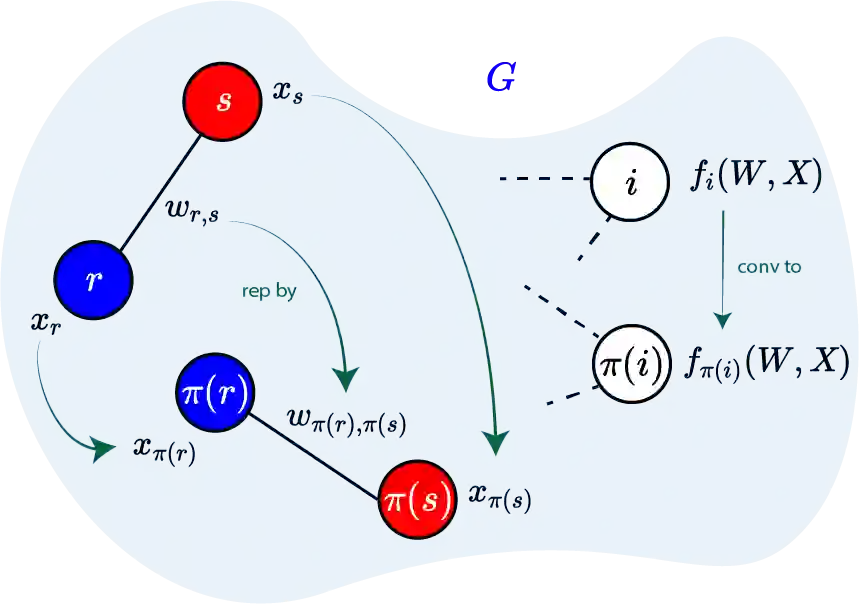

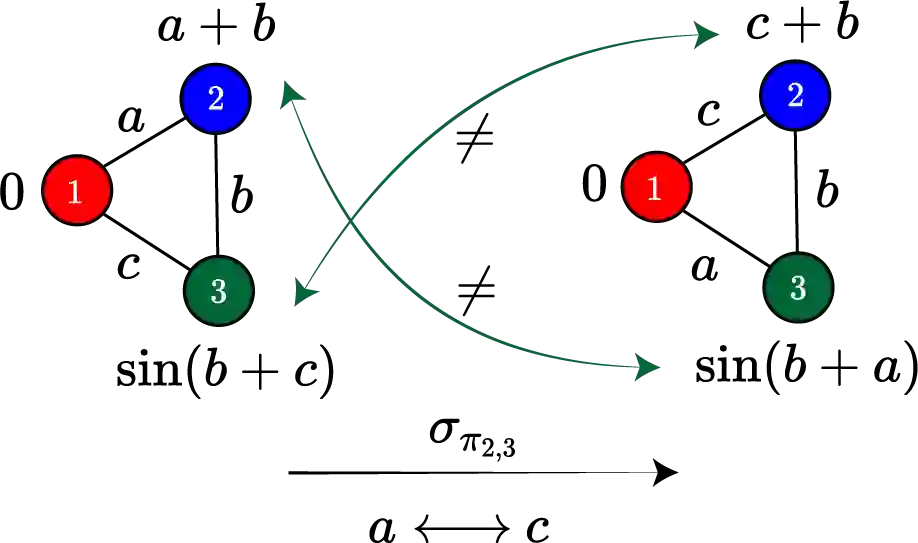

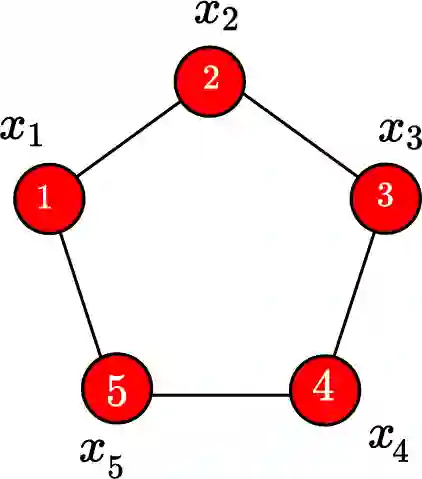

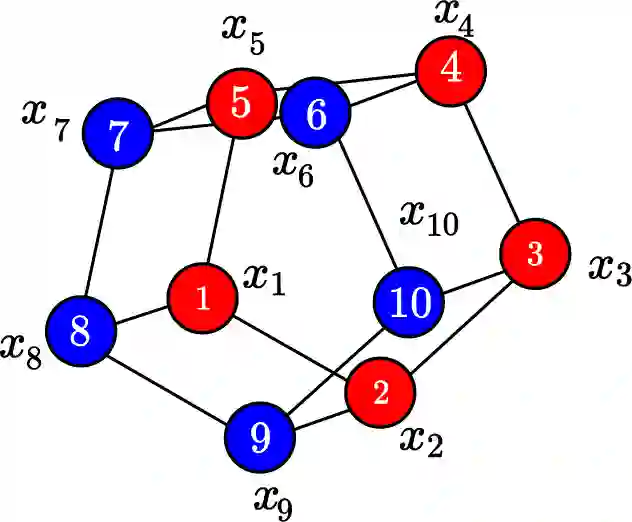

Given a graph function, defined on an arbitrary set of edge weights and node features, does there exist a Graph Neural Network (GNN) whose output is identical to the graph function? In this paper, we fully answer this question and characterize the class of graph problems that can be represented by GNNs. We identify an algebraic condition, in terms of the permutation of edge weights and node features, which proves to be necessary and sufficient for a graph problem to lie within the reach of GNNs. Moreover, we show that this condition can be efficiently verified by checking quadratically many constraints. Note that our refined characterization on the expressive power of GNNs are orthogonal to those theoretical results showing equivalence between GNNs and Weisfeiler-Lehman graph isomorphism heuristic. For instance, our characterization implies that many natural graph problems, such as min-cut value, max-flow value, and max-clique size, can be represented by a GNN. In contrast, and rather surprisingly, there exist very simple graphs for which no GNN can correctly find the length of the shortest paths between all nodes. Note that finding shortest paths is one of the most classical problems in Dynamic Programming (DP). Thus, the aforementioned negative example highlights the misalignment between DP and GNN, even though (conceptually) they follow very similar iterative procedures. Finally, we support our theoretical results by experimental simulations.

翻译:根据一组任意的边缘权重和节点特性定义的图形函数,是否存在一个图形神经网络(GNNN),其输出与图形函数完全相同?在本文中,我们充分回答这一问题,并描述GNNS能够代表的图形问题类别。我们从边权重和节点特征的排列上确定一个代数条件,这证明是必要的,足以使图形问题处于GNNS的范围之内。此外,我们还表明,通过检查许多限制,可以有效地验证这一条件。注意到,我们对GNNS的表达力的精细描述与显示GNNS和Weisfeiler-Lehman图形具有等同性的理论结果不完全一致。例如,我们的特征特征特征表明,许多自然的图形问题,如微分值、最大流值和最大分级大小,都可以由GNNU来代表。相比之下,相当奇怪的是,甚至有非常简单的图表,甚至没有GNNNNP在最短的实验路径上找到最短的GNND,但最短的MRD 。注意,最后在最短的MDDRDRD 中找到最短的路径。