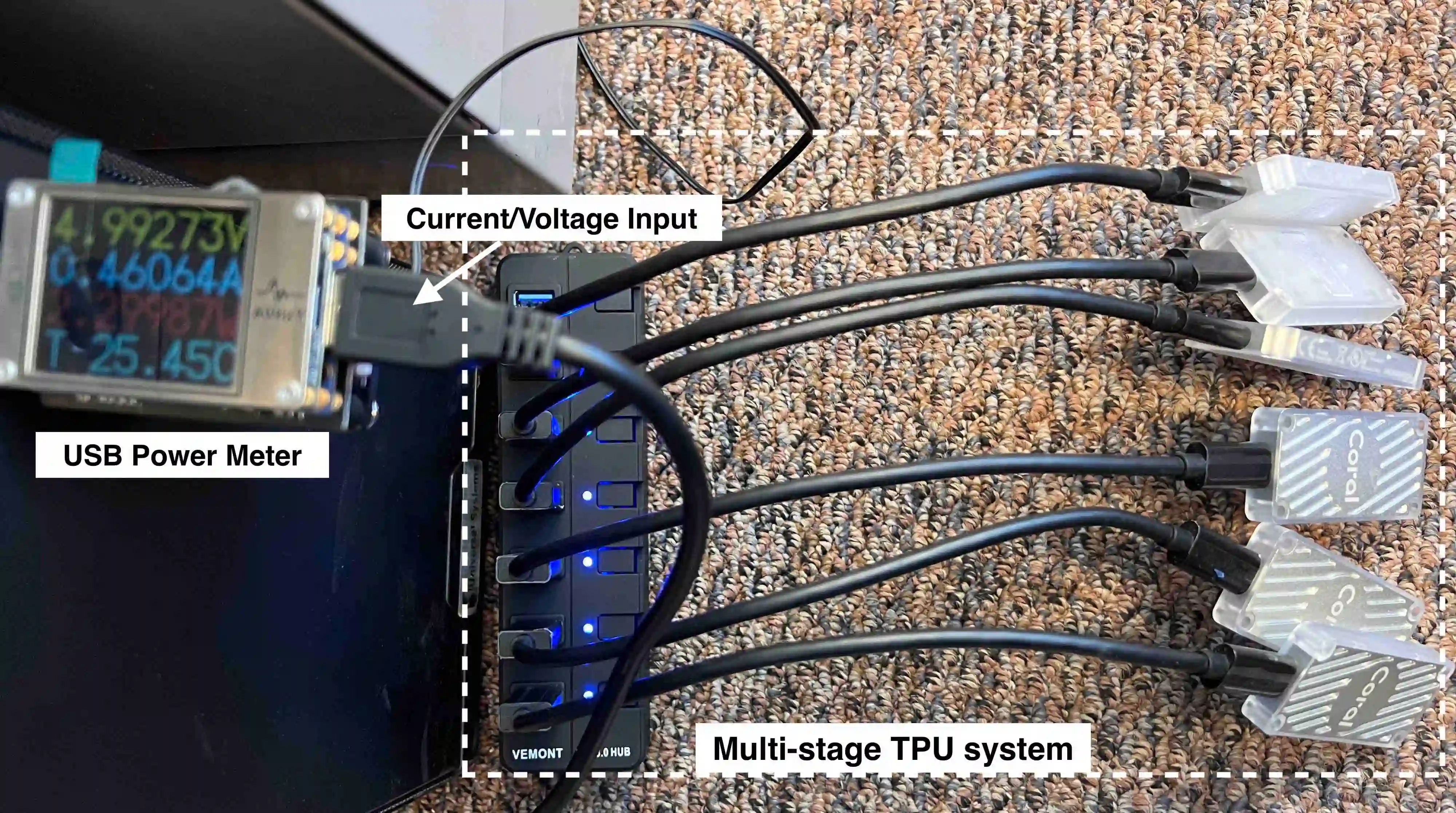

Deep neural networks (DNNs) have substantial computational and memory requirements, and the compilation of its computational graphs has a great impact on the performance of resource-constrained (e.g., computation, I/O, and memory-bound) edge computing systems. While efficient execution of their computational graph requires an effective scheduling algorithm, generating the optimal scheduling solution is a challenging NP-hard problem. Furthermore, the complexity of scheduling DNN computational graphs will further increase on pipelined multi-core systems considering memory communication cost, as well as the increasing size of DNNs. Using the synthetic graph for the training dataset, this work presents a reinforcement learning (RL) based scheduling framework RESPECT, which learns the behaviors of optimal optimization algorithms and generates near-optimal scheduling results with short solving runtime overhead. Our framework has demonstrated up to $\sim2.5\times$ real-world on-chip inference runtime speedups over the commercial compiler with ten popular ImageNet models deployed on the physical Coral Edge TPUs system. Moreover, compared to the exact optimization methods, the proposed RL scheduling improves the scheduling optimization runtime by up to 683$\times$ speedups compared to the commercial compiler and matches the exact optimal solutions with up to 930$\times$ speedups. Finally, we perform a comprehensive generalizability test, which demonstrates RESPECT successfully imitates optimal solving behaviors from small synthetic graphs to large real-world DNNs computational graphs.

翻译:深度神经网络(DNNs)具有巨大的计算和内存需求,其计算图的编译对资源受限的边缘计算系统的性能产生重大影响(例如计算、I/O和内存)。虽然有效执行其计算图需要一种有效的调度算法,但生成最佳调度解决方案是具有挑战性的NP-hard问题。此外,考虑内存通信成本以及DNN的不断增长的大小,在流水线多核系统上调度DNN计算图的复杂性将进一步增加。本文提出一种基于RL(强化学习)的调度框架RESPECT,使用训练数据集的合成图,学习最优化算法的行为,并生成近乎最优的调度结果,具有较短的求解运行时开销。我们的框架展示出与商业编译器相比高达$~2.5\times$ 的实际芯片推理运行时加速效果,使用10种常见的ImageNet模型部署在Coral Edge TPUs实际系统上。此外,与精确优化方法相比,所提出的RL调度将调度优化运行时提高了高达683倍的速度,比商业编译器匹配的精确最优解提高了高达930倍的速度。最后,我们进行了全面的通用性测试,展示RESPECT成功地将从小的合成图到大的实际DNN计算图的最优求解行