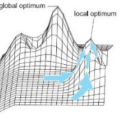

In recent work, Lissovoi, Oliveto, and Warwicker (Artificial Intelligence (2023)) proved that the Move Acceptance Hyper-Heuristic (MAHH) leaves the local optimum of the multimodal cliff benchmark with remarkable efficiency. With its $O(n^3)$ runtime, for almost all cliff widths $d,$ the MAHH massively outperforms the $\Theta(n^d)$ runtime of simple elitist evolutionary algorithms (EAs). For the most prominent multimodal benchmark, the jump functions, the given runtime estimates of $O(n^{2m} m^{-\Theta(m)})$ and $\Omega(2^{\Omega(m)})$, for gap size $m \ge 2$, are far apart and the real performance of MAHH is still an open question. In this work, we resolve this question. We prove that for any choice of the MAHH selection parameter~$p$, the expected runtime of the MAHH on a jump function with gap size $m = o(n^{1/2})$ is at least $\Omega(n^{2m-1} / (2m-1)!)$. This renders the MAHH much slower than simple elitist evolutionary algorithms with their typical $O(n^m)$ runtime. We also show that the MAHH with the global bit-wise mutation operator instead of the local one-bit operator optimizes jump functions in time $O(\min\{m n^m,\frac{n^{2m-1}}{m!\Omega(m)^{m-2}}\})$, essentially the minimum of the optimization times of the $(1+1)$ EA and the MAHH. This suggests that combining several ways to cope with local optima can be a fruitful approach.

翻译:在最近的研究中,Lissovoi、Oliveto和Warwicker(人工智能(2023))证明了移动接受超级启发式算法(MAHH)在多峰悬崖基准测试的局部最优点上表现出卓越的效率。随着其$O(n^3)$的运行时间,对于几乎所有的悬崖宽度$d$,MAHH大大优于简单的精英进化算法(EAs)的$\Theta(n^d)$运行时间。对于最突出的多峰基准测试——跳跃函数,给定的运行时间估计为$O(n^{2m} m^{-\Theta(m)})$和$\Omega(2^{\Omega(m)})$,对于间隙大小$m\ge 2$,两者差距很大,MAHH的实际表现仍是一个未解决的问题。在这项工作中,我们解决了这个问题。我们证明了对于MAHH选择参数$p$的任何选择,跳跃函数与间隙大小$m = o(n^{1/2})$的MAHH的预期运行时间至少为$\Omega(n^{2m-1}/(2m-1)!)$。这使得MAHH比简单的精英进化算法在典型的$O(n^m)$运行时间方面要慢得多。我们还展示了使用全局位运算突变算子而非局部一位算子的MAHH可以在时间$O(\min\{mn^m,\frac{n^{2m-1}}{m!\Omega(m)^{m-2}}\})$中优化跳跃函数,这本质上是$(1+1)$EA和MAHH的最小优化时间的最小值。这表明,结合几种应对局部最优点的方法可能是一种富有成效的方法。