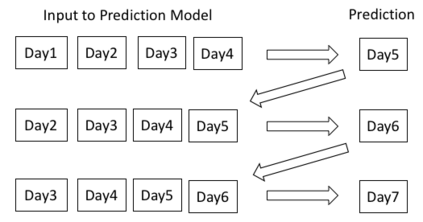

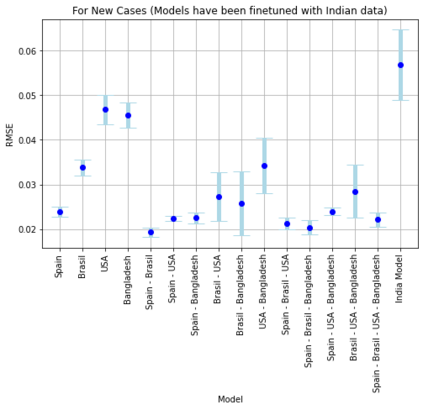

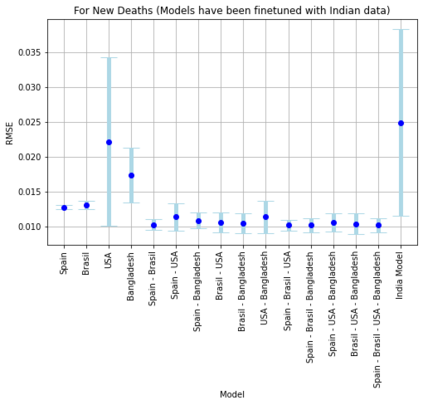

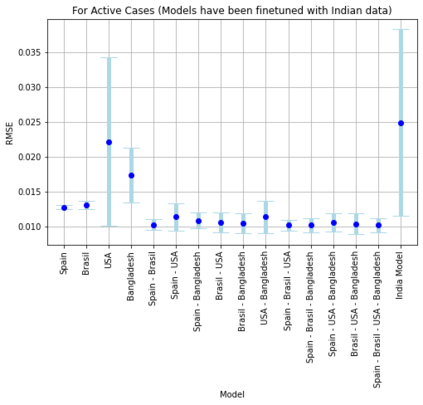

The current COVID-19 pandemic has put a huge challenge on the Indian health infrastructure. With more and more people getting affected during the second wave, the hospitals were over-burdened, running out of supplies and oxygen. In this scenario, prediction of the number of COVID-19 cases beforehand might have helped in the better utilization of limited resources and supplies. This manuscript deals with the prediction of new COVID-19 cases, new deaths and total active cases for multiple days in advance. The proposed method uses gated recurrent unit networks as the main predicting model. A study is conducted by building four models that are pre-trained on the data from four different countries (United States of America, Brazil, Spain and Bangladesh) and are fine-tuned or retrained on India's data. Since the four countries chosen have experienced different types of infection curves, the pre-training provides a transfer learning to the models incorporating diverse situations into account. Each of the four models then give a multiple days ahead predictions using recursive learning method for the Indian test data. The final prediction comes from an ensemble of the predictions of the combination of different models. This method with two countries, Spain and Brazil, is seen to achieve the best performance amongst all the combinations as well as compared to other traditional regression models.

翻译:目前的COVID-19大流行给印度卫生基础设施带来了巨大的挑战,在第二波期间,越来越多的人受到影响,医院负担过重,供应和氧气耗尽;在这一假设中,预先预测COVID-19病例的数量可能有助于更好地利用有限的资源和用品;这一手稿涉及预测新的COVID-19病例、新的死亡和连续数日的全例病例;拟议方法使用封闭的经常性单位网络作为主要预测模型;研究通过建立四个模型进行,这些模型已经预先培训了四个不同国家(美利坚合众国、巴西、西班牙和孟加拉国)的数据,并经过微调或再培训印度的数据;由于四个选定的国家经历了不同种类的感染曲线,培训前可以将学习转移到将不同情况纳入核算的模型中;四种模型中的每一种都提前数天作出预测,印度测试数据采用循环性学习方法;最后的预测来自四个不同国家(美利坚合众国、巴西、西班牙和孟加拉国)的数据组合的最佳预测,并经过微调或重新培训。这个方法与两个传统的模型相比,西班牙和巴西,其业绩都是由两个传统模型共同实现的。