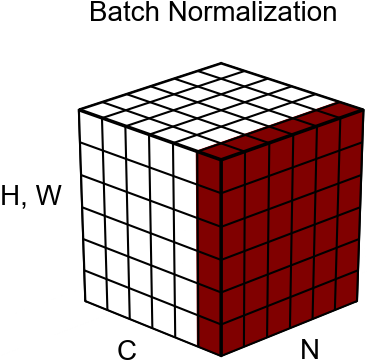

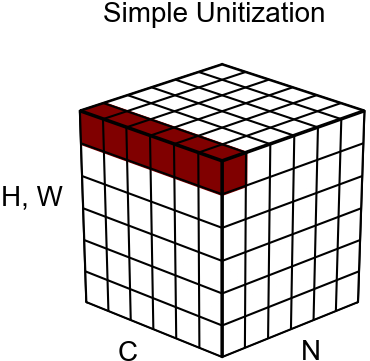

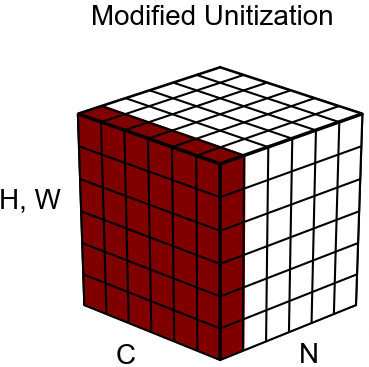

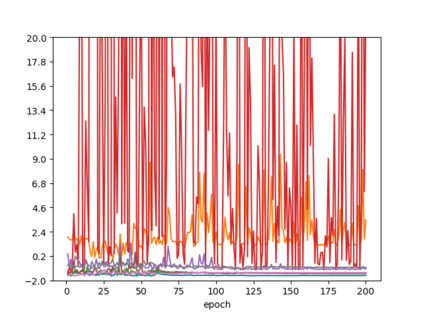

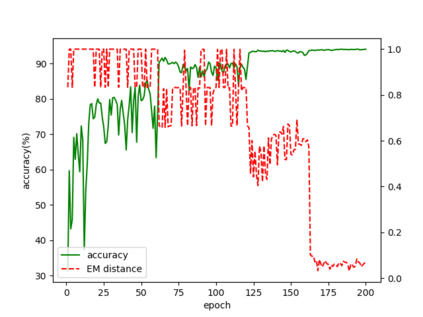

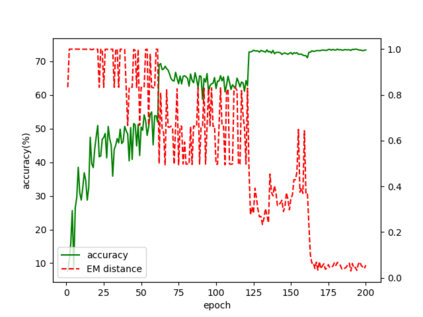

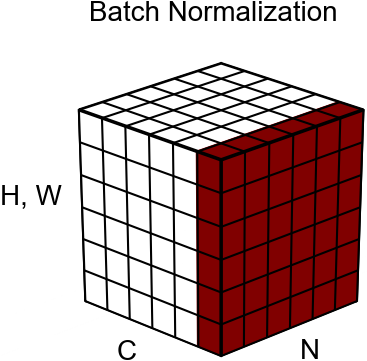

Batch Normalization (BN) techniques have been proposed to reduce the so-called Internal Covariate Shift (ICS) by attempting to keep the distributions of layer outputs unchanged. Experiments have shown their effectiveness on training deep neural networks. However, since only the first two moments are controlled in these BN techniques, it seems that a weak constraint is imposed on layer distributions and furthermore whether such constraint can reduce ICS is unknown. Thus this paper proposes a measure for ICS by using the Earth Mover (EM) distance and then derives the upper and lower bounds for the measure to provide a theoretical analysis of BN. The upper bound has shown that BN techniques can control ICS only for the outputs with low dimensions and small noise whereas their control is NOT effective in other cases. This paper also proves that such control is just a bounding of ICS rather than a reduction of ICS. Meanwhile, the analysis shows that the high-order moments and noise, which BN cannot control, have great impact on the lower bound. Based on such analysis, this paper furthermore proposes an algorithm that unitizes the outputs with an adjustable parameter to further bound ICS in order to cope with the problems of BN. The upper bound for the proposed unitization is noise-free and only dominated by the parameter. Thus, the parameter can be trained to tune the bound and further to control ICS. Besides, the unitization is embedded into the framework of BN to reduce the information loss. The experiments show that this proposed algorithm outperforms existing BN techniques on CIFAR-10, CIFAR-100 and ImageNet datasets.

翻译:批量正常化( BN) 技术被提出来降低所谓的内部网络转换( ICS), 试图保持层输出分布不变。 实验显示, 在培养深神经网络方面, 实验显示了它们的有效性。 但是, 由于这些 BN 技术只控制了前两个时刻, 似乎对层分布施加了较弱的制约, 而且这种制约能否减少ICS 尚不清楚。 因此, 本文为ICS 提出了一个测量尺度, 方法是使用地球移动器( EM) 距离, 并随后为该测量提供对 BN 进行理论分析的上下限。 上限显示, BN 技术只能控制低尺寸和小噪音的输出。 测试显示 BN 技术只控制低尺寸和小噪音, 而它们控制在其它情况下则无效。 本文还证明, 这种控制只是控制ICS 的高度、 和噪音控制下限值框架 。 将输出单位与可调整的内置的ICS 标值比 控制, 只能控制现有的BCS 。 。 控制高序, 将 向上 控制 和 格式 控制 控制 。 。 。 将 控制 控制 控制 控制 控制 。, 控制 控制, 高序 将 CSLBCSD 的 的 控制 控制 以 控制 的 以 以 的 向 向 向 控制 控制 向 向 的 的 的 向 控制 控制 控制 向 向 向 向 的 的 向 向 向 向 向 的 的 向 向 的 向 向 的 的 向 向 向 向 的 的 的 向 向 向 的 的 的 向 的 的 向 向 的 向 向 向 向 向 的 向 向 向 向 向 向 向 向 的 的 的 的 向 向 向 向 的 向 向 向 的 向 向 向 向 向 的 的 向 向 向 向 向 向 向 向 向 向