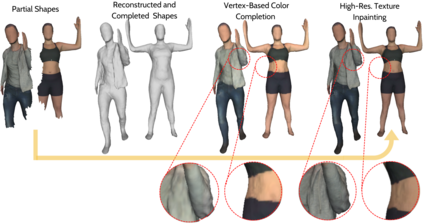

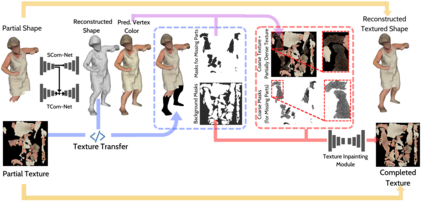

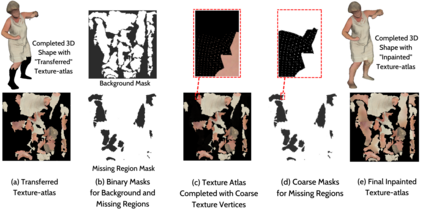

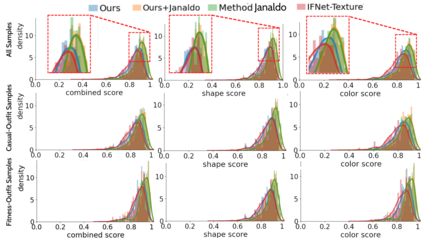

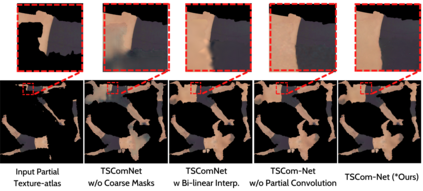

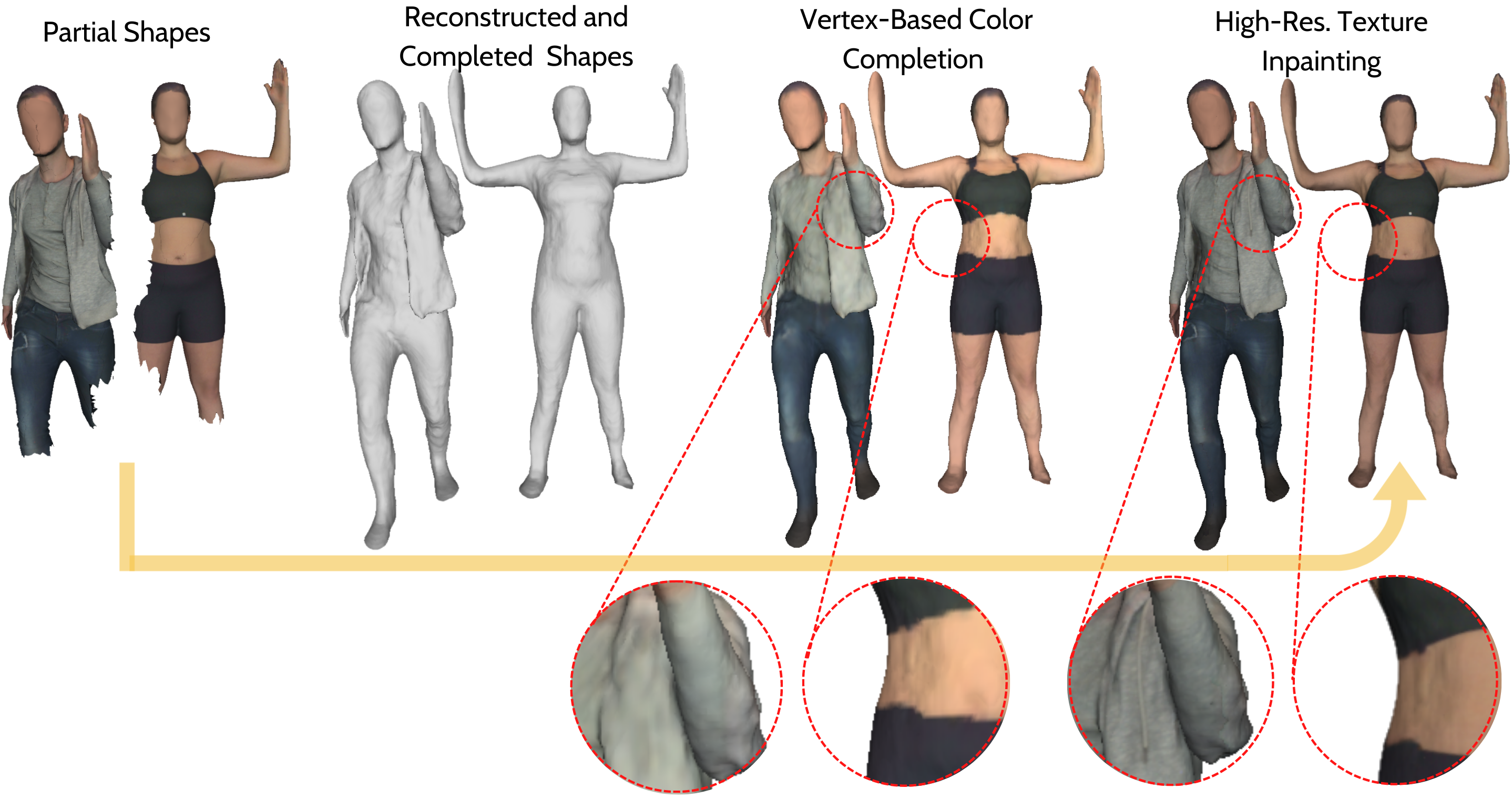

Reconstructing 3D human body shapes from 3D partial textured scans remains a fundamental task for many computer vision and graphics applications -- e.g., body animation, and virtual dressing. We propose a new neural network architecture for 3D body shape and high-resolution texture completion -- BCom-Net -- that can reconstruct the full geometry from mid-level to high-level partial input scans. We decompose the overall reconstruction task into two stages - first, a joint implicit learning network (SCom-Net and TCom-Net) that takes a voxelized scan and its occupancy grid as input to reconstruct the full body shape and predict vertex textures. Second, a high-resolution texture completion network, that utilizes the predicted coarse vertex textures to inpaint the missing parts of the partial 'texture atlas'. A thorough experimental evaluation on 3DBodyTex.V2 dataset shows that our method achieves competitive results with respect to the state-of-the-art while generalizing to different types and levels of partial shapes. The proposed method has also ranked second in the track1 of SHApe Recovery from Partial textured 3D scans (SHARP [38,1]) 2022 challenge1.

翻译:从 3D 部分纹理扫描 重建 3D 人体形状 从 3D 部分纹理扫描 重建 3D 人体形状仍然是许多计算机视觉和图形应用 -- -- 例如身体动画和虚拟敷料 -- -- 的一项基本任务。我们提议为 3D 身体形状和高分辨率纹理完成 -- -- BCom-Net -- -- 建立一个新的神经网络架构,可以将全部几何从中层重建到高级部分输入扫描。我们将总体重建任务分两个阶段——首先,一个联合隐含学习网络(SCom-Net 和 TCom-Net), 将自动扫描和占用网网作为重建完整体形状和预测垂直纹理的输入。第二,一个高分辨率纹理完成网络,利用预测的神经垂直纹理纹理纹理将部分“ Textlas” 缺失的部分部分重新粉饰。我们对 3DbodyTex.V2 数据集进行彻底的实验性评估,显示我们的方法在状态上取得了竞争性的结果,同时向不同类型和部分形状的层次进行一般化。拟议的方法将SHAPR 1 II 1 AR 1 也将SHAR 1 23 1 的第二个轨道上列了SAR 1 。